1. 서론

가. 연구 배경

‘백문(百聞)이 불여일견(不如一見)’이란 말이 있습니다. 말로 듣거나 글로 읽는 것보다 직접 체험해야 확실히 알 수 있다는 뜻이죠. 현장에 직접 가지 않고도 이런 시각적 체험을 할 수 있도록 도와주는 게 바로 시각 매체(Visual Media)입니다. 선사시대 때도 인류는 동굴에 벽화를 그려 성공적인 사냥을 기념했고, 중세의 교회는 스테인드글라스에 신과 성자의 기적을 새겼죠. 르네상스 이후엔 교회 천장을 장식한 벽화와 인쇄매체에 담긴 삽화가 그 역할을 대신했습니다. 그런데 이런 시각 매체는 만드는 사람이 왜곡하거나 조작할 수 있다는 한계가 있었습니다.

19세기 초반 등장한 사진은 시각 매체에 신뢰도를 부여했습니다. 인물이나 사물, 현장, 사건을 있는 그대로 모사(模寫)했기 때문이죠. 그런데 불과 반세기도 안 돼 사진을 조작할 수 있다는 게 알려졌습니다. 그래도 당시엔 사진을 다룰 때 전문적인 지식이 요구됐고, 조작의 위험보단 사진이 주는 생생함과 신뢰도의 가치가 더 컸습니다. 이 때문에 인쇄매체의 삽화는 빠르게 사진으로 대체됐습니다. 이후 시각 매체는 19세기 후반 등장한 영화, 20세기 초 등장한 텔레비전이란 신기술에 힘입어 정보 유통과 콘텐츠 소비의 중심으로 떠올랐습니다.

이처럼 기술 발전은 시각 매체의 위상을 공고하게 만들었지만, 한편으론 신뢰의 위기도 불러왔습니다. 20세기 후반 등장한 디지털 이미지와 인터넷의 확산, 21세기를 전후한 모바일 혁명으로 누구나 손쉽게 사진이나 영상을 조작할 수 있기 때문입니다. 이미 시각 매체 유통의 중심이 텔레비전에서 웹, 다시 소셜 미디어 중심의 모바일로 넘어간 상황에서 조작된 사진이나 영상의 광범위한 유통은 개인의 명예와 사생활을 침해할 수 있을 뿐만 아니라, 사회적 혼란을 초래할 수도 있습니다.

더군다나 최근 딥페이크(Deepfake) 기술의 발전은 사진과 영상 조작의 새로운 장을 열었습니다. 딥페이크는 인공지능, 특히 딥러닝 기술을 사용해 실제 사람의 얼굴과 목소리를 합성하는 기술입니다. 이는 기존의 이미지 위변조 기술보다 훨씬 더 정교하고 현실적인 조작을 가능하게 합니다. 딥페이크 기술은 초기에는 주로 엔터테인먼트와 연구 목적으로 개발됐지만, 최근에는 정치적 프로파간다, 사이버 범죄, 포르노그래피 등 다양한 용도로 악용되고 있습니다.

이미 언론은 사건 현장에서 촬영되고 소셜 미디어로 공유된 영상을 보도에 적극적으로 활용하고 있습니다. 따라서 누군가 의도적으로 딥페이크 등을 통해 조작한 사진이나 영상을 제공할 때 이를 걸러낼 역량을 내부적으로 갖출 필요가 있습니다. 그 역량이 바로 시각 법과학 또는 비주얼 포렌식스(Visual Forensics)입니다. 이는 디지털 포렌식스의 하위 분야로 이미 사법당국과 보안업계 등에서 널리 활용되고 있고, 증거로서의 시각 매체의 신뢰성을 검증하는 데 필수적인 도구로 자리 잡고 있습니다.

나. 연구 목적

본 연구의 목적은 사진과 영상 조작을 일컫는 이미지 위변조와 딥페이크의 개념, 역사, 방법 등을 탐구하고, 이를 식별하고 대응하는 비주얼 포렌식스의 역할과 중요성을 논의하는 겁니다. 이를 통해 언론사가 유통하는 시각 매체의 신뢰성을 높이고, 정보의 왜곡을 통한 개인의 명예·사생활 침해와 사회적 혼란을 방지하는 데 이바지하고자 합니다.

우선, 이미지 위변조와 딥페이크의 정의와 역사를 살펴봅니다. 이를 통해 이러한 기술들이 어떻게 발전해왔고, 어떤 영향을 미치고 있는지를 정리합니다. 또한, 이미지 위변조와 딥페이크의 다양한 방법을 분석해, 각각의 기술적 특징과 한계를 파악합니다.

다음으로, 비주얼 포렌식스의 정의와 역사를 고찰합니다. 비주얼 포렌식스는 이미지 위변조와 딥페이크를 식별하는 데 어떤 역할을 하고 있고, 이를 위해 어떤 방법이 사용되는지 살펴봅니다. 특히, 이미지 분석 도구, 비디오 분석 도구, 인공지능을 활용한 도구 등 다양한 비주얼 포렌식스 도구를 소개하고, 각각의 도구가 어떻게 활용되는지를 설명합니다.

본 연구에서는 또한 비주얼 포렌식스를 활용한 실제 사례를 분석합니다. 이를 통해 비주얼 포렌식스의 실질적인 적용 가능성과 한계를 파악하고, 향후 연구 방향을 제시합니다. 아울러, 비주얼 포렌식스와 팩트체크의 관계를 논의해, 정보의 신뢰성을 확보하는 데 비주얼 포렌식스가 어떤 역할을 할 수 있는지를 제시합니다.

마지막으로, 미국 언론의 비주얼 포렌식스 활용 사례를 분석합니다. 뉴욕 타임스의 시각 탐사보도(Visual Investigations) 팀과 워싱턴 포스트의 시각 법과학(Visual Forensics) 팀 등의 활동을 통해, 언론이 비주얼 포렌식스를 활용하여 어떻게 진실을 밝히고 있는지를 살펴봅니다.

본 연구는 이처럼 시각 매체를 통해 또는 활용해 전달되는 뉴스의 신뢰성을 확보하고, 정보의 왜곡과 혼란을 방지하는 데 필요한 비주얼 포렌식스의 중요성을 강조하고자 합니다. 이를 위해 기술적, 윤리적, 법적 한계도 고찰하고, 이에 대한 대응 방안을 제시합니다. 또한, 비주얼 포렌식스의 발전을 위한 정책적 제언과 향후 연구 방향을 제시해 언론사 내부의 비주얼 포렌식스 역량 축적에 이바지하고자 합니다.

2. 이미지 위변조

가. 정의

이미지 위변조란 사진이나 영상의 이미지를 조작해 원본과 다른 내용을 전달하는 행위를 의미합니다. 이는 이미지의 특정 부분을 삭제하거나 추가하는 것, 색상이나 밝기를 조정하는 것, 여러 이미지를 합성하는 것 등을 포함합니다. 이미지 위변조는 때때로 합법적이고 창의적인 용도로 사용되기도 하지만, 허위 정보나 선전을 목적으로 악용될 때 심각한 문제를 일으킵니다.

이미지 위변조의 주요 목적은 시각적으로 설득력 있는 거짓 정보를 만들어내는 겁니다. 이는 개인이나 단체의 명예를 훼손하거나, 정치적, 사회적 목적을 달성하기 위해 사용될 수 있습니다. 이러한 이유로 이미지 위변조는 신뢰성과 진실성을 중요시하는 사회에서 큰 우려를 낳고 있습니다.

나. 역사

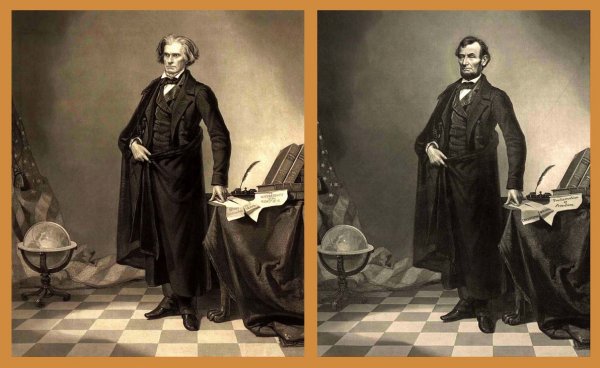

이미지 위변조의 역사는 사진 기술의 발전과 함께 시작됐습니다. 최초의 사진 위변조 사례는 19세기 중반으로 거슬러 올라갑니다. 사진이 19세기 초에 발명됐으니 반세기도 안 된 겁니다.1) 1860년 미국에선 에이브러햄 링컨(Abraham Lincoln)의 사진이 편집된 유명한 사례가 있습니다. 아래 사진은 2차례 부통령을 지낸 존 캘훈(John Calhoun, 1850년 작고)의 판화(1852년 제작)에 링컨의 머리를 합성한 겁니다. 이처럼 초기 사례는 주로 사진의 물리적 조작을 통해 이루어졌습니다.2)

20세기 들어 디지털 기술이 발전하면서 이미지 위변조는 더욱 정교해졌습니다. 특히, 포토샵과 같은 이미지 편집 소프트웨어의 등장으로 누구나 쉽게 이미지를 조작할 수 있게 됐습니다. 이러한 소프트웨어는 이미지의 각 요소를 정밀하게 편집할 수 있는 기능을 제공해 단순한 색상 조정부터 복잡한 합성에 이르기까지 다양한 위변조 기법을 가능하게 했습니다.

디지털 시대의 도래로 이미지 위변조의 양상과 규모도 크게 변화했습니다. 2000년대 이후, 인터넷과 소셜 미디어의 급격한 확산은 위변조된 이미지가 빠르게 퍼질 수 있는 환경을 조성했습니다. 이는 특히 정치적 선전, 허위 뉴스, 사이버 괴롭힘 등에서 위변조된 이미지가 광범위하게 사용되는 결과를 초래했습니다. 최근에는 딥러닝 기술을 이용한 딥페이크가 등장하면서, 이미지 위변조는 새로운 차원으로 발전하게 됐습니다.

다. 방법

이미지 위변조의 방법은 다양하며 기술의 발전에 따라 점점 더 정교해지고 있습니다. 주요 방법으로는 다음과 같은 것이 있습니다.

1) 기초적 조작

19세기 초 사진의 발명 이래로 이미지 조작은 ‘사진 조작(Photography manipulation)’의 형태로 이뤄지기 시작했습니다. 가장 기초적인 방식은 사진을 찍기 위해 ‘연출(Staged Photography)’하거나 ‘사진에 잘못된 제목이나 설명을 붙이는 방식(Mislabeled Photography)’입니다.

2) 기술적 조작

그러나 금세 ‘다른 사진을 오려 붙이거나 이어 붙이는 조작 방식(Spliced Photography)’이 나타났습니다. 앞에서 언급한 1860년 링컨의 사진이 그 예입니다.3) 아울러 공기압으로 도료를 사진에 착색시키는 에어브러쉬가 동원돼 색상 수정이 이뤄지기 시작했습니다. 바로 ‘보정한 사진(Airbrushed Photography)’의 등장입니다.

3) 픽셀 기반 이미지 조작

이미지가 디지털화되면서 기술적 조작도 진화했습니다. ‘픽셀 기반 이미지 조작(Pixel-Based Image Forgery)’의 등장입니다. 이는 디지털 이미지의 원본 픽셀을 위조하거나 조작하는 것을 말합니다.

주요 기법에는 흔히 ‘복사-붙여넣기’라고 하는 ‘복사-이동 이미지 조작(Copy-Move Image Forgery)’, 흔히 ‘합성 사진(Photomontage)’이라고 하는 ‘이미지 접합(Image Splicing)’, ‘특정 부분을 기하학적으로 수정하는 이미지 리샘플링(Image Resampling)’, ‘이미지 수정(Image Retouching)’ 등이 있습니다.

이런 기법은 기본적으로 훼손된 이미지의 복구나 기존 이미지의 수정을 위해 개발됐습니다. 이 과정에서 기존 이미지에 더해지는 새로운 내용은 복구·수정되는 이미지 안이나 참고한 다른 이미지에 있는 픽셀로부터 정보를 보간(Interpolation)해 만들어집니다.

가) 복사-이동 이미지 조작(Copy-Move Image Forgery)

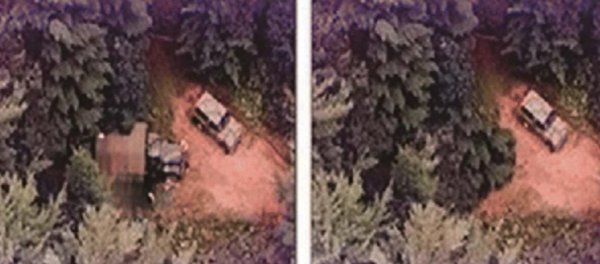

이미지 내 특정 부분을 복사해 같은 이미지 내 다른 곳에 붙여넣는 방식입니다. 복사된 특정 부분을 소스 영역(Source Region), 붙여넣어 만든 부분을 타겟 영역(Target Region)이라고 합니다. 이미지 내 객체를 증가시키거나 특정 부분을 숨기는 데 사용합니다. 아래 사진들은 복사-이동 이미지 조작의 예입니다.

사진 2.에선 트럭을 감추기 위해 옆의 나무를 복사해 트럭 위를 덮었습니다. 4)

사진 3.에선 사진 속 여성 2명을 삭제하기 위해 왼쪽 여성 옆의 숲을 복사해 그대로 붙이거나, 변형해 붙여 여성들을 덮었습니다.5)

나) 이미지 접합(Image Splicing)

두 개 이상의 다른 이미지를 조합해 하나의 이미지로 만드는 기법입니다. 흔히 ‘합성 사진(Photomontage)’이라고도 합니다. 서로 다른 출처의 이미지를 결합해 새로운 내용을 만들거나 서로 다른 상황을 하나로 만드는 데 사용합니다. 연구자에 따라 복사-이동 이미지 조작의 한 부류인 ‘복사-생성 이미지 조작(Copy-Create Image Forgery)’으로 분류하기도 합니다. 세부적으로 경계 기반 접합과 영역 기반 접합 2가지 방식이 있습니다.

(1) 경계 기반 접합(Boundary-Based Splicing)

서로 다른 이미지의 경계 부분을 매끄럽게 연결해 하나의 이미지로 만드는 방식입니다. 이 방식은 경계선을 자연스럽게 처리해 전체 이미지의 일관성을 유지하는 데 중점을 둡니다.

(2) 영역 기반 접합(Region-Based Splicing)

이미지의 특정 영역을 다른 이미지로 대체하는 방식입니다. 전체 이미지의 일관성보다는 특정 영역의 신뢰성에 초점을 맞춥니다.

(3) 이미지 접합 사례

2010년 말레이시아 정치인 제프리 웡 수 엔(Jeffrey Wong Su En)은 당시 영국 여왕 엘리자베스 2세로부터 기사 작위를 받았다는 아래 사진 4.(왼쪽)를 말레이시아 일간지에 실었습니다. 이 사진은 영국의 포뮬러 원 팀 수장인 로스 브론이 대영제국 훈장을 받는 사진에 제프리의 모습을 합성한 것으로 밝혀졌습니다.6) 서로 다른 이미지를 합성해 새로운 내용을 만드는 이미지 접합의 대표적 사례입니다.

다) 이미지 리샘플링(Image Resampling)

이미지 내 특정 부분을 늘리거나 줄이거나 뒤트는 등 기하학적으로 수정하는 것을 말합니다. 각각의 방식은 이미지의 형태나 방향을 변경하는 데 초점을 맞추며 특정 목적에 따라 선택됩니다.7)

(1) 스트레칭과 스케일링

스트레칭(Stretching)은 이미지 전체의 비율을 유지하지 않고, 특정 부분만 늘리거나 줄여서 크기를 조절하는 것을 말합니다. 이와 달리 스케일링은 (Scaling)은 이미지 전체의 비율을 유지하면서 크기를 조절하는 것을 말합니다. 예를 들어 사람의 비율을 유지하면서 크기를 조절하면 스케일링, 사람의 팔만 늘리면 스트레칭이 됩니다.

(2) 로테이션과 플리핑, 스큐잉

로테이션(Rotation)은 이미지를 상하나 좌우의 중심축을 기준으로 90도, 180도, 270도 등으로 회전시키는 것을 말합니다. 하늘을 날고 있는 전투기 사진에서 전투기를 진행 축을 기준으로 뒤집어 배면 비행하듯 바꾸면 로테이션한 게 됩니다.

플리핑(Flipping)은 이미지를 상하나 좌우의 중심축을 기준으로 뒤집는 반전을 말합니다. 자기 모습과 거울에 비친 모습을 생각하면 이해하기가 쉽습니다.

스큐잉(Skewing)은 이미지를 상하나 좌우의 중심축을 기준으로 기울이는 것을 말합니다. 아래 사진 5.와 같이 하늘을 날고 있는 전투기 사진을 복사한 뒤 해당 전투기가 45도 각도로 하강하거나 상승하도록 수정하면 스큐잉 한 게 됩니다.

라) 이미지 리터칭(Image Retouching)

이미지의 작은 부분을 세밀하게 수정하는 기법입니다. 예를 들어 피부 결점을 제거하거나 눈의 색을 바꾸는 것과 같은 작업이 포함됩니다. 세부적으로 에어브러싱, 스킨 스무딩, 색상 보정 등이 있습니다. 이 기법들은 이미지의 세부적인 요소를 개선하거나 수정하는 데 사용됩니다. 일반적으로 사용하는 이미지 리터칭은 부정적 의미의 이미지 조작은 아니나 원칙적으로는 조작에 포함됩니다.

라. 사례

이미지 위변조의 사례는 지난 2세기 동안 다양하게 축적돼왔습니다. 이 가운데 우리와 관련성이 크고, 최신 사례 위주로 몇 가지 살펴봅니다.

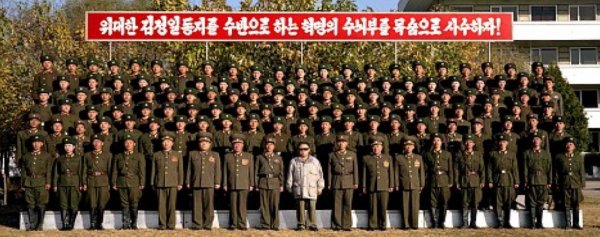

1) 조선민주주의인민공화국

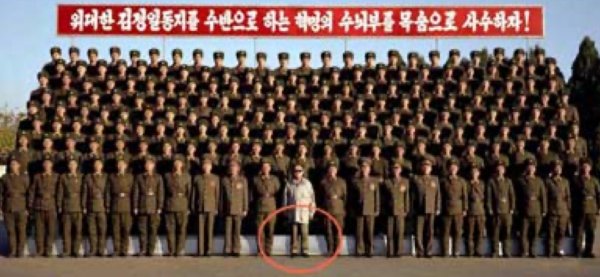

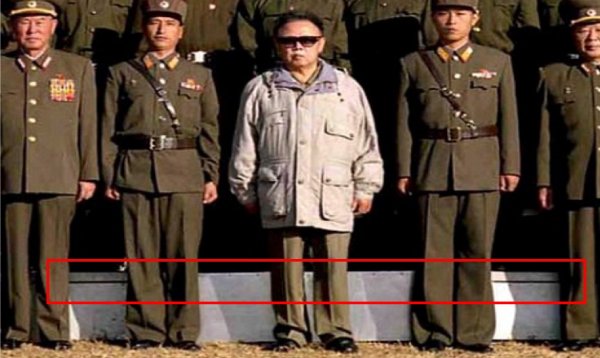

북한의 제2대 최고지도자였던 김정일은 2011년 12월 17일 향년 70세로 숨졌습니다. 이에 앞서 2008년엔 김정일이 뇌졸중으로 쓰러졌다는 보도가 나왔습니다. 같은 해 11월, 북한 조선중앙통신은 아래 사진 6.을 전송했습니다. 김정일이 북한군과 함께한 사진입니다. 대내외적으로 김정일이 건재하단 걸 알리는 게 목적이었다고 추정됩니다. 그런데 이 사진은 위조 논란이 있습니다. 김정일의 다리 쪽을 살펴보면 알 수 있습니다.

사진 6.을 확대한 아래 사진 7.에서 김정일과 양옆 군인의 그림자는 각도와 길이가 다릅니다. 양옆 군인의 그림자는 사선으로 떨어집니다. 반면, 김정일의 그림자는 수직으로 떨어집니다. 게다가 군인들의 다리를 지나가는 검은 선이 김정일 주위에서만 사라집니다.8) 조선중앙통신이 같은 시기 배포한 사진 8.9)도 마찬가지입니다. 사진 8.을 확대한 사진 9.에선 김정일과 양옆 군인의 그림자 각도와 길이가 비슷합니다. 그렇지만, 사라진 검은 선은 살리지 못했습니다. 사진 6.과 사진 8. 모두 북한군 단체 사진에 김정일의 이미지를 합성한 것으로 추정됩니다.

북한 조선중앙통신은 최고지도자의 건강 문제뿐만 아니라 재난 상황에서도 위변조 사진을 전송했습니다. 아래 사진 10.은 2011년 7월 폭우 당시 평양 대동강 변입니다. 여기선 흙탕물 때문에 그림자로 위변조를 식별하긴 힘듭니다. 다만, 물이 허리춤 가까이 차올랐는데, 물속을 걷는 사람들의 바지는 물에 젖지 않았습니다.10) 사진이 조작된 증거입니다.

북한의 제3대 최고지도자 김정은도 건강 이상설이 계속 제기됩니다. 종종 두문불출, 공식 석상에 얼굴을 비추지 않을 때도 있습니다. 새삼스럽게 헌법도 개정하기로 한 북한에서 16년 전 김정일의 칩거나 13년 전 김정일의 사망 같은 상황이 발생했을 때 조선중앙통신이 어떤 사진이나 영상을 전송하는지 주의 깊게 관찰할 필요가 있습니다.

2) 대한민국

국내에서 위변조된 이미지는 주로 온라인 커뮤니티 게시판이나 소셜 미디어를 통해 유포됩니다. 아래 사진 11.는 2020년 1월 30일 정부서울청사에서 열린 코로나19 대응 종합 점검 회의에 앞서 국기에 경례하는 모습입니다. 원본사진에선 문재인 당시 대통령이 오른손을 왼쪽 가슴에 대고 경례했습니다. 그러나 일부 온라인 커뮤니티 게시판이나 소셜 미디어에선 문 대통령이 왼손을 오른쪽 가슴에 대고 경례하는 사진으로 바뀌어 유포됐습니다. 이에 청와대는 같은 해 3월 5일 홈페이지에 원본을 게시하며 유포된 사진이 조작됐다고 알렸습니다.11)

2021년 1월엔 당시 문재인 대통령의 신년 기자회견 모습을 조작한 사진 12.도 유포됐습니다.12) 조작된 사진에선 문 대통령 앞 모니터에 “대통령님, 말문 막히시면 원론적인 답변부터 하시면서 시간을 끌어보십시오”라는 문구가 보입니다. 반면, 원본인 연합뉴스의 사진 13.엔 질문한 기자의 소속과 이름, 질문 내용이 적혀 있습니다.13)

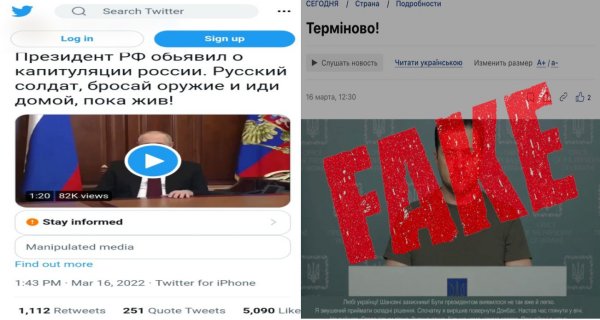

3) 러시아-우크라이나 전쟁에서 일어난 미디어 스푸핑

2022년 2월 24일 러시아가 우크라이나를 침공하면서 전쟁이 시작됐습니다. 이 전쟁은 광범위한 피탄과 살상이 특징인 현대전의 특성상 과거 전쟁보다 취재가 더 제한됐습니다. 이 때문에 전통적인 종군 취재 대신 소셜 미디어가 뉴스의 소스로 떠오르며 정보 전파의 중심이 됐습니다.

미디어 측면에서 소셜 미디어를 통한 정보 전파는 진위 확인의 중요성을 더 강조하게 했습니다. 우크라이나 군이 선전 목적으로 만들어낸 ‘키이우의 유령’과 같은 조작된 정보가 사실처럼 퍼지고, 정치·군사적 목적은 물론 클릭 수와 광고비를 노리는 경제적 목적으로 조작한 영상을 퍼뜨리는 소셜 미디어 참여자가 급증했기 때문입니다.

소셜 미디어 참여자 가운데 여론 조작을 목적으로 이미지를 위변조하는 세력은 대중을 효과적으로 속이기 위해 언론인이나 언론사로 위장해 위변조 이미지를 퍼뜨리기도 합니다. 이른바 미디어 스푸핑(Media Spoofing)입니다.

가) 도이치벨레 사칭한 반우크라이나 선전 영상

아래 사진 14.는 2022년 6월 트위터의 @nanpinQD 계정이 올린 영상입니다.14) 우크라이나 난민인 페트로 사브첸코가 술집에서 만난 여성들을 불법 촬영한 뒤 몇 달 동안 협박하다 독일 경찰에 체포됐다는 내용입니다. 영상엔 독일의 국제방송 도이체 벨레(Deutsche Welle)의 워터마크(DW)까지 찍혀 있습니다. 그러나 도이체 벨레는 이런 영상을 만든 적이 없고. 독일 경찰도 이런 사건을 알지 못한다고 도이체 벨레에 답했습니다.15)

나) BBC 사칭한 크라마토르스크 폭격 관련 영상

2022년 4월 8일 러시아는 우크라이나 동부 크라마토르스크의 한 기차역에 미사일을 쐈습니다.16) 목표 지점 상공에서 자탄이 비처럼 쏟아진다는 이른바 ‘강철비’, 집속탄입니다. 공격은 50명 이상의 목숨을 앗아갔습니다. 그런데 온라인에선 우크라이나가 미사일을 쐈다는 영상이 돌기 시작했습니다. 영상엔 BBC의 워터마크가 찍혀 있었습니다. 우크라이나 군이 자국민을 향해 쐈다는 텍스트도 첨부됐습니다. 해당 영상은 50만 회 이상 조회됐습니다.

BBC는 즉각 대응했습니다. 아래 사진 15.처럼 해당 영상이 가짜라고 밝히며 온라인 공간에서 삭제에 나섰습니다.17) 독일의 바이에른 방송(BR24)은 해당 영상이 영어는 물론 독일어, 이탈리아어, 스페인어, 카탈루냐어, 인도어, 프랑스어로 공유됐다고 보도했습니다.18) 조직적인 캠페인의 흔적입니다.

3. 딥페이크

가. 정의

딥페이크(Deepfake)는 “딥러닝(Deep Learning)”과 “페이크(Fake)”의 합성어19)로, 인공지능(AI) 기술을 이용해 실제와 거의 구분할 수 없을 정도로 정교한 가짜 이미지나 영상을 생성하는 기술을 말합니다.

딥페이크는 생성적 적대 신경망(GAN, Generative Adversarial Network)을 이용해 만들고, 얼굴 합성, 음성 합성, 움직임 모방 등 다양한 형태로 구현됩니다. 이 기술은 엔터테인먼트, 광고, 교육 등의 분야에서 유용하게 사용할 수 있지만, 동시에 정치적 선전, 사기, 포르노그래피 등의 부정적인 목적으로도 악용될 수 있는 잠재력을 가지고 있습니다.

나. 역사

인공 지능(Artificial Intelligence, AI)과 기계 학습(Machine Learning, ML)의 발전은 생성적 적대 신경망(Generative Adversarial Networks, GAN)을 낳았습니다. 최근 이미지 조작의 트렌드인 딥페이크를 만들어내는 신경망이 GAN입니다.

GAN의 개념을 처음 제시한 사람은 2014년 캐나다 몽헤알 대학교(Université de Montréal, 몬트리올 대학교)에서 갓 박사학위를 땄던 아이언 굿펠로우(Ian Goodfellow)입니다. 그해 4월 박사학위 논문 디펜스를 마친 그는 두 달 뒤 지도교수 등 공저자들과 함께 ‘생성적 적대 신경망(Generative Adversarial Nets, 이하 GAN)’이란 제목의 논문20)을 발표합니다.

굿펠로우는 이 논문에서 자신이 제안한 GAN이 기존 모델보다 어떤 점에서 효과적인지 밝힙니다. GAN은 기계 학습의 한 방식으로 생성 모델과 판별 모델, 두 개의 신경망이 서로 대립하는 형태로 작동합니다. 생성 모델은 실제 데이터와 유사한 새로운 데이터를 만들려고 시도하고, 판별 모델은 생성 모델이 만든 데이터가 진짜인지 생성 모델이 만든 가짜인지 구별하려고 합니다. 이 과정에서 생성 모델과 판별 모델을 동시에 경쟁적(적대적)으로 학습시키기 때문에 복잡한 확률 계산이 필요한 기존 모델들보다 학습 과정이 단순합니다. 또, 기존 모델은 생성물이 실제와 근사한지 판단하고, 생성물이 실제와 근사하도록 매개변수를 업데이트하는 추론 과정이 필요하지만, GAN은 이런 훈련 중 추론 과정이 필요 없고, 그만큼 효율적입니다.

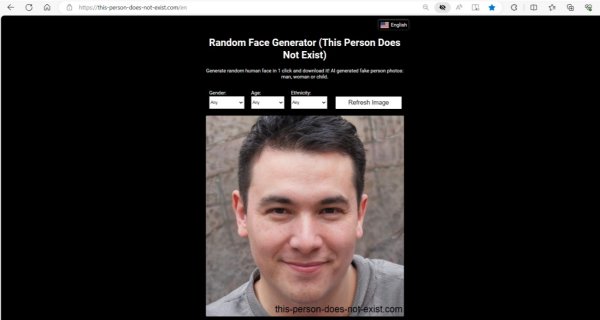

GAN의 작동방식을 비유하자면, 생성 모델은 위조 화폐를 만들어 적발되지 않고 사용하려는 범죄 집단이고, 판별 모델은 위조 화폐를 적발하려는 공권력입니다. 두 모델의 경쟁은 두 모델 모두 자신들의 방법을 개선하도록 이끕니다. 결국, 생성 모델은 정부가 발행한 화폐와 구별할 수 없을 정도로 정교하게 위조 화폐를 만들어냅니다.21) 사진 16.처럼 높은 수준의 현실성을 가진 이미지와 비디오, 오디오, 그리고 이들이 결합한 딥페이크가 만들어지는 원리입니다.

다. 사례

1) 푸틴 딥페이크 영상

아래 사진 17.은 2022년 3월 트위터의 @sternenko 계정이 올린 러시아 대통령 푸틴의 영상입니다.22) “러시아 연방 대통령이 러시아의 항복을 발표했다. 러시아 군인이여, 살아 있을 때 무기를 버리고 집으로 돌아가라!”라는 제목입니다. 이 영상에서 푸틴은 “우크라이나 측과 협상에 성공했다”라며 “우크라이나 내 공화국으로서 크림반도의 독립을 회복하기 위한 5개년 로드맵에 서명했다”라고 말했습니다. 그런데 독일의 국제방송인 도이치벨레는 이 영상에 사용된 푸틴의 얼굴과 목소리가 조작됐다고 밝혔습니다. 같은 해 2월 21일 공개된 푸틴의 대국민 연설 장면23)을 기반으로 인공지능 프로그램을 활용해 목소리와 입의 움직임을 조작했다고 설명했습니다.24)

2) 젤렌스키 딥페이크 영상

우크라이나 대통령 젤렌스키도 딥페이크 공격의 표적이 됐습니다. 해당 영상은 젤렌스키가 우크라이나 병사들에게 무기를 내려놓고 러시아에 항복하라고 말하는 내용입니다. 이 영상은 소셜 미디어로 유포됐고, 우크라이나24 방송사의 웹사이트에도 게시됐습니다. 이후 해킹 사실을 파악한 우크라이나24는 사진 18.처럼 해킹 사실을 알리고 해당 영상을 삭제했습니다.25)

라. 이미지 위변조와 딥페이크의 관계

이미지 위변조와 딥페이크는 본질적으로 시각 매체(Visual Media)를 조작한다는 점에서 유사하지만, 기술적 접근 방식과 그 결과물에는 차이가 있습니다.

1) 기술적 접근 방식의 차이

가) 이미지 위변조: 전통적인 이미지 위변조는 주로 포토샵과 같은 이미지 편집 소프트웨어를 사용하여 수작업으로 이뤄집니다. 이는 사용자가 직접 이미지를 수정하거나 여러 이미지를 합성하는 과정을 포함합니다.

나) 딥페이크: 딥페이크는 인공지능, 특히 딥러닝 기술의 일종이 생성적 적대 신경망(GAN)을 사용해 이미지를 생성하거나 조작합니다. 이 과정은 인간의 개입 없이 자동으로 이뤄질 수 있습니다.

2) 결과물의 차이

가) 이미지 위변조: 위변조된 이미지의 정교함은 조작하는 사람의 숙련도에 달려 있습니다. 아마추어가 이미지를 위변조하면 정교함이 떨어지는 이른바 ‘Cheap Fake’ 수준의 결과물이 나오지만, 숙련된 기술자는 ‘Deep Fake’ 수준의 현실적인 이미지를 만들어낼 수 있습니다.

나) 딥페이크: 딥페이크가 만든 생성물의 정교함은 얼마나 발전된 생성적 적대 신경망( GAN)을 사용하느냐에 달려 있습니다.

<참고> 생성적 적대 신경망의 발전과 이미지 생성용 주요 변형 모델

1. GAN(Original GAN, 2014)

아이언 굿펠로우 등이 제안한 초기 모델로, 생성자(Generator)와 판별자(Discriminator) 네트워크가 서로 경쟁하며 학습하는 구조로 되어 있습니다.

2. DCGAN (Deep Convolutional GAN, 2015)

깊은 합성곱 신경망(Deep Convolutional Neural Networks)을 GAN에 통합해 이미지 생성 성능을 크게 향상한 모델입니다. 이미지 생성 작업에 주로 사용하며, 합성곱 레이어를 사용해 높은 품질의 이미지를 생성합니다.

3. SRGAN (Super-Resolution GAN, 2017)

저해상도 이미지를 고해상도 이미지로 변환하는 모델입니다. 주로 이미지 복원 작업에 사용하며, 높은 해상도의 이미지를 생성할 수 있습니다.

4. CycleGAN (2017)

두 개의 서로 다른 도메인 간 이미지 변환을 학습하는 모델입니다. 예를 들어, 주간의 이미지를 야간의 이미지로 변환하는 작업에 사용됩니다.

5. BigGAN (2018)

대규모 데이터셋에서의 이미지 생성 성능을 극대화하기 위해 설계된 GAN 모델입니다. 큰 배치 크기와 다양한 기법을 사용하여 높은 품질의 이미지를 생성할 수 있습니다.

6. StyleGAN (2018, 2019)

스타일 트랜스퍼 기법을 GAN에 적용하여 고해상도 얼굴 이미지를 생성하는 모델입니다. 스타일 공간(Style Space)을 통해 이미지의 세부 요소들을 조작할 수 있습니다.

7. StarGAN (2018)

다중 도메인 간 이미지 변환을 가능하게 하는 모델입니다. 단일 모델이 여러 도메인 간의 변환을 학습할 수 있어, 매우 유연한 이미지 변환을 지원합니다.

8. SAGAN (Self-Attention GAN, 2019)

이미지의 세부 정보를 더 잘 포착할 수 있게 합니다. 이는 고해상도 이미지 생성에 매우 유용합니다.

9. GauGAN (2019)

사용자가 간단한 스케치를 통해 사실적인 풍경 이미지를 생성할 수 있게 하는 모델입니다. 생성된 이미지의 디테일과 품질이 매우 높아 예술적 창작에 활용될 수 있습니다.

식별 및 대응 방식의 차이

이미지 위변조: 이미지 위변조는 대부분 이미지의 픽셀을 조작해 이뤄지기 때문에 픽셀 관련 비주얼 포렌식스 기법이 주로 동원되고, 메타데이터 분석도 함께 이뤄집니다.

딥페이크: 딥페이크는 개별 픽셀은 물론 전체 영상을 생성할 수 있어서 픽셀 관련 비주얼 포렌식스 기법으로 식별이 어려울 수 있습니다. 이 때문에 딥페이크를 만든 생성적 적대 신경망(GAN)이나 딥페이크를 만들 때 활용하는 합성곱 신경망(CNN) 기술을 역이용해 이미지를 분석해야 합니다. 따라서 딥러닝 기반의 식별 모델을 주로 사용합니다.

4. 비주얼 포렌식스

가. 정의

1) 정의와 유사 개념

비주얼 포렌식스(Visual Forensics)는 디지털화된 사진과 영상 등 시각 매체(Digital Visual Media)를 분석해 위변조 여부를 식별하고, 진위를 판단하는 과학적 기법을 의미합니다. 이는 사진과 영상의 디지털 흔적을 추적하고, 조작의 흔적을 발견하며, 원본과 조작된 부분을 구분하는 과정을 포함합니다.

비주얼 포렌식스는 사법당국이나 보안업계에서 널리 활용하고 있는 디지털 포렌식스(Digital Forensics)의 하위 분야로 디지털 비주얼 미디어 포렌식스(Digital Visual Media Forensics, 디지털 시각 매체 법과학)라고도 불립니다. 주로 수사 과정에서 수집되거나 민·형사 재판에 제출된 디지털 콘텐츠의 진위와 무결성을 검증하고, 분석하는 데 활용됩니다. 여기서 디지털 콘텐츠는 사진이나 영상 같은 시각 매체이고, 종종 오디오와 결합해 있습니다. 그 과정은 이미지 증거의 수집과 복구, 개선, 비교와 인증, 해석과 평가로 이뤄집니다.26)

비주얼 포렌식스의 유사·인접 개념은 크게 4가지입니다. 디지털 콘텐츠가 등장하기 전부터 사진의 진위와 조작 여부를 판별해왔던 포토 포렌식스(Photo Forensics), 여기에 타임라인 분석이 더해진 비디오 포렌식스(Video Forensics), 디지털 콘텐츠가 등장하면서 그래픽 분석이 추가된 이미지 포렌식스(Image Forensics), 녹음의 진위와 무결성을 검증하는 오디오 포렌식스(Audio Forensics)가 있습니다. 비주얼 포렌식스는 이 4가지 법과학의 기법을 모두 사용한다.

2) 기술적 배경

비주얼 포렌식스는 복잡하고 다양한 기술의 집합체입니다. 이 분야는 디지털 이미지와 비디오, 오디오 콘텐츠의 진위를 판별하고, 조작 여부를 탐지하는 데 필요한 기술을 포함합니다. 이러한 기술은 컴퓨터 과학과 디지털 신호 처리, 데이터 분석, 그리고 기계 학습과 같은 분야에서 파생됩니다.

가) 디지털 신호 처리

디지털 이미지와 비디오, 오디오의 신호를 분석하고, 수정, 개선하는 기술입니다. 노이즈 제거와 해상도 향상, 신호 복원 등을 포함합니다.

나) 이미지 분석

디지털 이미지의 픽셀, 메타데이터, 색상 프로파일 등을 분석하여 조작 여부를 탐지하는 기술입니다. 이미지의 출처와 생성 날짜 및 시간, 수정 여부 등을 확인하는 데 사용됩니다. 위조된 이미지는 종종 압축 오류, 비정상적인 픽셀 배열, 색상 불일치 등의 흔적(시각적 아티팩트)을 남깁니다.

다) 비디오 분석

프레임 단위 분석과 움직임 탐지, 타임라인 분석 등을 통해 비정상적인 패턴을 탐지해 비디오의 진위를 판단하는 기술입니다.

라) 오디오 분석

음성 인식과 소리의 주파수 분석, 음성의 타임라인 확인 등을 통해 오디오 파일의 진위와 조작 여부를 판단하는 기술입니다.

딥페이크를 만드는 생성적 적대 신경망은 이미지를 처리하거나 생성하기 위해 합성곱 신경망(Convolutional Neural Networks, CNN)을 사용합니다. 여기서 CNN은 이미지의 특징을 학습해 패턴을 인식하고 분류하는 데 사용하는 신경망입니다. 복사-이동 이미지 위조에 동원된 나무, 전투기 등 사물을 인식해 그림 내에서 같은 패턴을 찾아내고, 반대로 비슷한 패턴이 있어야 하는데, 없거나 튀는 패턴을 찾아냅니다.

나. 역사

비주얼 포렌식스의 역사는 디지털 기술의 발전과 밀접하게 연관되어 있습니다. 디지털 사진과 영상 기술이 도입되면서, 이들의 조작과 위변조를 식별하기 위한 기술적 노력으로 시작됐습니다.

1) 아날로그 시대

초기 포렌식스는 주로 아날로그 사진과 필름을 대상으로 했습니다. 이 시기에는 물리적 검증과 화학적 분석이 주된 방법이었습니다. 예를 들어, 사진의 필름을 분석하여 원본 여부를 확인하거나, 화학적 성분을 검사하여 위변조를 탐지했습니다.

2) 디지털 사진의 도입

20세기 후반 디지털카메라가 상용화되면서, 디지털 사진의 분석이 중요한 과제로 떠올랐습니다. 포토샵과 같은 이미지 편집 소프트웨어의 등장으로 디지털 이미지 조작이 일반화됐기 때문입니다. 이 시기에는 이미지의 픽셀 구성, 메타데이터 분석 등이 주요 방법으로 사용됐습니다.

3) 인터넷과 소셜 미디어의 확산

2000년대 이후, 인터넷과 소셜 미디어의 급격한 확산은 이미지와 영상의 유통을 폭발적으로 증가시켰습니다. 이는 비주얼 포렌식스의 중요성을 더욱 부각했습니다. 이미지의 출처 추적, 유포 경로 분석 등이 중요한 과제로 떠올랐습니다.

4) 딥러닝과 AI 기술의 발전

2010년대 중반부터 딥러닝과 인공지능 기술의 발전은 비주얼 포렌식스에 새로운 가능성을 열었습니다. GAN과 같은 기술을 이용한 딥페이크의 등장으로 더욱 정교한 분석 기법이 필요해졌습니다. 동시에, AI를 활용한 조작 탐지 모델이 개발되기 시작했습니다.

다. 절차와 방법

비주얼 포렌식스는 데이터 무결성을 유지하면서도 정확하고 신뢰할 수 있는 분석 결과를 제공하기 위해 단계적인 접근 방식을 따릅니다.

1) 표준 절차

비주얼 포렌식스를 수행할 때 행해지는 표준 절차를 관련 논문을 바탕으로 정리했습니다. 표준 절차는 증거 수집과 보존, 증거 인증, 증거 개선, 증거 식별, 증거 해석의 순으로 이뤄집니다.

가) 증거 수집과 보존(Evidence Collection and Preservation)

(1) 증거 수집(Evidence Collection)과 복구(Recovery/Repair)

비주얼 포렌식스 실무는 소스 장치(CCTV 같은 감시 카메라, 경찰 대시캠 또는 바디캠, 가정용 비디오카메라 또는 캠코더, 휴대 전화 등)의 저장 매체(광학 디스크 또는 플래시 드라이브, 자기 하드 디스크 드라이브)에서 증거를 수집하는 것으로 시작됩니다.27)

소스 미디어 또는 장치가 손상됐을 때 증거를 보전하기 위해 적절하게 복구하거나 수리해야 할 수도 있습니다. 저장 매체 또는 소스 장치를 훼손하는 주요 원인은 열, 남용, 일상적인 마모, 녹음 시점의 환경 조건 또는 가해자의 의도적인 파괴 등이며, 증거 복구의 성공 여부는 저장 매체 또는 장치의 손상 상황과 정도에 따라 다릅니다.

(2) 증거 보존(Evidence Preservation)

수집된 데이터의 정확한 복제본을 생성합니다. 이는 원본 데이터의 무결성을 보장하기 위함입니다. 또, 원본 데이터는 변경되지 않도록 보호합니다. 이때 쓰기 방지 도구를 사용할 수 있습니다. 수집된 데이터와 그 복제본은 안전한 장소에 보관합니다. 이 모든 절차와 단계는 문서로 만들어져야 하고, 이는 후속 조사와 법적 절차에서 중요한 역할을 합니다.

나) 증거 인증(Evidence Authentication)

증거 인증은 수집된 자료가 원본이며, 변경되지 않았고, 신뢰할 수 있는 출처에서 온 것인지 확인합니다. 이를 위해 크게 2가지 질문에 답변을 낼 수 있어야 합니다.

a. 이 사진 또는 비디오는 어디서 왔나?

b. 이 사진 또는 비디오는 획득 후 어떻게 처리됐나?

질문 a.는 증거의 출처와 관련이 있고, 질문 b.는 증거의 내용 인증과 관련있습니다. 시각적 증거를 유효하게 검증하려면 먼저 출처를 확인한 다음 그 내용을 인증해야 합니다.

증거 출처나 내용을 인증하려면 디지털 이미지나 비디오에 남은 흔적을 살펴야 합니다. 디지털 이미지나 비디오를 다루는 모든 작업은 흔적을 남기기 때문이다. 이는 “모든 접촉은 흔적을 남긴다”라는 과학수사의 금언인 로카르의 교환 법칙과 같습니다.28)

(1) 증거 출처(Evidence Provenance)

증거 출처는 분석 대상인 디지털 이미지 또는 비디오가 어떤 장치를 통해 녹화됐는지를 확인하고, 조사관이나 법과학 분석가가 허가한 것 외에는 어떤 인증되지 않은 작업도 하지 않았음을 확인하는 과정입니다. 여기서 이미지나 비디오를 녹화한 특정 장치를 확인하는 과정을 촬영 장치 식별(Source Camera Identification, SCI)이라고 합니다.

이미지나 비디오를 만들어낼 때 각 프로세스의 구성 요소는 결과물에 독특한 흔적을 남깁니다. 마치 지문이나 총기의 강선과 같습니다. 대표적인 예가 센서 노이즈입니다. 센서 노이즈 패턴은 카메라마다 다르지만, 특정 카메라로 녹화된 모든 콘텐츠에서 일관되게 나타납니다. 이를 확인하면 어떤 촬영 장치로 이미지나 비디오를 녹화했는지 파악할 수 있습니다.

(2) 내용 인증(Content Authentication)

이미지나 비디오의 출처가 확인되면, 다음 단계는 내용을 인증해야 합니다. 내용 인증은 녹화된 시점부터 인증을 위해 제시될 때까지 조작되지 않았는지 확인하는 겁니다. 디지털 이미지나 비디오에서 조작을 감지하는 데 도움이 되는 법의학적 기술은 일반적으로 위조 감지 기술로 통칭합니다.

생성된 디지털 이미지나 비디오에 적용되는 모든 조작은 후반 작업(Post Production)으로 간주합니다. 이런 모든 조작은 디지털 콘텐츠의 기본 특성에 영향을 미치고 구성을 변경합니다. 이 때문에 조작된 이미지나 비디오는 원본의 일반적인 특성과 다른 특징을 갖습니다. 이러한 차이와 특징은 제작 후 수정된 콘텐츠를 원본 콘텐츠와 구별할 수 있는 흔적으로 간주합니다.

다) 증거 개선 (Evidence Enhancement)

증거 개선은 복구된 디지털 미디어(이미지, 비디오, 오디오)의 품질을 개선해 분석이나 법정에서 더 명확하고 유용하게 사용할 수 있도록 하는 과정입니다. 대부분 사건에서 고품질 사진이나 비디오 녹화가 제공되지 않기 때문입니다. 증거 인증에서 언급한 후반 작업 기법 일부가 증거 개선 기법으로 활용됩니다. 법정에서 일반적으로 승인된 기법은 대비와 밝기 조절, 색상 보정, 노이즈 제거, 가혹한 조명 개선, 첨예화, 비디오 안정화, 프레임 속도 조정, 마스킹 또는 블러, 확대와 자르기가 포함됩니다. 잔상과 자막, 타임 코드에 대응하기 위한 이미지 재구성이 사용될 때도 있습니다.29)

(1) 이미지 개선

(가) 대비와 밝기 조절(Contrast and Brightness Adjustments)

이미지나 비디오의 가시성 향상이 목적입니다. 어두운 부분이나 과도하게 밝은 부분의 밝기를 조정합니다.

(나) 색상 보정(Color Correction)

색상의 정확성과 균형 개선이 목적입니다. 색온도를 조정하거나 색상의 균형을 맞춥니다.

(다) 노이즈 감소(Noise Reduction)

이미지나 비디오에서 원치 않는 노이즈를 제거하거나 줄이는 게 목적입니다.

(라) 가혹한 조명 개선(Harsh Lighting Enhancement)

극단적으로 어둡거나 밝은 조명 조건 아래 촬영된 이미지와 비디오의 품질을 개선하는 게 목적입니다.

(마) 첨예화(Sharpening)

선명도 향상이 목적이고, 불분명한 객체나 텍스트를 명확하게 합니다.

(바) 영상 안정화(Video Stabilization)

비디오의 흔들림이나 불안정한 움직임을 제거하는 게 목적입니다. 주로 핸드헬드로 촬영해 흔들리는 영상에 많이 사용합니다.

(사) 프레임 속도 조절(Frame Rate Adjustment)

비디오의 부드러운 재생을 보장하는 게 목적입니다. 표준 프레임 속도인 초당 30프레임으로 조정합니다.

(아) 마스킹 또는 블러(Masking or Facial Blur)

개인정보와 민감정보를 가리는 게 목적입니다. 신원 보호가 필요한 얼굴이나 번호판 등을 처리할 때 씁니다.

(자) 확대와 자르기(Zooming & Cropping)

중요한 부분을 강조하거나 불필요한 부분을 제거하는 게 목적입니다.

(차) 이미지 재구성(Image Reconstruction)

모션 블러를 보정하거나 자막, 타임 코드 추가 또는 삭제하는 게 목적입니다.

(카) 프레임 복원(Frame Restoration)

손상되거나 빠진 비디오 프레임을 복원하는 게 목적입니다.

(2) 오디오 개선

(가) 음질 향상

배경 잡음 제거, 볼륨 조정, 음향 효과 최적화 등을 통해 오디오의 청취 품질을 향상하는 게 목적입니다.

(나) 음성 분리

다양한 음성을 구분하는 게 목적이고, 중요한 대화나 소리를 강조합니다.

라) 증거 식별(Evidence Identification)

증거가 인증되고, 개선되면 이미지나 비디오에서 시각화된 객체를 조사하고 식별해야 합니다. 이를 위해 객체 탐지(Object Detection), 객체 추적(Object Tracking), 객체 강조(Object Highlighting)와 같은 작업을 수행합니다.

객체 탐지는 이미지나 비디오에 묘사된 사람(피해자, 목격자 또는 용의자) 또는 물체(이름표, 차량 번호판, 거리와 건물 이름, 집 번호 등)를 확인하기 위해 수행되는 조사입니다.

또한 객체 탐지와 추적, 강조를 위한 식별 기술로는 하나의 얼굴 이미지를 다른 얼굴 이미지와 비교하는 얼굴 매핑, 이미지나 비디오 안에서 사람이나 물체의 크기를 재는 사진 또는 비디오 측량술(Photogrammetry or Videogrammetry)과 같은 객관적 조사 방법, 보행 분석이나 행동 패턴 분석과 같은 주관적 조사 방법을 활용합니다.

마) 증거 해석(Evidence Interpretation)

마지막 단계는 증거 해석입니다. 통상 시각적 증거는 스스로 모든 내용 설명하게 두는 경향이 있습니다. 그러나 이런 경향은 가끔 잘못된 해석을 하게 만듭니다. 2003년 10월 플로리다에선 보모가 아동 학대 혐의로 기소됐습니다. 클라우디아 무로(Claudia Muro) 사건입니다. 당시 재판에선 무로가 다섯 살 아기를 격렬하게 흔드는 모습이 담겨 있었습니다. 배심원단은 이 증거가 “매우 명백하다”라고 판단했고, 무로는 유죄 판단을 받았습니다.

2006년 3월 재개된 재판에서 해당 영상에 대한 법과학적 분석이 이뤄졌고, 해당 영상이 초당 5.5 프레임으로 녹화됐다는 사실이 밝혀졌습니다. 통상 초당 24프레임에서 30프레임인 영상에 비해 5.5프레임으로 녹화된 영상은 부드러운 움직임도 격렬하게 녹화하는 문제가 있습니다. 이 발견으로 29개월 동안 감옥에 있었던 무로는 무죄 판단을 받았습니다.

이 사례는 스스로 얘기하는 이미지와 비디오 증거에 대해서도 반드시 법과학적 분석에 기반한 해석이 필요하다는 점을 시사합니다.30)

2) 이미지 위변조 식별 방법

증거 인증 절차에서 주로 활용하는 이미지 위변조 식별 방법을 별도로 정리했습니다.

가) 메타데이터 분석

이미지 파일에 포함된 메타데이터를 분석해 촬영 시간, 장소, 카메라 정보 등을 확인합니다. 조작된 이미지는 메타데이터가 수정되거나 비정상적인 값을 포함할 수 있습니다.

나) 픽셀 분석

디지털 사진이나 영상은 픽셀이 모여 구성된 한 장의 이미지나 여러 장의 이미지로 구성된다는 공통점이 있습니다. 따라서 이미지 내 특정 픽셀과 주위 픽셀을 함께 분석하면 해당 픽셀이 인위적으로 수정, 합성됐는지 판단할 수 있습니다. 이런 작업은 대부분 전용 소프트웨어를 통해 이뤄집니다.

다) 경계와 윤곽 분석

이미지의 경계선이나 사람, 사물의 윤관석을 분석해 불규칙한 경계선이나 인위적인 흔적, 자연스럽지 않은 윤곽선을 찾아냅니다. 이는 이미지 합성이나 삭제 흔적 등 조작을 밝히는 데 유용합니다.

라) 움직임 분석

연속적인 이미지나 영상에서 사람이나 사물의 움직임을 분석해 일관성을 확인합니다. 조작된 이미지는 일관성 없는 패턴을 보일 수 있습니다.

마) 반사 및 그림자 분석(광원 일관성 검사)

이미지 내의 광원 위치와 반사, 그림자의 일관성을 분석하여 조작 여부를 판단합니다. 광원의 일관성이 맞지 않으면, 이미지가 조작되었을 가능성이 큽니다.

3) 딥페이크 식별 방법

딥페이크 식별은 일반적인 이미지 위변조 식별보다 더욱 정교한 기술적 분석이 필요합니다. 이런 기법은 대부분 전용 소프트웨어를 통해 이뤄집니다. 다음은 증거 인증 과정에서 활용할 수 있는 딥페이크 식별 방법을 정리했습니다.

가) 심층 학습(Deep Learning) 기반 모델

(1) CNN 기반 분석

합성 영상의 세부 패턴을 분석하기 위해 합성곱 신경망(CNN)을 활용합니다. CNN은 이미지의 미세한 패턴을 학습하여 딥페이크 여부를 판단할 수 있습니다.

(2) GAN 탐지 모델

생성적 적대 신경망(GAN)이 생성한 이미지를 탐지하기 위해 GAN 탐지 전용 모델을 개발합니다. 이는 GAN이 생성한 이미지 특유의 패턴을 학습하여 탐지합니다.

나) 얼굴 분석

(1) 얼굴 랜드마크 분석

얼굴의 주요 랜드마크(눈, 코, 입 등)를 분석해 움직임과 위치의 일관성을 확인합니다. 딥페이크 영상은 랜드마크의 미세한 위치 변화를 일으킬 수 있습니다.

(2) 얼굴 주름과 피부 질감 분석

얼굴의 주름과 피부 질감을 분석하여 인위적인 변화를 탐지합니다. 딥페이크 영상은 자연스럽지 않은 주름 패턴이나 피부 질감을 보일 수 있습니다.

다) 음성 분석

(1) 스펙트로그램 분석

음성의 스펙트로그램을 분석하여 인위적인 변조 여부를 판단합니다. 딥페이크 음성은 스펙트로그램에서 비정상적인 패턴을 나타낼 수 있습니다.

(2) 음성 주파수 분석

음성의 주파수 분포를 분석하여 딥페이크 여부를 판단합니다. 딥페이크 음성은 주파수 분포에서 비정상적인 변화를 보일 수 있습니다.

라) 비디오 프레임 분석

비디오의 각 프레임을 분석하여 일관성 없는 움직임이나 비정상적인 변화를 탐지합니다. 딥페이크 영상은 프레임 간의 일관성이 맞지 않을 수 있습니다.

마) 생체 특성 분석

(1) 눈깜빡임 분석

딥페이크로 만든 영상은 실제 인물과 눈깜빡임에서 차이를 보입니다. 실제 인물이 평균적으로 분당 몇 번이나 눈을 깜빡이는지, 특정 단어에서 눈을 깜빡이는지 확인하고 딥페이크 영상을 분석하면 조작 여부를 판단할 수 있습니다.

(2) 심박수 분석

얼굴 영상에서 심박수를 추출하여 분석합니다. 딥페이크 영상은 자연스러운 심박수 패턴을 재현하지 못할 수 있습니다.

(3) 미세 표정 분석

얼굴의 미세 표정을 분석하여 딥페이크 여부를 판단합니다. 딥페이크 영상은 미세 표정에서 비정상적인 변화를 보일 수 있습니다.

4) 도이치벨레의 딥페이크 점검표

독일의 국제방송 도이체 벨레는 미디어 스푸핑에 많이 활용되는 딥페이크를 탐지하기 위한 점검표를 제시합니다.31)

도이체 벨레의 점검표는 특별한 전문성이 없어도 딥페이크를 감지할 수 있는 기초적인 팁으로 다음과 같은 사항을 참고할만합니다.

가) 제목 검색

영상의 제목을 인터넷에서 검색해봅니다. 믿을만한 복수의 출처에서 같은 얘기를 찾을 수 있다면 신뢰도도 그만큼 높아집니다.

나) 역 이미지 검색

가장 단순하면서도 가장 강력한 위변조 검증 기법이 역 이미지 검색입니다. 구글이나 마이크로소프트의 빙 등 최신 검색 엔진은 대부분 역 이미지 검색(Reverse Image Search)을 제공합니다. 영상의 섬네일이나 특정 프레임을 검색해보면 원본이나 유사한 사진을 찾을 수 있습니다. 아울러 해당 사진이 처음 게시된 시점을 확인하고 싶으면 마이크로소프트의 빙 시각화 검색이나 역 이미지 검색 전용 엔진인 틴아이에서 오래된 순으로 정렬하면 됩니다. 마지막으로 구글이나 빙에서 검색되지 않는 일부 이미지는 러시아 검색 엔진인 얀덱스에서 검색되는 경우가 있습니다.

다) 프레임 단위 또는 저속 재생

영상은 1초에 24 또는 30프레임 속도로 재생됩니다. 딥페이크 감지를 위해선 프레임 단위로 재생하거나 통상보다 훨씬 느리게 재생해야 합니다. 이를 위해선 어도비 프리미어 프로나 에디우스 같은 편집 프로그램을 활용해야 합니다. 이외에도 VLC 미디어 플레이어 같은 무료 프로그램도 프레임 단위 재생을 지원하고 있습니다. 유튜브(Youtube)처럼 웹에 게시된 영상은 watchframebyframe.com 같은 웹사이트에서 영상의 링크만으로도 프레임 단위 재생을 지원하니 큰 도움이 될 수 있습니다.

프레임 단위 재생이 가능하면, 앞 프레임, 뒤 프레임과 비교해서 프레임 사이의 연결이 자연스러운지 살펴야 합니다. 아울러 갑자기 삽입되거나 빠진 프레임 때문에 부자연스러운 점은 없는지도 확인해야 합니다.

영상과 마찬가지로 음성이나 배경음도 파형의 변화에 유의하며 프레임 단위로 재생하거나 저속 재생했을 때 특이점은 없는지 점검해야 합니다. 또, 영상 내 화자의 입 모양과 입술의 움직임이 실제 사람이 말할 때처럼 자연스러운지, 입 모양과 소리가 동기화됐는지도 살펴야 합니다.

라) 단일 프레임 내 특이점 파악

도이체 벨레는 단일 프레임이나 정지 화면에서도 딥페이크를 파악할 수 있는 몇 가지 포인트도 제시했습니다. 완벽하게 대칭인 얼굴, 특이한 귀와 코, 치아 모양, 양쪽이 서로 다른 귀걸이, 끊어진 머리카락, 비정상적인 손가락, 부자연스러운 목 부위 등인데 하나씩 살펴봅니다.

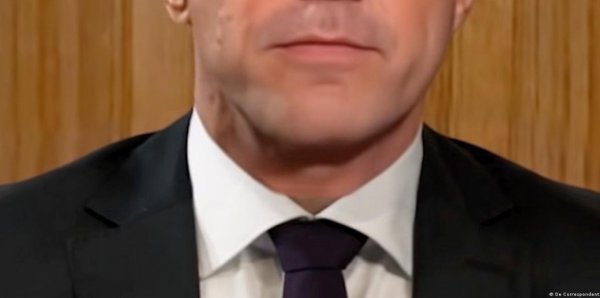

(1) 부자연스러운 목

아래 사진 27.은 네덜란드 총리 마르크 뤼터(Mark Rutte)의 딥페이크 영상에서 따왔습니다. 여기서 뤼터의 목과 넥타이 사이를 주목합니다. 셔츠 사이 목 부위는 그 위와 피부색이 다르고, 셔츠는 해당 부위 주변에서 왜곡돼 있습니다. 마치 투명한 띠 하나를 해당 부위에 덧댄 듯 자연스럽지 않습니다. 이건 얼굴을 바꿀 때 가장자리에 남는 흔적입니다.

(2) 서로 다른 귀걸이, 안경

아래 사진 28.에서 양쪽 귀걸이는 모양이 다릅니다. 심지어 귀에 거는 고리가 있는 왼쪽과 달리 오른쪽 귀걸이는 고리도 보이지 않습니다. 딥페이크에 쓰이는 생성적 적대 신경망(Generative Adversarial Network, GAN)이 아직 복잡한 보석은 자세히 묘사하기 힘들기 때문입니다.

아래 사진 29.의 안경도 마찬가지입니다. 왼쪽의 안경알은 타원형에 더 가깝고, 테는 다리 연결부위가 두껍습니다. 반면, 오른쪽의 안경알은 왼쪽에 비해 각지고, 테는 다리 왼쪽에 비해 다리 연결부위가 가늡니다.

(3) 비현실적 배경

아래 사진 30.은 남성 뒤로 비현실적인 배경이 보입니다. 비록 얕은 심도로 명확하게 보이진 않지만, 남성 왼쪽 뒤편에 뭉개진 주름은 사진의 신뢰도를 크게 떨어뜨립니다.

(4) 뭉개진 치아

아래 사진 31.에서 남성의 아랫니를 보면 앞니의 구분이나 가장자리가 명확하지 않습니다. 생성적 적대 신경망은 치아를 상상하기 어렵기 때문에 발생하는 오류입니다. 따라서 가장자리나 경계가 뭉개졌거나 비정상적인 치아가 보인다면 딥페이크일 가능성이 있습니다.

(5) 이마에서 자라는 머리카락

아래 사진 32.는 얼핏 봐선 특이점이 없는 것 같습니다. 자세히 보면 머리카락이 이마에서 자랍니다. 이처럼 머리카락이 얼굴에서 자라거나 체모가 옷에서 자란다며 해당 사진은 딥페이크일 가능성이 있습니다.

마) 도이체 벨레 점검표의 한계

생성적 적대 신경망은 계속 발전하고 있고, 딥페이크도 점점 정교해지고 있습니다. 따라서 도이체 벨레가 기사를 통해 제시한 딥페이크 감지단서는 앞으로 나올 딥페이크 영상이나 사진을 검증할 땐 제 역할을 하지 못할 가능성이 큽니다. 결국 비주얼 포렌식스 기법과 도구를 활용해야 딥페이크를 비롯한 위변조 이미지를 제대로 검증할 수 있습니다.

라. 도구

비주얼 포렌식스는 다양한 기술적 도구를 사용하여 이미지와 영상의 진위를 분석하고, 조작 여부를 식별합니다. 이러한 도구들은 이미지와 영상의 디지털 흔적을 추적하고, 분석하며, 조작의 흔적을 발견하는 데 중요한 역할을 합니다.

1) 이미지 분석 도구

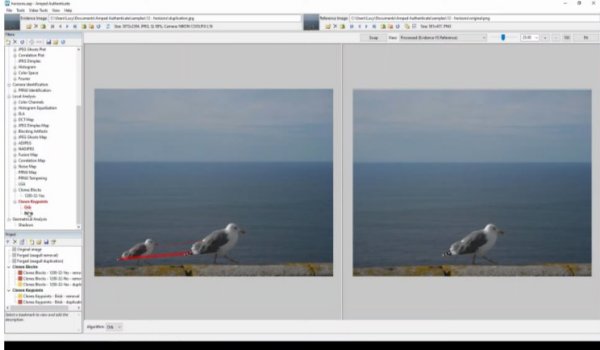

가) Amped Authenticate

이미지의 진위를 분석하기 위한 토털 솔루션을 제공하는 강력한 유료 포렌식 소프트웨어입니다. 40여 개가 넘는 이미지 위변조 식별 도구와 필터를 제공하며, 소스 장치(카메라) 식별이나 딥페이크, 이미지의 조작 여부를 정밀하게 판단할 수 있습니다.

위 사진 33.에선 왼쪽 이미지를 Amped Authenticate로 분석한 결과 조작된 것으로 의심되는 영역이 오른쪽처럼 붉은색으로 드러납니다.

위 사진 34.에선 Amped Authenticate가 복사-붙여넣기를 어떻게 식별하는지 보여줍니다. 왼쪽 이미지 속에 갈매기 2마리가 보이는데, 이 사진을 분석한 결과 본래 이미지에는 오른쪽처럼 갈매기 1마리만 있습니다. 조작자는 이 갈매기를 복사한 뒤 왼쪽에 작게 붙여넣었고, Amped Authenticate는 이를 픽셀의 유사도를 확인해 식별해냅니다.

위 사진 35.에선 Amped Authenticate가 이미지 속 그림자를 식별해 광원의 방향을 기하학적으로 찾아냅니다. 여기서 왼쪽 아래 끝의 오렌지의 그림자는 나머지 물체의 그림자와 광원의 방향이 다른 것을 알 수 있습니다.

Amped Authenticate는 40여 개가 넘는 식별 도구와 필터, 역 이미지 검색 결과, 소스 장치 식별 결과 등을 분석해 보고서를 생성하며 어떤 지점에서 이미지나 영상이 위변조됐는지를 구체적으로 서술합니다.

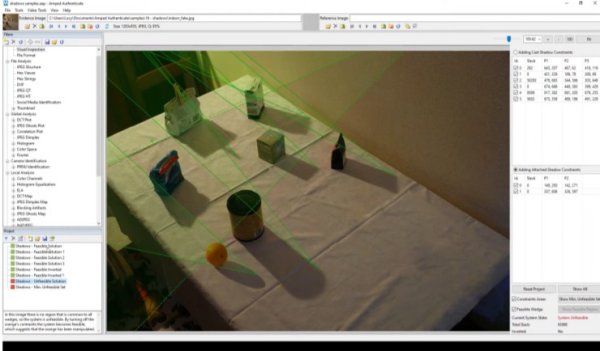

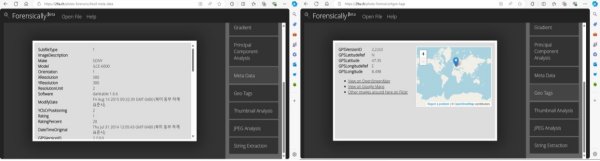

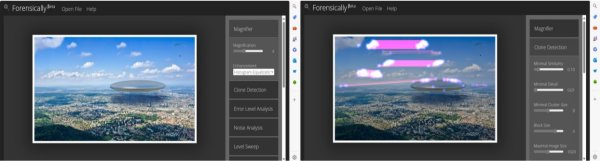

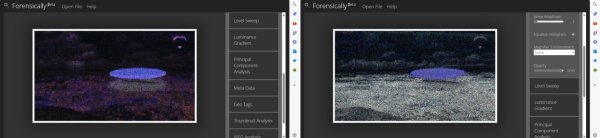

나) Forensically

이미지 분석을 위한 무료 웹 기반 도구로 메타데이터 분석, 클로닝 탐지, 오류 수준 분석 등 다양한 기능을 제공합니다.

사진 38.에선 Forensically의 클로닝 탐지 도구를 활용해 구름과 지형지물이 복사된 것을 확인할 수 있습니다.

사진 39.에선 Forensically의 오류 수준 분석(Error Level Analysis)과 노이즈 분석(Noise Analysis)을 활용해 UFO와 행글라이더가 위변조됐을 가능성이 크다는 게 두드러지는 것을 확인할 수 있습니다.

2) 비디오 분석 도구

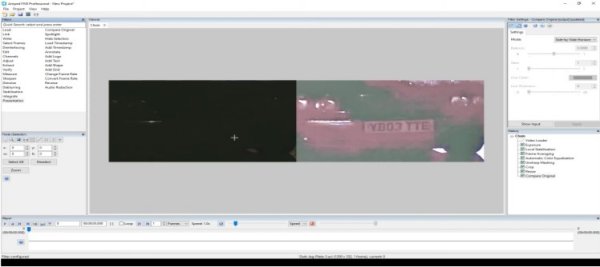

가) Amped FIVE

비디오 포렌식 분석을 위한 유료 소프트웨어로, Amped Authenticate의 자매품입니다. 증거 인증보다는 증거 개선과 증거 식별을 위한 도구입니다.

Amped Five는 증거 개선과 증거 식별을 위해 140여 개의 도구와 필터를 제공합니다. 이를 통해 야간에 촬영된 영상에서 자동차 번호판과 같은 객체를 탐지하고 내용을 식별하며, 모션 블러로 인식하기 어려운 텍스트를 안정화해 식별을 돕습니다.

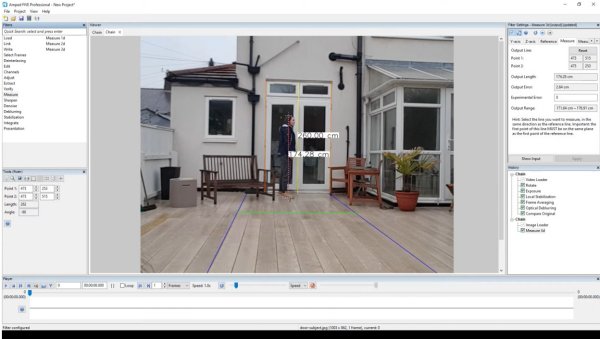

아울러 기하학적 도구로 이미지 내 사람의 키나, 사물의 길이 등을 측정할 수 있습니다. 이는 범죄 등 사건 현장의 재구성 및 추적에 도움을 줄 수 있습니다. 마지막으로 Amped Five는 Amped Authenticate와 같이 분석 대상 영상에 대한 보고서를 작성해줍니다.

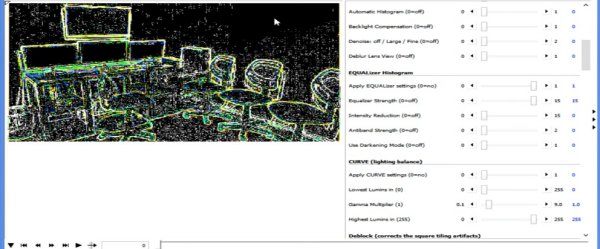

나) VideoCleaner

비디오 포렌식 분석을 위한 무료 소프트웨어로, 비디오의 품질을 개선하고, 조작 여부를 판단할 수 있는 다양한 기능을 제공합니다.

위 사진 43.에선 VideoCleaner의 노이즈 분석 기능을 활용해 왼쪽 위 끝의 작은 모니터 3개와 오른쪽 위 끝의 벽면 일부에 노이즈가 전혀 발생하지 않는 것을 확인할 수 있습니다. 소스 장치(카메라) 고유의 노이즈가 화면 전체에 나타나는데 두 영역에서만 노이즈가 발생하지 않는 것은 해당 영역이 위변조됐을 가능성을 의미합니다.

마. 사례

비주얼 포렌식스는 다양한 실제 사례에서 이미지와 영상의 진위를 밝히고, 조작된 콘텐츠를 식별하는 데 중요한 역할을 합니다. 다음은 비주얼 포렌식스가 성공적으로 사용된 몇 가지 대표적인 사례입니다.

1) 국제 조사 저널리즘 단체 벨링캣의 2014년 말레이시아 항공 MH17 격추 사건 분석

가) 분석 대상

국제 조사 저널리즘 단체인 벨링캣 조사팀은 2014년 7월 17일 우크라이나 동부에서 말레이시아 항공 17편이 격추된 뒤 러시아 국방부가 공개한 여섯 장의 위성 사진 중 두 장을 분석했습니다.32)

러시아 국방부가 공개한 사진 가운데 분석 대상은 4번과 5번입니다. 4번은 러시아 국방부의 주장대로라면 2014년 7월 17일 우크라이나 도네츠크 북쪽을 촬영한 사진입니다. 앞선 사진들에선 이곳에 우크라이나군의 지대공 미사일 등 방공시스템이 배치돼 있었습니다. 그런데 사흘 뒤 촬영한 4번 사진에서 방공시스템이 사라졌다는 게 러시아 국방부의 주장입니다. 5번도 러시아 국방부가 4번과 같은 날 촬영됐다고 주장한 사진입니다. 이 사진에선 우크라이나 도네츠크에서 동쪽으로 50킬로미터 지점인 샤흐타르스크에서 남쪽으로 8킬로미터 떨어진 곳에 배치된 우크라이나군의 지대공 미사일 부대를 볼 수 있습니다. 그리고 이어진 6번 사진에선 이 부대가 다음 날 철수한 것으로 나옵니다. 벨링캣은 러시아 국방부가 제공한 사진대로 우크라이나군 지대공 미사일 부대가 사고 직전 이곳에 배치되고, 사고 직후 이곳에서 철수한 게 맞는지 비주얼 포렌식스 기법을 활용해 검증했습니다.

분석 방법

(1) 출처 분석

출처 분석은 분석 대상 이미지가 어디서 촬영되거나 수정, 게시됐는지를 확인합니다. 분석 결과는 해당 사진이 특정 카메라에서 촬영됐고, 다른 편집 소프트웨어를 거치지 않았다는 게 확인돼야 합니다. 이를 위해 소스 장치 식별 도구를 활용하거나 역 이미지 검색을 할 수 있습니다.

(2) 메타데이터 분석

메타데이터는 이미지의 수정 여부를 나타내는 추가 정보를 제공합니다.

(3) 오류 수준 분석(Error Level Analysis, ELA)

오류 수준 분석(ELA)은 이미지 내에서 서로 다른 수준으로 압축된 영역을 식별합니다. JPEG 이미지의 경우 전체 그림이 대략 같은 압축 수준이어야 합니다. 이미지 일부분이 현저히 다른 오류 수준을 보인다면 이는 디지털 수정의 가능성을 나타냅니다.

(4) 이미지 내용의 참조 분석

참조 분석은 이미지의 내용을 다른 정보 소스와 비교하여 타당성을 평가합니다. 예를 들어, 러시아 국방부가 제공한 4번과 5번 사진의 검증 가능한 이미지 내용은 이미지의 날짜, 위치, 지리적 특징, 건물, 차량 및 이미지에 포착된 기타 세부 사항을 포함합니다. 이 분석에는 Google Earth의 역사적 위성 이미지를 참조 이미지로 사용했습니다.

다) 분석 결과

(1) 러시아 국방부 공개 사진 4번의 분석 결과

메타데이터 분석에서 4번과 5번 사진은 Adobe Photoshop CS5로 처리됐다는 게 확인됐습니다. 해당 사진은 포스트 프로덕션을 거친 뒤 900×600픽셀 크기로 축소됐고, 압축 품질 75%로 열화돼 저장됐습니다.

오류 수준 분석에선 위 사진 4번이 사진 45.처럼 5곳의 영역에 현저한 다른 오류 수준을 보였습니다. 5곳의 영역은 다음과 같이 구분할 수 있습니다.

- 영역 A: 추가 이미지 요소 및 라벨링

- 영역 B: 하단의 색상 오류 수준

- 영역 C: 지면 패턴, 토양 구조 및 차량이 포함된 이미지 내용

- 영역 D: 사진 오른쪽의 구름

- 영역 E: 사진 왼쪽의 구름

영역 A와 B의 높아진 오류 수준은 추가된 이미지 요소 및 라벨링으로 설명될 수 있습니다. 영역 B의 색상 선은 사진의 하단이 띠로 덮여 있었음을 나타냅니다. 영역 E의 어두움은 사진의 밝기와 대비를 강화한 것에서 비롯된 것으로 보이며, 이 영역은 과다 노출되어 있습니다. 이 모든 영역의 증가한 오류 수준은 무해합니다. 다만, 영역 D와 C 사이의 오류 수준 차이는 이미지의 내용으로 설명될 수 없습니다. 오류 수준 차이는 흐릿한 이미지 내용으로 인해 발생할 수 있지만, 오른쪽의 구름은 선명하게 정의된 구조이므로 이 부분에서 오류 수준은 이미지 중앙 부분과 큰 차이를 보이지 않아야 합니다.

벨링캣은 더 정확한 비교를 위해, 다른 지역의 유사한 구름을 찍은 Google Earth의 사진(아래 사진 46.)을 예시로 듭니다.

위 사진 46.에서 원본사진의 구름은 구름이 없는 지역과 비교해 오류 수준에 큰 차이를 일으키지 않는다는 것을 보여줍니다. 따라서 러시아 국방부가 공개한 4번 사진의 구름은 원본 이미지의 일부가 아니며 후반 작업 과정에서 추가됐을 가능성이 큽니다.

벨링캣은 러시아 국방부가 제공한 사진의 날짜인 2014년 7월 17일이 정확한지 파악하기 위해 사진 내 특정 장소의 변화를 파악하기로 했습니다. 이를 위해 7월 17일보다 사흘 전인 2014년 7월 14일 촬영했다는 러시아 국방부 제공 사진 3번과 구글 어스의 과거 사진들을 활용했습니다. 그 결과 해당 사진은 러시아 국방부의 주장보다 최소 한 달 전에 촬영된 것으로 밝혀졌습니다. 다음 내용은 벨링캣이 이를 밝히는 과정을 보고서에 서술한 겁니다.

벨링캣은 먼저 러시아 국방부가 공개한 사진 3번의 식생 영역의 변화를 토대로 사진 3번의 날짜를 특정하기로 했습니다.

- 사진 A: 영역 B – 2014년 5월 30일 Google Earth 위성 사진

- 사진 B: 영역 B – 2014년 7월 14일 러시아 국방부 공개 사진 3번

- 사진 C: 영역 B – 2014년 6월 19일 Google Earth 위성 사진

- 사진 D: 영역 B – 2014년 7월 2일 Google Earth 위성 사진

- 사진 E: 영역 B – 2014년 7월 21일 Google Earth 위성 사진

위 사진 48.에서 사진 B의 식생 왼쪽에 있는 토양 구조는 사진 A의 토양 구조와 밀접하게 일치합니다(녹색 화살표). 사진 B 중앙의 식생을 가로지르는 길은 사진 C에서 동일하게 보이는 길과 일치합니다(노란색 화살표). 그러나 사진 C에서는 이미지 왼쪽의 들판에 세로선 패턴이 나타나는데, 이는 사진 B에서는 보이지 않습니다(하늘색 화살표). 사진 D와 E는 또한 사진 B에는 없는 토양 구조의 중요한 변화를 보여줍니다(파란색 화살표).

따라서 사진 3번(사진 B)은 러시아 국방부의 주장과 달리 2014년 5월 31일과 2014년 6월 19일 사이의 기간에 촬영된 것으로 날짜를 특정할 수 있습니다.

사진 3번의 날짜가 특정됐기 때문에 러시아 국방부가 사흘 뒤에 찍었다는 사진 4번의 날짜도 특정하기 쉬워졌습니다. 사진 4번의 날짜 특정도 사진 3번과 마찬가지로 사진 내 특정 장소의 변화를 구글 어스 등의 다른 위성 사진도 비교, 대조했습니다.

벨링캣은 사진 4번(사진 49.) 중앙에 군용 차량 5대가 주차된 A 영역에 주목했습니다. 이곳엔 4대의 차량이 세로로 주차돼 있고, 나머지 한 대가 가로로 주차돼 있습니다.

A 영역을 확대한 사진(사진 50.)에선 가로로 주차된 차량 A에서 흘러나온 액체가 형성한 웅덩이 B를 확인할 수 있습니다. 벨링캣은 이 웅덩이의 유무와 크기를 기준으로 날짜를 특정하기로 했습니다.

- 사진 A: 영역 A – 2014년 5월 30일 Google Earth 위성 사진

- 사진 B: 영역 A – 2014년 7월 14일 국방부 사진 3번

- 사진 C: 영역 A – 2014년 7월 17일 국방부 사진 4번

- 사진 D: 영역 A – 2014년 6월 19일 Google Earth 위성 사진

위의 사진 51.에서 빨간색 화살표는 차량에서 새어 나온 액체로 형성된 웅덩이의 위치를 나타냅니다. 사진 A에서는 차량은 보이지만, 새어 나온 액체가 형성한 웅덩이는 보이지 않습니다. 사진 B와 C에서는 차량 옆에 새어 나온 액체가 보이며, 사진 C에서는 웅덩이가 이미 눈에 띄게 커져 있습니다. 사진 D에서는 웅덩이가 상당히 커졌습니다. 앞에서 사진 3번의 촬영 날짜가 2014년 5월 31일과 2014년 6월 18일 사이로 특정됐기 때문에 이를 감안하면 사진 4번은 2014년 6월 1일과 6월 18일 사이로 특정할 수 있습니다. 따라서 사진 4번의 촬영 날짜도 러시아 국방부가 주장한 7월 17일과 한 달가량 차이가 있는 겁니다.

벨링캣은 이 같은 분석 결과를 토대로 러시아 국방부 공개 사진 4번에 대한 다음의 결론을 내립니다.

출처 분석을 바탕으로 제삼자의 디지털 수정 가능성은 배제할 수 있습니다. 벨링캣 조사팀의 포렌식 분석에 따르면 사진 4번은 Adobe Photoshop CS5 소프트웨어로 수정됐습니다. 이미지의 왼쪽과 오른쪽에 구름이 추가돼 추가적인 역사적 이미지와의 비교에 사용할 수 있는 세부 사항이 가려졌을 가능성이 큽니다. 사진 4번의 내용을 구글 어스의 역사적 위성 이미지와 비교한 결과, 사진 4번은 2014년 6월 1일과 2014년 6월 18일 사이에 촬영되었음을 결정적으로 입증합니다.

벨링캣 조사 보고서 “러시아 국방부가 공개한 위성 이미지의 법과학적 분석” 중

(2) 러시아 국방부 공개 사진 5번의 분석 결과

벨링캣은 러시아 국방부가 공개한 사진 5번에 대해서도 사진 4번과 같은 분석을 진행했습니다. 그 결과 메타데이터 분석에서 사진 4번과 같이 포토샵 CS5로 수정됐고, 압축 품질 75%로 열화돼 저장됐다는 것을 확인했습니다. 오류 수준 분석에서도 아래 사진 52.처럼 사진 설명을 위해 추가된 도형이나 텍스트를 배제하고도, 배경과 큰 차이가 없어야 할 객체 중에 다수가 더 높은 오류 수준을 드러냈습니다. 이는 위변조됐을 가능성을 높이는 정황입니다.

아울러 날짜 특정을 위해 러시아 국방부가 공개한 사진 6번은 물론 구글 어스의 위성 사진들과도 비교, 대조한 끝에 사진 5번은 2014년 7월 15일 이전에 촬영됐고, 사진 6번은 2014년 7월 16일 이전에 촬영됐다고 결론 내렸습니다. 이 또한 러시아 국방부의 발표와 달랐습니다.

벨링캣은 이 같은 분석 결과를 토대로 러시아 국방부 공개 사진 5번에 대한 다음의 결론을 내립니다.

출처 분석을 통해 제삼자에 의한 디지털 수정은 배제할 수 있습니다. Bellingcat 조사팀의 포렌식 분석에 따르면 사진 5는 Adobe Photoshop CS5 소프트웨어로 디지털 수정되었습니다. 우리는 원본 위성 이미지의 여러 영역이 디지털로 수정되었을 가능성이 매우 크다고 평가합니다. 사진 5를 구글 어스의 역사적 위성 사진과 비교한 결과, 사진 5가 2014년 7월 15일 이전에 촬영되었음이 명확하게 입증되었습니다.

라) 사진 검색 키워드: MH17 satellite image analysis Bellingcat

2) 이스라엘 방위군의 2023년 하마스의 가자지구 알 아흘리 병원 오폭 사건 분석

가) 분석 대상

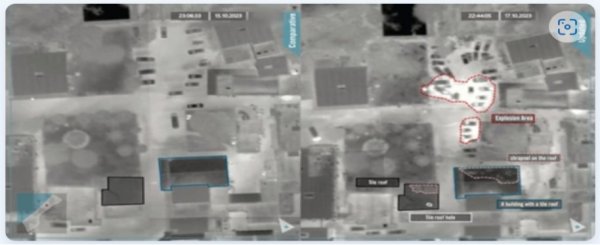

2023년 10월 17일 하마스가 통치하는 가자지구 내 알 아흘리 아랍병원에 로켓탄이 떨어졌습니다. 이 폭격으로 최대 4백여 명이 숨졌고, 3백여 명 다쳤습니다. 하마스는 즉시 이스라엘군의 공습을 비난했고, 각국의 언론은 앞다투어 하마스의 주장을 인용했습니다. 이 사건으로 세계 여론은 이스라엘에 적대적으로 바뀌었고, 중동 전역의 이슬람 원리주의 세력도 전쟁에 뛰어들 명분을 얻었습니다. 자칫하면 알 아흘리 병원 공습 사건이 제2의 통킹만 사건이 될 수도 있었습니다. 이에 이스라엘 방위군은 신속히 대응했습니다. 알 아흘리 병원의 위성 사진과 하마스의 로켓탄 궤적을 분석하고, 하마스 통신망을 도청한 내용을 공개해 하마스의 주장을 반박했습니다.33)

나) 분석 방법

이스라엘군은 항공 영상 분석, 로켓 궤적 분석, 통신선 도청을 동원했습니다. 이 가운데 비주얼 포렌식스의 영역은 항공 영상 분석과 로켓 궤적 분석입니다. 물론 이스라엘 방위군의 발표를 반박하는 측면에선 통신선 도청 내용도 분석 대상에 포함될 수 있지만, 여기서는 이스라엘 방위군의 분석만을 대상으로 살펴봅니다. 왜냐하면 이스라엘 방위군의 발표 이후 하마스는 제대로 된 반박을 하지 못했고, 미국 정부나 인권단체들도 이스라엘 방위군의 발표를 받아들여 이 사건이 사실상 하마스의 오폭으로 결론 났기 때문입니다.

다) 분석 결과

아래 사진 53.은 로켓이 떨어지기 전인 2023년 10월 15일과 후인 2023년 10월 17일 병원 현장의 항공 영상을 비교한 겁니다. 항공 영상에서 로켓 피격으로 인해 병원 건물 자체에 직접적인 타격이 있었던 건 확인되지 않습니다. 대신 로켓이 주차장에 떨어진 것으로 보입니다. 따라서 주요 충돌 지점은 병원 밖 주차장이고, 화재의 흔적은 있지만 인근 건물에 크레이터나 구조적 손상이 나타나지 않습니다. 공습의 뚜렷한 징후로 나타나는 크레이터와 건물의 구조적 손상이 보이지 않는다는 뜻입니다.

이스라엘 방위군은 자신들의 주장을 뒷받침하기 위해 실제 자신들의 공습으로 만들어진 크레이터를 촬영한 항공 영상을 제시합니다.

위의 사진 54.처럼 이스라엘 방위군의 공습에 사용되는 폭탄이나 미사일의 크기에 따라 다양한 형태의 크레이터가 형성됩니다. 그런데 알 아흘리 병원에선 주차장에 로켓탄이 떨어졌음에도 불구하고, 크레이터가 만들어지지 않았습니다. 따라서 이스라엘 방위군은 알 아흘리 병원에 떨어진 로켓탄이 자신들이 쏜 것이 아니라고 주장할 수 있게 됐습니다.

이스라엘 방위군은 항공 영상 분석에 이어 위 사진 55.처럼 하마스의 로켓탄 궤적을 제시합니다. 2023년 10월 17일 18시 59분에 발사된 하마스의 로켓탄 일제 사격 레이더 궤적입니다. 이스라엘 방위군은 이 궤적을 제시하며 알 아흘리 병원이 로켓의 비행경로에 있었다고 주장합니다. 아울러 이 발표를 했던 2023년 10월 18일까지 가자지구에서 발사된 하마스의 로켓탄 가운데 약 450발이 오작동해 가자지구 내에 떨어졌고, 이는 발사된 전체 하마스 로켓탄의 5%에 해당한다고 덧붙였습니다.

라) 분석 한계

이스라엘 방위군의 반박은 성공적이었고, 이스라엘에 적대적으로 돌아선 여론도 수그러들었습니다. 그러나 이스라엘 방위군의 발표는 분명히 한계를 드러냈습니다. 먼저 이스라엘 방위군의 하마스의 로켓탄 궤적 분석은 실제 레이더 영상이 아니라 그래픽에 불과합니다. 이스라엘 방위군이 사용하는 아이언돔 체계의 레이더는 분당 30회전을 해서 2초에 한 번꼴로 비행체의 좌표가 단순한 반사 신호인 스킨 페인트(Skin Paint) 형태로 레이더 화면에 점처럼 전시됩니다. 그 점을 이은 게 선형의 궤적이 됩니다. 이스라엘 방위군이 원천 자료에 해당하는 레이더 스킨 페인트 자료를 공개했다면 훨씬 더 설득력이 있겠지만, 작성자의 의도에 의해 왜곡이나 조작될 수 있는 그래픽을 제시한 건 분명한 한계입니다.

더 큰 문제는 이스라엘 방위군 대변인인 피터 러너 중령의 BBC, CNN 인터뷰에서 발생합니다. 당시 러너 중령은 알자지라가 포착한 미사일 영상의 스틸 이미지를 제시하며 해당 미사일이 알 아흘리 병원을 공격한 하마스의 로켓탄이라고 주장합니다.

이에 뉴욕 타임스와 워싱턴 포스트는 물론 비주얼 포렌식스 분야의 전문 연구집단인 포렌식 아키텍처가 해당 발언에 대한 검증에 나섭니다.

3) 포렌식 아키텍처의 이스라엘 방위군 대변인 주장 검증

가) 분석 대상

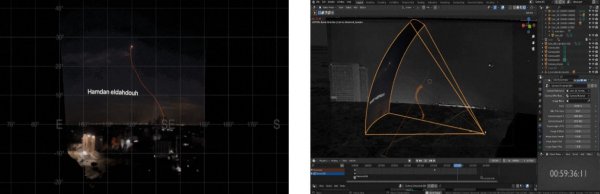

포렌식 아키텍처는 이스라엘 방위군 대변인 피터 러너 중령이 인터뷰에서 제시한 사진 속 미사일이 누가 쏜 어떤 미사일인지 분석합니다. 아울러 이스라엘 방위군이 최초 발표 때 제시했던 하마스의 로켓탄 궤적으로 자체적으로 재구성해 이 로켓탄 가운데 한 발이 알 아흘리에 떨어졌고, 해당 로켓탄에 남아있던 추진체 연료가 큰 피해를 일으켰다는 이스라엘 방위군의 주장을 반박합니다.34)

나) 분석 방법 및 결과

(1) 영상 속 미사일 식별

(가) 소스 파악 및 방법론 결정

이스라엘 방위군 대변인의 인터뷰 때 사용된 영상은 알자지라의 방송 화면이었습니다. 이 영상 가운데 일부는 가자 시티에서 알자지라 기자의 휴대 전화로 촬영됐고, 다른 일부는 이스라엘 텔아비브에 있는 고정된 카메라로 촬영됐습니다. 포렌식 아키텍처는 사진 속 미사일을 식별하기 위해 궤적 추적 방법론(Trajectory Tracking Methodology)을 활용하기로 합니다.

(나) 정적 특징 식별 및 카메라 움직임 추적

포렌식 아키텍처는 블렌더(Blender)와 같은 공개 프로그램 모델링 소프트웨어를 사용해 영상에서 가자 시티 전역의 불빛과 같은 정적인 특징을 식별했습니다. 이러한 특징을 ‘앵커 포인트’로 사용해 카메라를 안정화하고, 움직임을 디지털 3D 공간에서 재현했습니다.

(다) 영상 투사 및 위치 추적을 통한 궤적 재구성

이후 안정화된 카메라의 영상을 정적인 평면에 투사해, 미사일의 위치를 프레임별로 추적했습니다. 이 위치는 다른 각도에서 촬영된 영상과 교차 참조하여 미사일의 정확한 위치를 프레임별로 삼각 측량했습니다. 이를 바탕으로 미사일의 전체 궤적을 재구성했습니다.

(라) 미사일 식별 결과

재구성된 궤적은 미사일이 가자 지구 외곽에서 발사되었음을 보여줍니다. 이스라엘 방위군의 ‘아이언돔’ 방공시스템의 일부인 것으로 알려진 미사일 발사장 근처입니다. 공중에서 두 번 회전하는 미사일의 궤적은 이것이 지대지 미사일이나 로켓의 탄도탄 궤적이 아니라 요격 미사일이라는 걸 보여줍니다. 따라서 해당 영상 속 미사일은 하마스의 로켓탄이 아닙니다.

아울러 포렌식 아키텍처는 알자지라 영상에 포착된 폭발이 가자지구 외곽의 고도 5km, 병원에서 5.7km 떨어진 곳에서 일어난 것을 확인했습니다. 고도 5km에서 이 폭발로 인한 파편은 31초 뒤 자유낙하를 해 지면에 도달했을 겁니다. 그런데 병원 폭발은 불과 8초 후에 일어났기 때문에 영상 속 미사일이 알 아흘리 병원 폭발에 영향을 준 게 아닙니다.

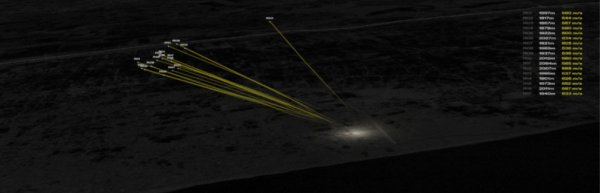

(2) 이스라엘 방위군 주장 하마스 로켓탄 궤적 분석

(가) 분석 영상 확보

포렌식 아키텍처는 미사일 식별 때와 마찬가지로 궤도 추적 방법론을 활용해 하마스 로켓탄의 궤적을 분석했습니다. 이를 위해 이스라엘 텔아비브와 가자지구에 인접한 네티브 하아사라에서 촬영된 영상을 확보했습니다.

(나) 속도 및 거리 분석

포렌식 아키텍처는 하마스가 발사한 로켓탄 17발이 모두 알 아흘리에서 서쪽으로 약 4km 떨어진 고도 1km에서 추진체 연소를 멈췄고, 비슷한 거리(1.8~2km)를 비슷한 속도(500~630m/s)로 날았다고 분석했습니다. 이는 17발 로켓탄이 모두 비슷한 양의 추진체를 태웠다는 것을 시사합니다.

(다) 전문가 의견

포렌식 아키텍처는 아울러 항공우주 전문가의 의견을 참고해 로켓의 특성과 추진제 연소 상태를 분석했습니다. 전문가는 로켓 추진제가 한 번 연소를 시작하면 연료가 챔버에 남아있는 상태에서 연소가 멈추는 것은 매우 드문 일이라고 밝혔습니다.

이러한 방법론을 통해 우리는 미사일의 궤적을 정확히 파악하고, 알-아흘리 병원 폭발과 같은 사건의 원인을 분석할 수 있습니다.

(라) 로켓탄 궤적 식별 결과

포렌식 아키텍처의 식별 결과 하마스가 쏜 로켓탄이 추진체가 남은 상태에서 알 아흘리 병원에 떨어져 큰 피해를 줬다는 주장은 사실이 아닐 가능성이 커졌습니다. 아울러 포렌식 아키텍처의 궤적 분석이 정확하다면, 알 아흘리 병원에 떨어진 로켓탄이 이스라엘 방위군이 제시한 17발 가운데 하나가 아닐 수도 있다는 가능성도 생긴 겁니다. 이 때문에 서방 세계에선 알 아흘리 병원에 떨어진 로켓탄이 하마스의 것으로 추정하고 있지만, 명확하게 누구의 소행인지는 밝혀지지 않은 상태입니다.

다) 분석 한계

포렌식 아키텍처의 분석은 이스라엘 방위군의 공보상 실수를 밝혀냈을 뿐입니다. 영상 속 미사일은 하늘에서 폭발한 이스라엘의 요격 미사일이기 때문에 알 아흘리 오폭의 핵심이 아닙니다. 아울러 하마스의 로켓탄 궤적 분석도 추진체가 연소한 시점을 바탕으로 추진체 소모량과 비행 궤적을 추정한 것일 뿐입니다. 비행 도중 발생할 수 있는 다른 변수를 반영할 수 없고, 17발의 탄착지점을 확인한 것도 아니기 때문에 한계가 있습니다.

바. 비주얼 포렌식스와 팩트체크의 관계

비주얼 포렌식스와 팩트체크는 상호 보완적인 관계를 맺고 있습니다. 두 분야는 모두 정보의 신뢰성을 확보하고, 허위 정보를 차단하는 데 중요한 역할을 합니다. 다음은 비주얼 포렌식스와 팩트체크의 관계를 설명하는 주요 측면입니다.

1) 정보의 신뢰성 확보

팩트체크는 정보의 정확성과 신뢰성을 검증하는 과정을 의미합니다. 비주얼 포렌식스는 디지털 이미지와 영상의 진위를 분석하여 팩트체크 과정에서 중요한 역할을 합니다. 예를 들어, 정치적 선전이나 허위 뉴스에서 사용된 조작된 이미지를 식별해 팩트체커가 올바른 정보를 바탕으로 사실을 확인할 수 있도록 도와줍니다.

2) 허위 정보 차단

허위 정보는 종종 조작된 이미지와 영상을 통해 확산합니다. 비주얼 포렌식스는 이러한 조작된 콘텐츠를 식별하고, 그 진위를 밝혀내어 허위 정보를 차단하는 데 중요한 역할을 합니다. 팩트체크 기관들은 비주얼 포렌식스 결과를 활용해 허위 정보를 신속하게 확인하고 대중에게 알릴 수 있습니다.

3) 다양한 미디어 분석

팩트체크는 텍스트, 이미지, 영상 등 다양한 형태의 정보를 분석합니다. 비주얼 포렌식스는 특히 이미지와 영상의 분석에 특화돼 있어, 팩트체크 과정에서 중요한 도구로 사용됩니다. 예를 들어, 뉴스 기사의 진위를 판단하기 위해 해당 기사에 포함된 이미지나 영상을 분석하여 조작 여부를 확인할 수 있습니다.

4) 기술적 지원

비주얼 포렌식스는 고도의 기술적 분석이 필요합니다. 팩트체크 기관은 비주얼 포렌식스 전문가와 협력해, 복잡한 기술적 문제를 해결하고, 조작된 콘텐츠를 식별할 수 있습니다. 예를 들어, 딥페이크 영상의 진위를 판단하기 위해 딥러닝 기반의 포렌식 도구를 활용할 수 있습니다.

5) 교육 및 인식 제고

비주얼 포렌식스와 팩트체크는 모두 대중의 미디어 리터러시를 향상시키고, 허위 정보에 대한 인식을 재고하는 데 이바지합니다. 비주얼 포렌식스의 사례와 분석 결과를 대중에게 공유해 사람들이 허위 정보를 식별하고, 올바른 정보를 선택할 수 있도록 돕습니다.

6) 법적 대응

비주얼 포렌식스는 법적 분쟁에서 신뢰할 수 있는 증거를 제공하는 데 중요한 역할을 합니다. 팩트체크 기관들은 비주얼 포렌식스 결과를 활용해, 허위 정보에 대한 법적 대응을 지원할 수 있습니다. 예를 들어, 명예훼손이나 허위 정보 유포와 관련된 사건에서 비주얼 포렌식스 결과를 증거로 제출할 수 있습니다.

7) 국제 협력

허위 정보와 조작된 콘텐츠는 국경을 넘어 전 세계적으로 확산합니다. 비주얼 포렌식스와 팩트체크는 국제적인 협력을 통해 이러한 문제를 해결하는 데 이바지할 수 있습니다. 예를 들어, 국제 팩트체크 네트워크(IFCN)와 같은 조직은 비주얼 포렌식스 전문가와 협력해 글로벌 허위 정보 문제에 대응하고 있습니다.

8) 지속적인 연구와 발전

비주얼 포렌식스와 팩트체크는 모두 지속적인 연구와 발전이 필요한 분야입니다. 새로운 조작 기술이 등장함에 따라, 이에 대응하기 위한 새로운 분석 기법과 도구가 개발되고 있습니다. 비주얼 포렌식스와 팩트체크 전문가들은 협력해 최신 기술과 방법을 연구하고, 이를 현장에 적용하는 데 기여하고 있습니다.

이처럼 비주얼 포렌식스와 팩트체크는 상호 보완적인 관계를 통해 정보의 신뢰성을 확보하고, 허위 정보를 차단하는 데 중요한 역할을 합니다. 디지털 시대에 정보의 정확성과 신뢰성은 더욱 중요해지고 있고, 비주얼 포렌식스와 팩트체크는 이러한 요구를 충족시키는 데 필수적인 도구로 자리 잡고 있습니다.

5. 미국 언론의 비주얼 포렌식스

가. 뉴욕 타임스

Visual Investigations is a new form of explanatory and accountability journalism that combines traditional reporting with more advanced digital forensics that includes collecting and analyzing cell phone videos and security camera footage, satellite pictures and other imagery, social media posts, police scanner audio, and 3-D reconstructions of crime scenes.

시각조사(시각적 탐사보도)는 새로운 형태의 설명적이고 책임을 묻는 저널리즘입니다. 이는 전통적인 보도와 진보된 전자법과학이 결합한 겁니다. 진보된 전자법과학은 휴대 전화 영상, 보안 카메라 영상, 위성 사진 및 기타 이미지, 소셜 미디어 게시물, 경찰 스캐너 오디오에 대한 수집과 분석, 그리고 범죄 현장의 3D 재구성을 포함합니다. 뉴욕 타임스가 내린 시각조사(시각적 탐사보도)의 정의입니다.

The Visual Investigations team combines traditional reporting with digital sleuthing and the forensic analysis of visual evidence to find truth, hold the powerful to account and deconstruct important news events.

뉴욕 타임스 시각조사팀의 소개 글입니다. 전통적인 보도에 시각적 증거에 대한 전자적 추적과 법과학적 분석을 결합해 진실을 찾고, 권력자에게 책임을 물으며, 중요한 뉴스 이벤트를 해체하는 게 이들의 존재 목적입니다.

1) 연혁

뉴욕 타임스 시각조사팀은 2017년 창설 이래로 퓰리처상을 4차례 수상했고, 피버디상과 듀퐁상, 에미상, 조지 폴크상, 스크립스-하워드상, 미국 해외언론클럽상 등을 수상했으며, 오스카상 최종 후보에 오르기도 했습니다.

2) 기법

뉴욕 타임스가 자사 홈페이지에 올린 기사를 바탕으로 취재기법과 업무 프로세스를 파악했습니다. 기본적으로 국내 언론의 취재기법과 크게 다르지 않지만, 세부 기법이나 체계성에서 차이를 보입니다.

가) 시각 자료 수집(Tracking Visuals)

특정 주제에 대한 취재팀이 꾸려지면, 팀원들은 현장 취재와 공개 출처정보(OSINT, Open-Source INTelligence) 수집을 통해 시각 자료를 증거로 확보합니다.

나) 현장 취재

사건 관계자와 목격자의 진술과 문서 및 촬영 영상이나 사진, 스트리트캠과 CCTV 등 확보에 목적이 있습니다.

다) 공개 출처정보 수집

소셜 미디어와 위성 사진, 웹에 공개된 시청각 자료 및 데이터 확보에 목적이 있습니다. 통상적인 절차는 트위터와 페이스북, 유튜브, 스냅챗 같은 소셜 미디어에서 자료를 수집하고, 왓츠앱 같은 메신저를 활용해 목격자에 직접 접근하거나 관련 소통 채널, 그룹에 참여해 접촉합니다.

라) 시각 자료 인증(Verification Process)

(1) 뉴스(News) 여부 확인 – “정말 새로운 것인가?”

확보한 사진이나 영상에 대한 역 이미지 검색(Reverse Image Search)을 수행합니다. 이를 통해 확보한 자료가 실제로 새로운 것(News)인지 확인합니다. 만약 확보한 자료가 과거 온라인에 게시된 적이 있다면 검색 결과에 다수 포함될 가능성이 크고, 그렇다면 뉴스 가치가 낮거나 조작됐을 가능성도 있습니다.

2018년 4월 13일, 미국이 시리아를 공습했을 때 다른 곳에서 촬영된 영상이 시리아 다마스커스에서 촬영된 영상인 것처럼 소셜 미디어에 유포됐습니다. 해당 영상은 2015년 2월 우크라이나 루한스크에서 촬영된 영상이었습니다. 당시 MSNBC는 역 이미지 검색을 수행하지 않고, 해당 영상을 다마스커스에서 촬영된 영상으로 오인해 방송했습니다.

반면 뉴욕 타임스는 이렇게 발생할 수 있는 오보를 막기 위해 동영상의 출처를 확인하기 위해 노력합니다. 역 이미지 검색으로 온라인에 처음 공유된 버전을 찾고, 최초 게시자를 확인해 연락합니다. 이를 통해 실제 누가 촬영했는지, 왜 촬영했는지, 그 영상을 사용해도 되는지 확인합니다. 아울러 원본 영상도 획득하려고 노력합니다.

(2) 메타데이터 분석 – “날짜, 시각, 장소 확인”

AP 등 프레스가 제공한 사진과 영상 등 카메라나 휴대 전화로 촬영된 이미지는 메타데이터가 존재합니다. 메타데이터가 존재한다면 촬영된 날짜와 시각을 확인할 수 있고, 메타데이터가 위치정보를 포함하면 장소도 파악할 수 있습니다.

(3) 이미지 분석 – “누가 언제 어디서 무엇을 어떻게 했나?”

이미지 분석 역량이 뉴욕 타임스 등 미국 언론과 국내 언론의 시각 조사에서 가장 큰 차이를 만드는 것으로 보입니다. 뉴욕 타임스 등은 확보한 영상에서 독립적으로 내용을 확인하거나 검증하기 위한 기술과 방법론을 개발해왔습니다. 이를 통해 영상 속에서 누가 언제 어디서 무엇을 어떻게 했는지 확인합니다. 국내에선 세월호 사건 당시 KBS 취재팀이 큰 노력을 기울였지만, 방법론을 확립하거나 조직 내로 전수하지 못한 부분입니다.

소셜 미디어에 게시됐거나 메신저로 전송받았거나 제공자가 조작하면 메타데이터가 없거나 신뢰할 수 없습니다. 이 경우 이미지 안에서 단서를 찾아 촬영된 날짜와 시각, 장소를 확인해야 합니다. 또 메타데이터가 있어서 기본적인 정보를 확인했다 하더라도 “누가 언제 어디서 무엇을 어떻게 했나”라는 질문에 답하기 위해선 정교한 이미지 분석이 필요합니다.

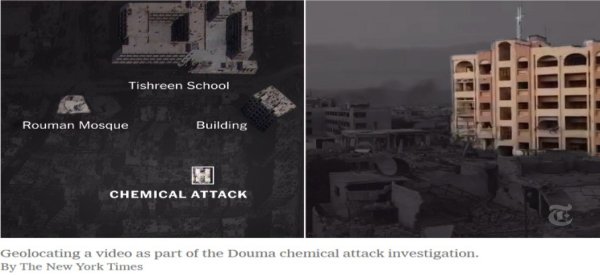

(가) 장소 확인

넓은 화각으로 촬영된 사진이나 영상은 촬영된 지역의 랜드마크를 포함할 수 있습니다. 예를 들어 모스크나 다리, 식별할 수 있는 빌딩, 알려진 산이나 강 등이 그 예입니다. 이런 특징은 위성 사진이나 구글의 스트리트 뷰와 대조해 사진이 촬영된 곳을 파악할 수 있습니다. 국내 언론의 탐사보도에서도 일부 활용하는 방법이지만, 체계적인 방법론이 전수되거나 교육이 이뤄지지는 않고 있는 지점입니다.

왜냐하면 실제 획득한 영상에선 이런 랜드마크가 보이지 않는 경우가 많고, 확인할 수 있는 건 거리의 표지판이나 나무, 간판 등이 전부이기 때문입니다. 이런 경우 영상 속 오디오에 주의를 기울여야 하고, 가능하다면 현지인과 접촉해 장소를 식별하는 데 도움을 받아야 합니다.

(나) 날짜 확인

사건의 정확한 날짜와 시간을 결정하는 것은 더 어려운 작업입니다. 뉴욕 타임스는 메타데이터가 없는 영상에서 날짜를 확인하기 위해 날씨 데이터를 자주 사용합니다. 물론 이것만으로 정확한 날짜를 확인할 수 없어서 사건 관계자와 목격자를 인터뷰해 교차검증합니다.

(다) 시각 확인

사진이나 영상에서 그림자의 방향과 길이를 확인합니다. 여기에 태양의 궤적을 확인할 수 있는 SunCalc(suncalc.net) 같은 도구에서 날짜별, 장소별, 시간대별 그림자의 방향, 길이와 비교해 촬영된 시각을 확인합니다.

(라) 관계자 확인

날짜와 시각, 장소에 관한 확인이 마무리되면, 사진이나 영상에 대한 좀 더 세밀한 분석이 이뤄집니다. 군인이나 경찰, 무장단체의 경우 피아식별이나 소속을 나타내는 표식이나 표장을 부착합니다. 아울러 군사 장비나 민간장비는 특징, 상표, 일련번호 등을 확인해 세부 정보를 확인합니다. 이때는 군사훈련이나 퍼레이드 때 촬영한 사진이나 영상, 광고와 비교하는 등 아카이브를 적극적으로 활용합니다.

(4) 오정보 경고

확보한 사진이나 영상이 맥락에서 벗어나거나 잘못된 정보를 퍼뜨리는 데 사용되는 것을 발견하면 소셜 미디어를 통해 해당 콘텐츠가 신뢰할 수 없다는 경고를 공개적으로 알린다.

3) 주요 기사

기초 절차에 대한 이해를 바탕으로 뉴욕 타임스가 지난 수년간 취재해온 결과물을 분석했습니다.

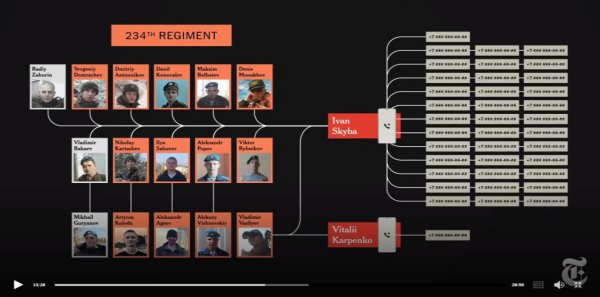

가) “카메라에 잡히고, 전화로 추적됐다: 부차에서 수십 명 학살한 러시아 부대(Caught on Camera, Traced by Phone: The Russian Military Unit That Killed Dozens in Bucha)”

(1) 보도 시점: 2022년 12월 22일

(2) 보도 참여: Yousur Al-Hlou, Masha Froliak, Dmitriy Khavin, Christoph Koettl, Haley Willis, Alexander Cardia, Natalie Reneau and Malachy Browne

(3) 내용 요약: 뉴욕 타임스가 시청각 자료를 활용해 2022년 우크라이나 부차에서 일어난 민간인 학살 주체가 러시아군 제234 근위공중강습연대라는 사실을 입증해냈습니다.

(4) 주요 내용

뉴욕 타임스 시각조사팀은 우크라이나 부차와 미국 뉴욕에서 8달이 넘는 취재를 진행했습니다. 이 과정에서 수천 시간의 영상을 분석했습니다. 스트리트캠과 주민들의 휴대 전화, 우크라이나군이 띄운 드론 영상을 이용해 러시아군의 움직임을 시간 단위로 분석했습니다.

그 결과 러시아군의 한 단일부대가 야블룬스카 거리를 점령했다는 걸 확인했습니다. 해당 부대가 남기고 간 문서와 당시 촬영된 영상, 음성이 증거이고, 이를 바탕으로 부대의 위치와 사망자의 위치를 매핑해 시간적으로 공간적으로 연결했습니다.

해당 부대를 식별하기 위해 장갑차의 표식과 스트리트캠에 녹음된 교신 음성에서 지휘관의 코드네임을 확인했습니다. 아울러 러시아군 병사들이 우크라이나인 사망자의 휴대 전화로 러시아에 건 통화 내역을 우크라이나 당국으로부터 받아 그 번호를 소셜 미디어에서 추적했습니다. 장갑차의 표식과 지휘관의 코드네임은 러시아군 제234 근위공중강습연대의 것이었고, 전화의 수신자는 234연대 소속의 장병들과 직접적 관련이 있는 사람들이었습니다.

아울러 뉴욕 타임스는 이미지 분석과 목격자 및 234연대 소속이었던 일부 병사의 진술을 통해 당시 학살이 우발적인 게 아니라 체계적이고 계획적이었다는 사실도 확인했습니다.

나) “시각적 증거는 이스라엘이 가자 지구 민간인들에게 안전을 위해 이동하라고 명령한 곳에 2,000파운드 폭탄을 투하했다는 걸 보여준다(Visual Evidence Shows Israel Dropped 2,000-Pound Bombs Where It Ordered Gaza’s Civilians to Move for Safety)”

(1) 보도 시점: 2023년 12월 21일

(2) 보도 참여: Robin Stein, Haley Willis, Ishaan Jhaveri, Danielle Miller, Aaron Byrd and Natalie Reneau

(3) 내용 요약: 이스라엘이 하마스와의 전쟁 초기 가자지구 주민들에게 남쪽으로 피란을 종용한 뒤 주민들이 대피한 가자 남부에 2백 발이 넘는 2천 파운드 폭탄을 투하한 것을 위성 사진과 인공지능을 활용해 밝혀냈습니다.

(4) 주요 내용

이스라엘과 하마스 전쟁 초기, 이스라엘은 원활한 지상 작전을 위해 가자지구 북부 주민들에게 남부로 피란 갈 것을 종용했습니다. 그런데 이스라엘은 자신들이 제시한 대피로와 안전지대라고 선포했던 남부에 2천 파운드짜리 폭탄을 투하했습니다. 이때 사용한 건 MK-84, 미군이 베트남전과 이라크전, 아프가니스탄전 등에서 적을 타격하기 위해 쏟아부었던 그 폭탄입니다.

뉴욕 타임스는 이스라엘이 얼마나 많은 MK-84를 가자 남부에 투하했는지 파악하기로 했습니다. MK-84가 투하됐을 때 작게는 40피트, 크게는 60피트의 크레이터가 생긴다는 점에 착안했습니다. 인공지능에게 40피트에서 60피트 사이의 원을 학습시켜 위성 사진에서 이를 찾도록 했습니다. 인공지능은 1,600개의 원을 가자 남부 위성 사진에서 찾아냈습니다. 뉴욕 타임스 시각조사팀은 1,600개의 원이 그림자이거나 물탱크이거나 과거 전쟁에서 형성된 크레이터인지 일일이 가려냈습니다. 그 결과 208개의 크레이터가 확인됐습니다.

이스라엘은 피란을 종용하면서 동시에 가자 남부에 왜 2백 발이 넘는 2천 파운드 폭탄을 떨어뜨렸는지 답하지 않았습니다. 하마스가 인구 밀집 지역에 병력이나 시설을 숨겼고, 이스라엘은 이를 제거하기 위해 폭탄을 투하했을 가능성이 큽니다. 그렇지만, 미국은 이에 대비해 125파운드짜리 정밀유도폭탄 GBU-39도 함께 공급하고 있습니다. GBU-39는 TNT 37파운드의 화력에 위험반경이 1,122피트에 이릅니다. 반면 이스라엘은 TNT 945파운드의 화력에 위험반경이 3,280피트에 이르는 MK-84를 집중 투하했습니다. 그리고 개전 이후 미국이 이스라엘에 추가 공급한 MK-84는 5천 발이 넘습니다.

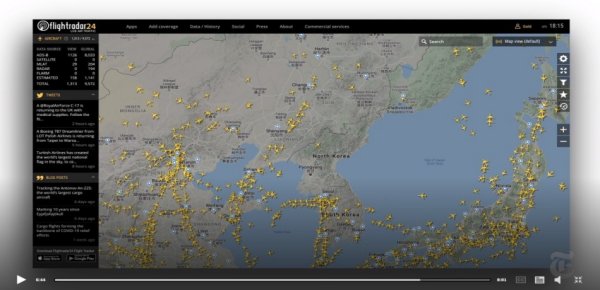

다) “김정은은 어디에? 전문가들이 북한 지도자를 추적하는 방법(Where Is Kim Jong-un? How Experts Track North Korea’s Leader)”

(1) 보도 시점: 2020년 4월 25일

(2) 보도 참여: Christoph Koettl, Robin Stein, Drew Jordan, Ainara Tiefenthäler and David Botti

(3) 내용 요약: 위성 사진, 조선중앙방송, 항적 추적, 휴민트(HUMINT) 등, 통상적인 접근과 취재가 어려운 북한 지도자를 추적하기 위해 전문가들이 활용하는 방법을 뉴욕 타임스가 알려줍니다.

(4) 주요 내용

분석가들은 위성 사진을 비교해 변화를 감지합니다. 예를 들어 평양 시내 대형 종합병원 앞에 여러 대의 똑같은 메르세데스 벤츠가 동시에 주차돼 있다면 이는 김정은이 병원을 방문했다는 뜻입니다. 암살 예방을 위해 국가원수가 움직일 때 같은 형태의 방탄 차량이 함께 움직인다는 점에 착안하면 됩니다. 그리고 원산에 김정은의 전용 열차가 정차해 있다면 이는 김정은이 그곳을 방문했다는 뜻입니다.

그러나 위성 사진만으론 명확한 사실을 파악할 수 없어서 전문가들은 조선중앙방송에 주의를 기울입니다. 2008년 김정은의 아버지 김정일이 뇌졸중으로 쓰러졌을 때 조선중앙방송은 김정일의 동정을 보도하지 않고, 과거 영상만 계속 틀었습니다. 당시 이상을 감지한 미국 언론은 워싱턴 D.C.의 정보기관을 통해 김정인 뇌졸중으로 쓰러졌고 혼수상태였다는 걸 확인했습니다.

다음으로 중요한 건 비행기의 항적 추적입니다. 북한은 상업 항공의 운항이 많지 않기 때문에 예정돼 있지 않은 항적의 등장은 특별한 이벤트입니다. 중요한 물자나 사람이 이동은 종종 이렇게 이뤄지기 때문에 항적 추적으로 이상을 감지하면 다른 루트를 통해 확인이 필요합니다.

이처럼 위성 사진과 조선중앙통신의 방송, 항적 추적은 북한 지도자와 관련해 이상을 감지하는 주요 포인트고, 이와 관련된 사실을 확인하기 위해 최종적으로 정보당국이나 정보원 등 휴민트(HUMINT)를 활용하는 구조입니다.

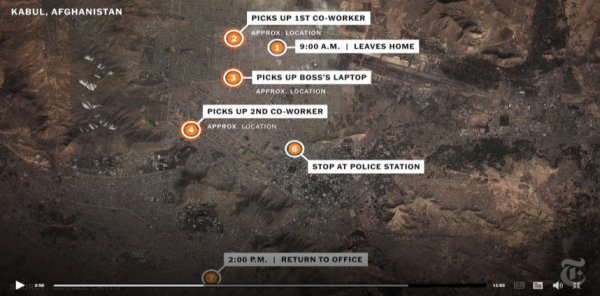

라) “미국의 드론 공격이 어떻게 엉뚱한 사람을 죽였나(How a U.S. Drone Strike Killed the Wrong Person)”

(1) 보도 시점: 2021년 9월 10일

(2) 보도 참여: Christoph Koettl, Evan Hill, Matthieu Aikins, Eric Schmitt, Ainara Tiefenthäler and Drew Jordan

(3) 내용 요약: 2021년 8월 29일 아프가니스탄 카불에서 일어난 미군의 민간인 오폭 사건이 왜 어떻게 일어났는지 뉴욕 타임스 시각조사팀이 파헤쳤습니다. 취재 결과 미국 구호단체의 아프가니스탄 현지 직원이 일상적인 출근과 업무를 위해 이동한 것을 미군은 의심스러운 행동으로 오판했습니다. 미군은 그의 차량에 폭발물이 있으리라 추정하고 드론으로 미사일을 쐈지만, 차량엔 폭발물이 없었습니다. 이에 미군은 민간인 3명이 숨졌다고 사건을 축소 은폐하려 했지만, 어린이 7명을 포함해 민간인 10명이 숨진 것으로 드러났습니다. 미 국방성은 뉴욕 타임스 보도 뒤 “비극적인 실수”였다고 잘못을 자인했습니다.

(4) 주요 내용

2021년 8월 29일 미군은 드론 MQ-9 리퍼 드론에 장착된 헬파이어 미사일로 아프가니스탄 카불의 하미드 카르자이 국제공항 인근의 한 민가를 폭격했습니다. 타겟은 흰색 토요타 코롤라 차량과 제마리 아흐마디라는 40대 남성이었습니다. 미군은 공항을 노린 차량폭탄테러를 모의한 것으로 의심돼 폭격했고, 민간인 3명이 숨졌다고 주장했습니다.

뉴욕 타임스가 현장 취재를 통해 확보한 보안 카메라 영상과 당시 위성 사진, 전문가 취재를 통해 미군의 거짓말을 밝혀냈습니다. 피해자 제마리 아흐마디는 미국 캘리포니아 패서디나에 본부가 있는 Nutrition and Education International 소속 아프가니스탄 현지 직원이었습니다. 오폭 당일 그의 출근길은 카불 시내 곳곳에서 동료를 태우고, 사무실로 오는 평범한 일상이었습니다. 잠시 뒤 그는 이미 탈레반이 점령한 경찰서를 방문해 앞으로 진행할 구호물자 배급을 위한 승인을 받고, 사무실로 돌아왔습니다. 미군은 이 움직임이 수상하다고 판단했습니다. 그가 어디서 일하는 누군지는 확인하지도 않았습니다.

퇴근 후 집으로 돌아온 제마리의 집은 카불 국제공항 인근이었습니다. 집엔 자기 가족과 형제의 가족 등 대가족이 살고 있었고, 차는 집 안 마당에 주차됐습니다. 아이들은 평소처럼 그의 차 주위에서 놀고 있었습니다. 이때 미군의 MQ-9 리퍼 드론이 날아와 20파운드짜리 헬파이어 미사일 1발을 발사했습니다. 미군은 제마리의 차에 공항을 공격할 대규모 폭발물이 실려있었다고 판단했습니다. 이 공격으로 어린이 7명을 포함한 민간인 10명이 숨졌습니다.

제마리의 가족들은 억울함을 호소했습니다. 미군은 테러 예방 목적이었고, 민간이 3명이 죽었다는 거짓말만 반복했습니다. 뉴욕 타임스는 현장을 찾아갔습니다. 제마리와 동료들의 집, 사무실에 장착된 보안 카메라에선 일상적인 출근길 모습만 보였고, 미군이 폭발물이라고 주장했던 건 노트북 가방과 비닐봉지, 빈 물통이었습니다.

결정적으로 제마리의 차엔 폭발물이 들어있지 않았습니다. 미군은 당초 헬파이어 미사일 공격에 이은 차량 내 폭발물의 연쇄 폭발로 피해가 컸다고 주장했습니다. 그러나 뉴욕 타임스가 자문을 구한 복수의 전문가는 폭발물이 들어있지 않았다며 몇 가지 근거를 제시했습니다. 먼저 대규모 폭발물에 의해 2차 폭발이 있었다면, 차량 옆 건물의 벽과 담벼락이 무너져 내려야 했지만, 담이든 벽이든 멀쩡했습니다. 그리고 헬파이어 미사일이 만든 크레이터 주변의 나무나 풀숲이 2차 폭발이 있었다면 불타야 했지만, 이 또한 멀쩡했습니다. 순전히 헬파이어 미사일에 의한 직접 타격과 폭발, 여파로 흩날린 파편이 어린이 7명을 포함한 민간인 10명을 숨지게 했습니다.

미 국방성은 뉴욕 타임스의 보도 1주일 만에 잘못을 인정했습니다. “비극적인 실수”였다면 민간인 10명을 죽인 사실도 인정했습니다. 20년 만에 철수로 마무리된 아프가니스탄 전쟁에서 미군이 마지막으로 죽인 건 구호 활동을 펼치던 죄 없는 민간인과 그 가족들이었습니다.

나. 워싱턴 포스트

1) 연혁

워싱턴 포스트 시각법과학(Visual Forensics) 분야의 첫 보도는 2020년 4월 25일 게재됐습니다. 제목은 바다에서의 팬데믹(The Pandemic at Sea), 분류는 정치 섹션이었습니다. 12분 25초 분량의 다큐멘터리와 다른 한 편의 멀티미디어 기사로 구성된 이 보도는 코로나19로 현장 취재가 제한된 상황에서 대중이 게재한 소셜 미디어 영상과 유람선의 항적 추적 결과를 바탕으로 카리브해와 대서양으로 오가는 유람선이 어떻게 코로나19를 전파했는지, 유람선을 운영하는 선사의 과실을 무엇이었는지 파헤쳤습니다.

이후 워싱턴 포스트의 시각법과학팀이 정착하는 데 큰 영향을 준 사건이 발생합니다. 같은 해 5월 25일 미니애폴리스에서 경찰의 과잉 진압으로 숨진 조지 플로이드 사건입니다. 워싱턴 포스트는 닷새 뒤 스트리트캠과 주변 차량의 블랙박스, 사건 현장 주위에 있었던 시민들의 촬영 영상을 활용해 사건의 경과를 생생하게 보여줬습니다.

그리고 이틀 뒤 워싱턴 D.C.에선 경찰의 공권력 남용에 항의하는 대규모 집회가 벌어졌습니다. 이 과정에서 트럼프 정부의 연방 경찰은 라파예트 광장에 모인 군중에게 가스탄과 고무 파편이 든 수류탄을 던지며 강경 진압에 나섰습니다. 워싱턴 포스트는 당시 시민들이 촬영한 영상에서 경찰 유니폼을 식별해 어디 소속의 경찰이 동원됐고, 그들이 어떤 무장을 어떻게 사용했는지, 진압 작전의 구체적인 경과를 분석해냈습니다. 이 보도는 그해 권위 있는 보도상인 듀퐁상을 수상했습니다.

코로나19로 시작해 조지 플로이드 사건으로 정착한 워싱턴 포스트의 시각법과학팀은 러시아-우크라이나 전쟁으로 다시 한번 도약하는 계기를 맞습니다. 광범위한 살상이 벌어지는 현대전의 특성상 현지 취재가 어렵다는 제약은 소셜 미디어를 통해 이미지를 수집하는 이를 분석해 보도에 활용하는 시각법과학 기반 보도의 가치를 더 높였고, 워싱턴 포스트 2022년 4월 영상과 그래픽, 탐사보도 분야를 강화 및 통합해 시각법과학팀을 확대 개편했습니다.

The Visual Forensics team, led by executive producer Nadine Ajaka, uses cutting-edge technologies to locate, verify and analyze open-source, on-the-ground videos from major news events, providing readers around the world with a closer examination of how complex news moments unfolded. The team also works closely with the Graphics and Photo staffs to present and analyze video in breaking news situations, leading the industry visual verification and authenticity.

당시 이를 알리는 기사에서 워싱턴 포스트가 정의한 시각법과학팀의 역할은 다음과 같습니다. 시각법과학팀은 최첨단 기술을 사용하여 주요 뉴스 이벤트의 현장 영상을 찾고, 검증하며 분석합니다. 이를 통해 전 세계 독자에게 복잡한 뉴스 상황이 어떻게 전개되었는지를 더 자세히 살펴볼 기회를 제공합니다. 이 팀은 그래픽 및 사진 스태프와 긴밀히 협력해 속보 상황에서 영상을 제시하고 분석함으로써 업계에서 시각적 검증 및 진위 확인을 선도하고 있습니다. 뉴욕 타임스의 시각 조사 정의가 좀 더 규범적이라면 워싱턴 포스트의 시각법과학 정의는 좀 더 기능적입니다.

2) 주요 기사

가) 우크라이나 전쟁의 참혹함을 폭로하는 비디오 데이터베이스(Database of videos exposes the horrors of war in Ukraine)

(1) 보도 시점: 2022년 5월 9일 게재 이후 2023년 1월 28일까지 업데이트

(2) 보도 참여

- 취재: Sarah Cahlan, Joyce Sohyun Lee, Meg Kelly, Atthar Mirza, Elyse Samuels, Samuel Oakford, Jon Swaine, Razzan Nakhlawi, Jonathan Baran, Joy Sharon Yi, JM Rieger, Jason Aldag, Karly Domb Sadof, Dalton Bennett, Louisa Loveluck, Monica Rodman, Adriana Usero

- 디자인 및 개발: Shikha Subramaniam, Leo Dominguez, Gabriel Florit, Atthar Mirza, Joe Fox, Jason Bernert

- 그래픽: Dylan Moriarty

- 글: Samuels, Ruby Mellen, Samuel Oakford, Sarah Cahlan, Meg Kelly

- 편집: Matt Callahan, Reem Akkad, Nadine Ajaka and Ann Gerhart

- 교열: Vanessa Larson

(3) 내용 요약

2022년 2월 24일, 러시아군이 우크라이나로 진격하고 미사일이 키이우를 공격하기 시작하자 우크라이나 국민은 휴대 전화로 영상을 찍기 시작했습니다. 이 덕분에 전 세계가 우크라이나 국민의 눈을 통해 러시아-우크라이나 전쟁을 볼 수 있었습니다.

주민과 군인이 촬영한 새로운 비디오가 매일 등장했습니다. 영상은 하늘을 가로지르는 미사일과 연기가 나는 마을의 폐허를 보여줬습니다. 또, 거리에 쓰러졌거나 집단 매장지에서 발굴된 살해된 민간인의 모습도 담았습니다. 이런 시각적 증거는 전쟁 범죄 기소에 중요한 역할을 하는 동시에 블라디미르 푸틴 러시아 대통령의 전쟁에 대한 전 세계적인 분노를 불러일으켰습니다.

워싱턴 포스트의 시각법과학팀은 러시아의 침공 이래로 이런 영상을 확인하고 분류해 왔습니다. 이 작업은 전쟁 초기에 빠르게 업데이트됐고, 이후엔 주요 사건을 중점에 두고 2023년 1월 말까지 업데이트됐습니다. 영상은 원본 형식으로 업로드됐습니다.

(4) 방법론

워싱턴 포스트의 시각법과학팀은 2022년 2월 24일부터 우크라이나 전쟁 영상을 모니터링하고 검증해왔습니다. 영상의 진위나 조작 여부를 검증하기 위해 다음과 같은 작업을 거쳤습니다.

먼저 영상이 언제 녹화됐는지를 확인할 수 있는 메타데이터와 타임 스탬프를 파악했습니다. 다음으로 영상에 나타난 독특한 랜드마크를 위성 사진이나 구글 어스의 스트리트 뷰와 같은 신뢰할 수 있는 자료와 대조했습니다. 또 기타 시각 자료와 공식 성명, 목격자 증언 및 구두로 된 오디오는 영상을 확인할 때 도움이 되는 맥락을 제공하기 때문에 교차 검증에 활용했습니다. 이어서 영상을 올린 사람의 계정을 검토하고, 영상의 원본 출처를 찾으려고 했습니다. 그 결과로 만들어진 이 데이터베이스의 링크는 취재팀이 온라인에서 영상을 발견한 곳이거나 원본 출처입니다.

영상 검증 과정에서 무기와 군사 장비는 무슨 일이 있었는지 단서를 제공할 수 있어서 취재팀은 군사 전문가와 상담했습니다. 또한 데이터베이스의 일부 영상은 연구자와 같은 검증 그룹에 의해 확인됐지만, 모든 영상은 워싱턴 포스트 시각법과학팀이 독립적으로 확인했습니다.

취재팀이 가짜 영상을 걸러내기 위해 점프 컷이나 중단된 오디오가 있는지, 다른 자료와 일치하지 않는 시각 자료와 오디오가 있는지 검사했습니다. 또한, 구글 등 검색 엔진에서 역 이미지 검색을 실행하고 같은 주제에 대한 다른 게시물을 찾아 이전의 영상이 다른 분쟁에서 온 것인지 확인했습니다. 검증은 철저한 취재, 사실 확인 및 뉴스룸 전체의 협력이 필요했고, 워싱턴 포스트는 검증된 영상만 게시했습니다.

나) “틱톡에서의 증가: 영상은 러시아군이 우크라이나로 접근하는 모습을 드러낸다(The TikTok buildup: Videos reveal Russian forces closing in on Ukraine)”

(1) 보도 시점: 2022년 2월 11일

(2) 보도 참여: Paul Sonne, Joyce Sohyun Lee, Mary Ilyushina, Ruby Mellen, Atthar Mirza

(3) 내용 요약: 워싱턴 포스트 시각법과학팀은 2022년 2월 24일 러시아의 우크라이나 침공 이전에 틱톡에 올라온 영상을 수집해 러시아군이 우크라이나로 접근하고 있다는 걸 알렸습니다.

(4) 주요 내용

보도가 이뤄질 당시 블라디미르 푸틴 대통령 등은 러시아가 우크라이나에 대한 침공을 준비하고 있다는 사실을 부인해왔습니다. 그러나 틱톡과 다른 소셜 미디어 플랫폼에 게시된 영상이 보여준 건 푸틴 등의 주장과 달랐습니다.

우크라이나 국경 근처의 러시아와 벨라루스 지역 주민은 러시아 무기와 군용 차량이 철도와 도로를 지나 우크라이나 접경의 진지를 향해 이동하는 걸 보여주는 영상 수백 개를 올렸습니다. 군사 분석가들은 이런 영상을 바탕으로 러시아군이 침공을 앞두고 있다는 점을 파악했습니다.

핵심 증거는 대규모 탱크 부대가 도로는 달리는 점이었습니다. 일반적으로 탱크를 운송할 때는 먼 거리는 열차로 이동하고, 가까운 거리에선 트레일러로 옮깁니다. 그런데 대규모 탱크 부대가 도로로 이동하는 건 최종 집결지 근처에 이르렀다는 뜻입니다.

틱톡에 올라온 한 탄도미사일이나 다연장 로켓 부대의 영상도 핵심 증거 가운데 하나입니다. 우크라이나 국경 근처의 러시아 마을에선 개와 함께 산책하던 남성이 이스칸데르 탄도미사일 발사대로 보이는 물체를 포착했습니다. 다른 소셜 미디어에 올라온 영상에선 대형 다연장 로켓 발사대가 러시아 도시 쿠르스크 인근 도로와 다른 곳에서 이동하는 모습이 포착됐습니다. 서방 전문가와 언론이 러시아의 우크라이나 침공 가능성을 이미 크게 보고 경고했던 이유입니다.

6. 비주얼 포렌식스의 한계와 도전과제

가. 기술적 한계

1) 기술 발전 속도에 따른 한계

가) 디지털 기술의 발전: 비주얼 포렌식스는 계속해서 발전하는 디지털 기술의 영향을 받습니다. 새로운 조작 기법이 등장할 때마다 기존의 포렌식 도구와 기법은 빠르게 무용지물이 될 수 있습니다. 예를 들어, 딥페이크 기술이 빠르게 발전함에 따라 기존의 이미지 조작 탐지 방법은 충분하지 않게 되었습니다.

나) 복잡한 조작 기법: 딥러닝을 사용한 조작 기법은 매우 정교하여 인간의 눈으로는 식별하기 어려운 경우가 많습니다. 이러한 기술적 발전은 포렌식 전문가들이 따라잡기 어려운 속도로 발전하고 있습니다.

2) 데이터의 한계

가) 메타데이터의 조작 가능성: 이미지와 영상 파일에 포함된 메타데이터는 중요한 포렌식 단서가 될 수 있지만, 이 역시 쉽게 조작될 수 있습니다. 조작된 메타데이터를 통해 원본 파일과 같은 형태로 위조된 이미지를 만들 수 있습니다.

나) 데이터의 불완전성: 공개된 데이터나 소셜 미디어에서 수집된 데이터는 불완전하거나 신뢰할 수 없는 경우가 많습니다. 이러한 데이터의 품질은 포렌식 분석의 정확성에 직접적인 영향을 미칩니다.

3) 분석 도구의 한계

가) 분석 도구의 제한: 현재 사용되는 많은 포렌식 분석 도구는 특정 유형의 조작을 탐지하는 데 최적화되어 있습니다. 예를 들어, 픽셀 무결성 검사나 메타데이터 분석 도구는 특정한 조작 기법을 발견하는 데 유용하지만, 복잡한 딥페이크나 GAN(Generative Adversarial Network) 기반 조작을 식별하는 데는 한계가 있습니다.

나) 자동화의 어려움: 포렌식 분석 도구는 여전히 많은 수작업이 필요하며, 완전한 자동화가 어려운 경우가 많습니다. 이는 시간과 인력 자원의 큰 소비를 초래합니다.

나. 윤리적·법적 한계

1) 개인정보 보호

가) 프라이버시 침해: 비주얼 포렌식스는 종종 개인의 이미지나 영상을 분석하는 과정에서 개인정보 보호 문제를 일으킬 수 있습니다. 특히, 동의 없이 개인의 이미지를 수집하고 분석하는 것은 법적 문제를 초래할 수 있습니다.

나) 데이터 수집의 윤리성: 공개된 소셜 미디어 데이터나 인터넷상의 이미지를 분석할 때, 데이터 수집의 윤리적 문제도 고려해야 합니다. 데이터의 출처와 사용 목적을 명확히 하고, 데이터 수집 과정에서의 프라이버시를 존중해야 합니다.

2) 법적 문제

가) 법적 책임: 비주얼 포렌식스 결과를 근거로 법적 판단을 내릴 때, 그 책임은 매우 큽니다. 잘못된 분석 결과는 무고한 사람을 범죄자로 만들거나, 진범을 놓치는 결과를 초래할 수 있습니다.

나) 증거의 인정 여부: 법원에서 비주얼 포렌식스 결과가 증거로 인정되는지는 법적 체계와 관할권에 따라 다릅니다. 디지털 증거의 신뢰성과 적법성을 증명하는 것은 복잡한 과정이 될 수 있습니다.

다. 대응 방안

1) 기술적 대응

가) 기술 개발 및 연구: 지속적인 기술 개발과 연구를 통해 새로운 조작 기법에 대응할 수 있는 포렌식 도구를 개발해야 합니다. 딥러닝과 인공지능을 활용한 새로운 분석 기법을 도입하여 딥페이크와 같은 고도화된 조작을 식별하는 데 주력해야 합니다.

나) 표준화: 포렌식 분석 도구와 기법의 표준화를 통해 다양한 조작 기법에 대응할 수 있는 통합된 시스템을 구축해야 합니다. 이를 통해 분석 결과의 신뢰성을 높일 수 있습니다.

2) 교육 및 인식 제고

가) 전문가 교육: 비주얼 포렌식스 전문가를 양성하기 위한 교육 프로그램을 개발하고, 최신 기술과 기법에 대한 지속적인 교육을 제공해야 합니다. 이를 통해 전문가들의 기술적 역량을 강화할 수 있습니다.

나) 대중 인식 제고: 대중에게 비주얼 포렌식스의 중요성과 조작된 이미지의 위험성을 알리는 캠페인을 전개하여, 허위 정보에 대한 경각심을 높여야 합니다.

3) 법적 대응

가) 법적 체계 강화: 디지털 증거의 법적 인정 여부를 명확히 하고, 비주얼 포렌식스 결과를 법적으로 보호할 수 있는 체계를 구축해야 합니다. 이를 통해 분석 결과의 신뢰성을 높이고, 법적 분쟁에서의 활용도를 높일 수 있습니다.

나) 국제 협력: 허위 정보와 조작된 이미지의 국제적 확산에 대응하기 위해 국제적인 법적 협력을 강화해야 합니다. 벨링캣처럼 증거 인증 분야에서 강점을 보이는 집단, 포렌식 아키텍처처럼 사건 재구성에 강점을 보이는 집단 등과 협업해 글로벌 차원에서의 대응 방안을 마련할 수 있습니다.

4) 윤리적 대응

가) 윤리적 가이드라인 개발: 비주얼 포렌식스의 윤리적 문제를 해결하기 위해 윤리적 가이드라인을 개발하고, 이를 준수해야 합니다. 개인정보 보호, 데이터 수집의 윤리성, 분석 결과의 신뢰성 등을 포함한 윤리적 기준을 마련해야 합니다.

나) 프라이버시 보호 강화: 분석 과정에서 개인의 프라이버시를 보호하기 위한 기술적, 법적 방안을 마련해야 합니다. 데이터 익명화, 동의 절차 강화 등을 통해 개인정보 보호를 강화할 수 있습니다.

7. 결론

2022년 하반기 비주얼 포렌식스를 처음 알게 됐습니다. 이후 2년 동안 다양한 기사와 논문, 보고서를 통해 그 가치와 한계에 대해서 조금이나마 이해하게 됐습니다. 미국 언론과 한국 언론이 발을 딛고 서 있는 지형이 달라서 우리가 비주얼 포렌식스를 도입한다고 하더라도 미국 언론만큼의 성과를 낼 수 있을지, 경제성이 있을지는 여전히 의문입니다. 다만, 언론사에서 비주얼 포렌식스가 필요한 가장 근본적인 이유는 팩트체킹에 있어서 일정부분은 그 역량을 강화할 필요가 있다고 생각합니다. 다음은 이에 기반한 정책적 제언입니다.

1) 제보 영상 접수 시스템에 접목

언론사에서 직접 촬영하거나 제작하지 않은 사진과 영상을 가장 많이 다루는 곳은 제보 영상 접수 시스템입니다. 이곳엔 금전적 이득을 노리고, 영상을 올리는 사람도 있고, 허위 정보를 유포하기 위해 영상을 올리는 사람도 있습니다. 따라서 위변조된 영상이나 딥페이크가 침범하기 가장 쉬운 루트가 됩니다.

이 때문에 언론사의 제보 영상 접수 시스템은 비주얼 포렌식스의 가장 기본적인 단계부터 도입해야 할 곳입니다. 그건 바로 역 이미지 검색입니다. 사진이나 영상의 섬네일, 특정 프레임을 역 이미지 검색으로 조회만 해도 과거 영상이나 합성 등 위변조된 영상 등을 상당 부분 걸러낼 수 있습니다.

여기에 덧붙여 무료 또는 유료 소프트웨어 가운데 증거 인증에 특화된 소프트웨어를 도입하고 일선에서 활용한다면 해당 언론사의 제보 영상 접수 시스템은 보안에서 흔히 얘기하는 일종의 방화벽을 갖추게 되는 셈입니다.

2) 팩트체킹 역량 강화를 위한 비주얼 포렌식스 도입

그동안 대다수 언론사의 팩트체킹은 말이나 글의 형태로 유통될 수 있는 정보에 초점이 맞춰져 있었습니다. 그렇지만, 인공지능이 강화되고 딥페이크가 너무나 쉽게 만들어지는 사회에선 소셜 미디어에서 소비되는 사진과 영상에 대한 팩트체킹이 보도 측면이나 국민의 미디어 리터러시 강화 측면에서도 중요합니다. 따라서 팩트체킹 부서를 별도로 운영하는 언론사라면 비주얼 포렌식스 역량을 강화해 앞으로의 변화에 대비할 필요가 있습니다.

3) 탐사보도 역량 강화를 위한 비주얼 포렌식스 도입

탐사보도 또는 심층보도 말이나 글의 형태로 유통되는 정보에만 너무 초점이 맞춰지면 ‘보여주기’가 아닌 ‘설명하기’ 형태의 기사, 다큐멘터리가 되는 경향이 강합니다. 안 그래도 어렵고 복잡한 내용이 ‘보여주기’가 아닌 ‘설명하기’ 형태라면 읽던 독자도, 보던 시청자도 떨어져 나갈 겁니다. 비주얼 포렌식스는 기본적인 증거 인증을 넘어 확인한 증거를 통해 사건을 재구성할 때도 큰 도움을 줍니다. 앞에서 살펴본 포렌식 아키텍처의 분석이나 뉴욕 타임스, 워싱턴 포스트의 기사가 대표적인 예시입니다. 이렇게 사진과 영상에 기반해 그래픽으로 재구성된 사건은 독자나 시청자가 사건을 이해하기도 쉽겠죠.

4) 내부 윤리적 기준 마련

비주얼 포렌식스를 도입하지 않더라도 소셜 미디어 등 오픈소스에서 수집하는 사진이나 영상과 관련해선 내부 윤리적 기준 마련이 필요합니다. 왜냐하면 무분별한 이미지 수집과 분석 과정에서 개인정보를 침해하거나 데이터 수집의 윤리성, 분석 결과의 신뢰성을 위협할 수 있기 때문입니다.

- 1 Raahat Devender Singh et al. (Jan. 10, 2018), “The Art and Science of Digital Visual Media Forensics”, Journal of Forensic Legal & Investigative Sciences.

- 2 Allie Yang. (Mar. 12, 2024), “It’s harder than ever to identify a manipulated photo. Here’s where to start”, National Geographic.

- 3 Raahat Devender Singh et al. (Jan. 10, 2018), “The Art and Science of Digital Visual Media Forensics”, Journal of Forensic Legal & Investigative Sciences.

- 4 Preeti Sharma et al. (Oct. 1, 2022). “Comprehensive analyses of image forgery detection methods from traditional to deep learning approaches: an evaluation”. Multimedia Tools and Applications.

- 5 Khurshid Asghar et al. (Feb. 8, 2016). Copy-move and splicing image forgery detection and localizationtechniques: a review. Australian Journal of Forensic Sciences(49).

- 6 Ibid.

- 7 Preeti Sharma et al. (Oct. 1, 2022). “Comprehensive analyses of image forgery detection methods from traditional to deep learning approaches: an evaluation”. Multimedia Tools and Applications.

- 8 Richard Lloyd Parry. (Nov. 7, 2008). "Kim Jong Il: digital trickery or an amazing recovery from a stroke?". The Times.

- 9 John Garth. (Nov. 8, 2008). “Doubts linger over North Korean leader's health as new photos show him inspecting the troops”. Daily Mail.

- 10 Raahat Devender Singh et al. (Jan. 10, 2018), “The Art and Science of Digital Visual Media Forensics”, Journal of Forensic Legal & Investigative Sciences.

- 11 대한민국 정책브리핑. (2020.03.05.). 청와대 “문 대통령 ‘왼손 국기에 대한 경례’ 사진, 허위 조작”.

- 12 김범현. (2021.01.21.). “'말문 막히면?'…문대통령 회견 '조작·왜곡 사진' 무차별 확산”. 연합뉴스.

- 13 Ibid.

- 14 @nanpinQD. (Jun. 16, 2022). “難民、セックス恐喝”. Twitter.

- 15 Joscha Weber. (Jul. 8, 2022). “Fake content targets international media”. Deutsche Welle.

- 16 Jonathan Beale. (Apr. 9, 2022). “Ukraine war: Disbelief and horror after Kramatorsk train station attack”. BBC.

- 17 @BBCNewsPR. (Apr. 13, 2022). “We are aware of a fake video with BBC News…”. Twitter.

- 18 Elisabeth Kagermeyer. (Apr. 14, 2022). “#Faktenfuchs: Angebliches BBC-Video über Kramatorsk ist Fake”. BR24.

- 19 Taylor Matthews. (Jan. 23, 2023). “Deepfakes, Fake Barns, and KnowledgefromVideos”, Synthese (2023) 201:41.

- 20 Ian Goodfellow et al. (Jun. 10, 2014). “Generative Adversarial Nets”. arXiv:1406.2661(2014).

- 21 Ian J. Goodfellow et al. (Jun. 10, 2014). “Generative Adversarial Nets”. Advances in Neural Information Processing Systems 27 (NIPS 2014).

- 22 @sternenko. (Mar. 16, 2022). “Президент РФ обьявил о капитуляции россии. Русский солдат, бросай оружие и иди домой, пока жив!”. Twitter.

- 23 Vladimir Putin. (Feb. 21, 2022). “Address by the President of the Russian Federation”. Kremlin.

- 24 Rachel Baig. (Mar. 18, 2022). “The deepfakes in the disinformation war”. Deutsche Welle.

- 25 Ibid.

- 26 Richard Lloyd Parry. (Nov. 7, 2008). "Kim Jong Il: digital trickery or an amazing recovery from a stroke?". The Times.

- 27 Raahat Devender Singh et al. (Jan. 10, 2018), “The Art and Science of Digital Visual Media Forensics”, Journal of Forensic Legal & Investigative Sciences.

- 28 Ibid.

- 29 Ibid.

- 30 Ibid.

- 31 Julia Bayer. (Dec. 6, 2023). “How do I spot a deepfake?”. Deutsche Welle.

- 32 Timmi Allen et al. (May. 31, 2015). “Forensic Analysis of Satellite Images Released by the Russian Ministry of Defense”. Bellingcat Investigation.

- 33 Israel Defense Forces. (Oct. 18, 2023). “Failed Rocket Launch by Islamic Jihad Hits Al Ahli Hospital in Gaza City”.

- 34 Eyal Weizman et al. (Feb. 15, 2024). “Israeli disinformation: Al Ahli Hospital”. Forensic Architecture.