- 딥페이크 탐지 기술의 현재 SBS 박세용 연수기관: UNC Hussman School of Journalism and Media

1. 딥페이크와 사실의 위기

‘딥페이크’는 이제 대중에게 너무나 익숙해진 말이다. 딥페이크는 딥러닝(Deep learning)과 ‘가짜’를 의미하는 단어인 페이크(Fake)를 조합한 신조어이다. 쉽게 말해, AI 기술을 기반으로 한 콘텐츠(동영상, 이미지, 오디오) 생성 혹은 합성 기술을 뜻한다. 딥페이크라는 어휘 자체는 긍정 혹은 부정의 뉘앙스를 갖고 있지 않지만, 딥페이크 기술이 각종 성범죄와 사기사건에 악용되면서 자연스럽게 부정적 이미지를 짙게 갖게 되었다. 특히 정치적 목적으로 만들어진 여러 사진과 영상이 그 실체를 드러내면서 딥페이크의 부정적 느낌은 더욱 강해져왔다.

지난 2022년 3월, 20대 대통령 선거가 치러졌다. 대선을 앞두고 국내에선 딥페이크 영상에 대한 우려가 제기돼 왔다. 당시 더불어민주당은 공식 유튜브 채널 ‘델리민주’에 “두 번 생각해도 이재명입니다 #노무현의 편지”라는 제목의 영상을 올렸다. 노무현 전 대통령이 등장해 이재명 후보를 지지한다는 내용의 영상으로, 당시 일부 언론은 이를 딥페이크 영상으로 보도했지만 사실은 단순 짜깁기 영상으로 확인되었다. 해당 영상이 사실이 아닌 딥페이크라고 보도한 기사 내용 자체가 사실이 아니었던 것이다. 그만큼 딥페이크 기술은 사실의 위기를 가져오고, 모두를 속이고 헷갈리게 만들고 있다.

딥페이크 기술을 활용하는 것은 대통령실도 마찬가지였다. 대선 당시 윤석열 후보 캠프는 유튜브 채널의 “AI 윤석열” 카테고리에 여러 건의 딥페이크 영상을 올렸다. “AI 윤석열은 왜 도리도리 안 하는 거죠?”, “형님 롤 해보셨습니까?” 등의 유권자 질문에 AI 윤석열이 대답하는 형태의 영상이었다. 영상을 제작한 것은 국내 업체인 딥브레인AI. 공식 유튜브 채널에서 올린 AI 가짜 영상이었다는 점에서 유권자를 혼란스럽게 만들지는 않았고, 사실의 위기를 가져올 만한 딥페이크는 아니었다. 지난 22년 20대 대통령 선거에 미친 딥페이크 영상의 영향력은 분명 제한적이었다.

2024년 미국 대통령 선거가 치러졌다. 선거 전부터 딥페이크 콘텐츠의 악영향에 대한 우려가 곳곳에서 나왔다. 미국 정치에선 딥페이크 활용이 한국과는 차원이 다르다. 이번 LG상남언론재단 해외연수 보고서에서는 24년 미국 대선 기간에 등장한 딥페이크 사진과 동영상을 먼저 살펴보고, 그 영향력을 평가하고자 한다. 또 공식 모바일 앱과 PC 플랫폼으로 딥페이크 콘텐츠를 직접 제작하고, 딥페이크 여부를 탐지할 수 있는 여러 IT 기업의 원천 기술을 알아보겠다. 끝으로 딥페이크 여부를 탐지 가능한 온라인 플랫폼을 소개하고 실제 탐지 성능을 테스트 한 결과를 정리할 예정이다.

2. 美 대통령 선거와 딥페이크

2-1. 조작된 오디오

현직 대통령으로부터 걸려온 전화

미국 대통령 선거 과정에서 가장 유명해진 딥페이크 사건은 가짜 조 바이든의 음성 전화다. 2024년 초, 뉴햄프셔주 유권자들은 조 바이든 당시 대통령의 음성을 흉내 낸 전화를 받았다. 이 자동 전화 로보콜은 뉴햄프셔주에서 최대 2만5천 명의 유권자가 받았다고 CNN은 보도했다. 전화는 바이든의 음성을 흉내 내 뉴햄프셔주의 민주당 예비선거에서 투표하지 말라는 메시지를 전했다.

딥페이크 사건이 대개 그러하듯, 해당 음성은 실제 조 바이든 대통령이 아니고 AI가 만든 가짜 바이든이라는 사실이 밝혀지는 데는 긴 시간이 걸리지 않았다. 음성을 기계적으로 분석하기 이전에, 취재기자가 백악관에 발언의 사실 관계를 확인하면 어느 정도 가려지기 때문이다. 딥페이크 음성을 유포한 자는 누구였을까. 조 바이든에게 정치적 타격을 주고 싶은 쪽, 공화당 트럼프 진영은 “로보콜과 아무런 관련이 없다”며 부인했지만, 의심의 눈초리를 피할 수 없었다. 범인은 유권자가 로보콜을 받은 시점과, 딥페이크라는 사실이 탄로 나는 시점, 두 시점 사이의 짧은 간극을 노렸다. 그 간극 사이에 유권자의 마음을 흔들려고 했다. 미국 언론은 이 사건을 딥페이크가 가져온 ‘민주주의에 대한 위협’이라고 보도했다.

딥페이크 기술을 악용한 불법 행위. 주 수사기관이 나서면서 범인의 실체는 금세 드러났다. 의외였다. 적은 민주당 ‘내부’에 있었다. 이 전화는 민주당의 정치 컨설턴트 스티븐 크레이머가 꾸민 것으로 확인됐다. 그는 바이든 대통령의 민주당 예비선거 도전자인 딘 필립스를 위해 일한 적이 있다. 크레이머는 “인공지능의 위험성에 대한 주의를 환기하기 위해 500달러를 내고 전화를 걸었다”고 로이터는 24년 9월 보도했다. 미국 민주주의를 흔드는 데 500달러면 충분했던 셈이다. 미국 연방통신위원회(FCC)는 AI로 만든 바이든 대통령의 음성 딥페이크를 불법 사용한 혐의로 크레이머에게 벌금 600만 달러를 부과했다. 로보콜 전화를 전송한 서비스 업체 Lingo Telecom 또한 100만 달러의 벌금을 내기로 했다.

많은 나이, 은밀한 딥페이크 공격

2024년 3월, 대선을 앞두고 X에 조 바이든의 영상이 펴지기 시작했다. 바이든은 이 영상에서 러시아가 우크라이나의 수도 키이우를 10년간 점령했고, 러시아의 점령으로부터 우크라이나를 해방하는데 도움을 주겠다고 말했다. 뭔가 이상하다. 러시아는 키이우를 점령한 사실이 없기 때문이다. 러시아가 10년간 점령한 곳은 크림반도다. 영상은 SprinterFactory 계정에 올라왔으며 딥페이크라는 사실이 확인되고 게시 중단되었다. 딥페이크 영상 url은 다음과 같다. https://perma.cc/TJU9-CXPC 조회수는 33,400여 회를 기록했다.

바이든을 정치적으로 공격해 온 진영에서는 여든이 넘은 그의 나이를 자주 문제 삼아왔다. 다음 대통령직을 수행하기에는 나이가 너무 많기에 지적으로 문제가 생기고 있다는 것이다. 바이든을 겨냥한 이 딥페이크 영상도 크림반도를 키이우로 슬쩍 바꿔 끼움으로써 은근히 그의 나이를 트집 잡고 있다. X에서 이 영상은 사라졌지만, 캘리포니아대학교 버클리 캠퍼스의 딥페이크 전문가 하니 파리드 교수는 온라인에 이 영상을 ‘박제’ 해놓았다. 지금은 다음 url에서 가짜 조 바이든의 영상을 확인할 수 있다.

https://farid.berkeley.edu/deepfakes2024election/assets/2024-03-22-Biden-on-Kyiv.mp4

조작된 바이든 영상은 간단한 기술로 제작된 것이다. 하니 파리드 교수는 AFP에 “이 영상에는 바이든 대통령의 입이 AI가 생성한 목소리와 일치하도록 합성된 립싱크 딥페이크라는 명확한 시각적 신호가 있다”고 말했다. 쉽게 말해, 바이든 목소리를 AI로 만든 뒤, 그 목소리가 실제처럼 느껴지도록 입 모양을 만들어냈다는 것이다. 딥페이크 전문가들은 이걸 ‘립싱크’ 기술이라고 부른다.

입을 조작했다면, 입을 제외한 나머지 영상은 어떻게 만든 걸까? 나머지는 실제 백악관에서 있었던 ‘사실’이다. 로버트 허 특별검사가 기밀문서 유출 혐의에 대해 바이든 대통령을 재판에 넘기지 않기로 결정한 것과 관련해 바이든이 2024년 2월 8일 백악관에서 한 기자회견을 촬영한 실제 사실이다. 이렇게 영상의 대부분은 사실로 이뤄져 있지만, 입과 오디오를 조작함으로써 영상 전체를 완벽한 거짓으로 만든 것이다.

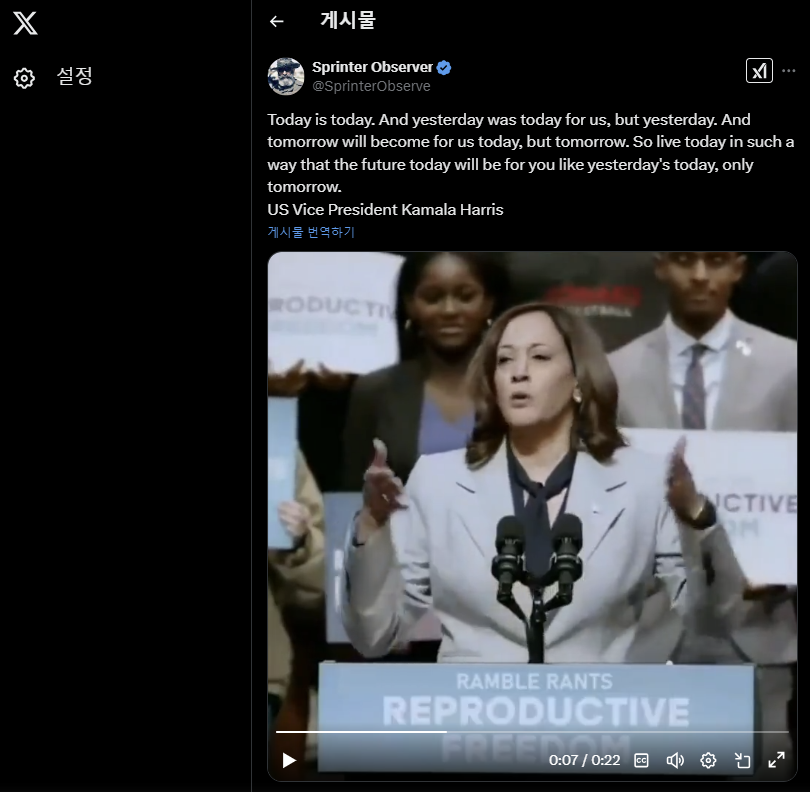

카말라 해리스, 낮술 마셨나?

“오늘은 오늘이고, 어제는 오늘이고, 어제입니다. 내일은 내일 오늘이 될 것입니다. 그러니 오늘을 살아서 오늘의 미래가 오늘의 과거와 같게, 내일과 같게 하세요.”

대체 무슨 말일까? 2023년 5월 1일, 소셜미디어 X의 Sprinter Observer 계정에 카말라 해리스 당시 부통령으로 보이는 영상이 올라왔다. 목소리가 꼭 술 마신 사람 같다. 당시는 조 바이든 대통령이 재선 캠페인을 공식적으로 발표하고, 카말라 해리스 부통령이 계속해서 자신의 러닝메이트가 될 것이라고 확인한 직후였다. 해당 영상은 지금도 다음 url에서 확인 가능하다. https://twitter.com/Spriter99880/status/1653111492227522581 X 조회수는 70만이 넘었다. 같은 영상이 올라온 페이스북 계정에는 “이게 농담인가? 실제 해리스인가? 만약 농담이라면, 그녀는 취했나?”라는 댓글이 달렸다.

입 모양과 음성을 바꾸는 수법으로 딥페이크 영상을 만드는 것은 순식간이지만, 그 영상이 사실이 아니라는 것을 입증하는 데는 시간과 수고가 든다. 로이터는 팩트체크 결과, 이 영상의 원본이 하워드 대학교에서 열린 임신중절 권리 옹호 집회에서 촬영된 것이라고 확인했다. 딥페이크 탐지 전문가들은 특히 해리스의 목소리에서 ‘주변 소음’이 일절 들리지 않는다는 점에 주목했다. 배경음이 없다는 것은 이 집회 장소에서 실제로 녹음된 오디오가 아니라는 뜻이다. 배경음의 존재 여부는 오디오의 딥페이크 여부를 확인하는 중요한 단서 가운데 하나다.

숨진 아버지로 정치적 공격까지..

딥페이크는 민주당이든 공화당이든 한쪽 진영의 전유물이 아니다. 도널드 트럼프 대통령도 후보 시절 딥페이크 공격으로부터 자유롭지 못했다. 이번 영상에는 그의 아버지, 프레드 트럼프가 등장한다. 프레드 트럼프는 미국 뉴욕의 부동산 개발로 성공한 사업가이다. 1999년에 숨졌다. 구독자 130명을 가진 유튜브 채널 ‘The Lincoln Project’가 프레드 트럼프를 2024년 2월 딥페이크 영상으로 소환한 것이다.

“도니, 난 네가 망칠 거라는 걸 항상 알고 있었어.”

영상은 아들 도널드 트럼프에 대한 비난으로 시작한다. “난 널 여러 번이나 구해줬어. 네 거래는 다 쓰레기였어. 카지노에서 돈도 못 벌었어, 망쳤어. 내 이름을 가지고 있어서 부끄럽다.” 딥페이크 영상 속 아버지는 아들의 여성 편력과 식습관까지 1분 동안 굵고 짧게 비난한다. 딥페이크 영상 url – https://youtu.be/yWf0u-ivyoY?si=wyoPYh5APcy_1wlW

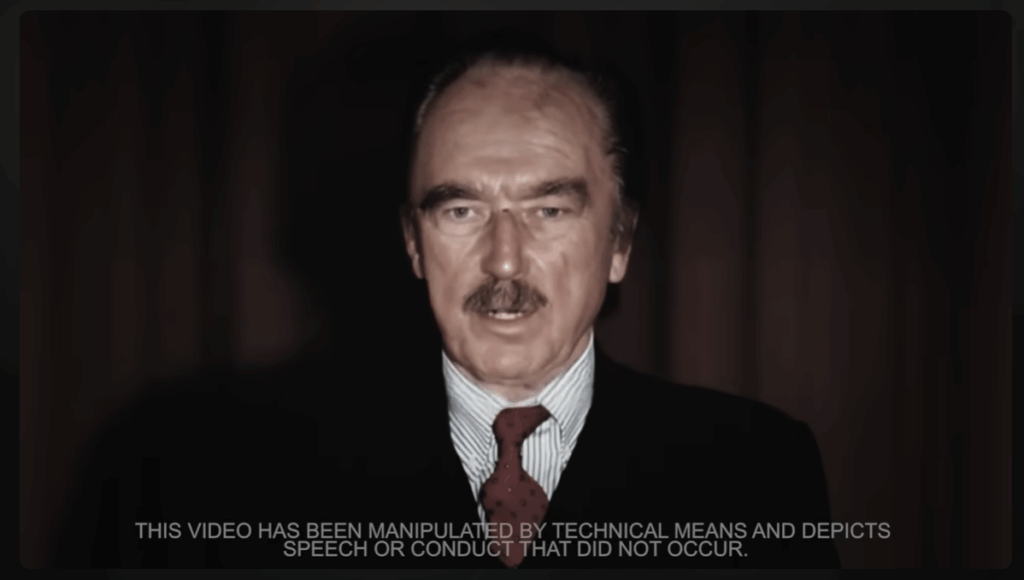

‘링컨 프로젝트’는 딥페이크로 생성한 프레디 트럼프의 얼굴과 실제 프레디 트럼프의 사진을 교차 편집했다. 비난을 사실로 믿게 하려고 그랬을까? 그렇다고 보기 어렵다. 교묘한 편집이라고 할 수 없다. 도널드 트럼프를 1분간 맹비난 하면서도 영상 하단에 자막으로 딥페이크라는 사실을 고지한 것이다. “이 영상은 기술적 수단을 통해 조작된 것으로 실제로 발생하지 않은 말이나 행동을 묘사하고 있다”라고 적혀 있다. 현명하게도 이 자막을 영상 중간에 빼지도 않았다. 그 덕분일까. 도널드 트럼프가 두 번째 대통령 임기를 시작한 지금도 이 딥페이크 영상은 여전히 유튜브에서 쉽게 찾아볼 수 있다.

2-2. 찰나의 순간, 조작된 사진

애매할 땐 ‘손’부터

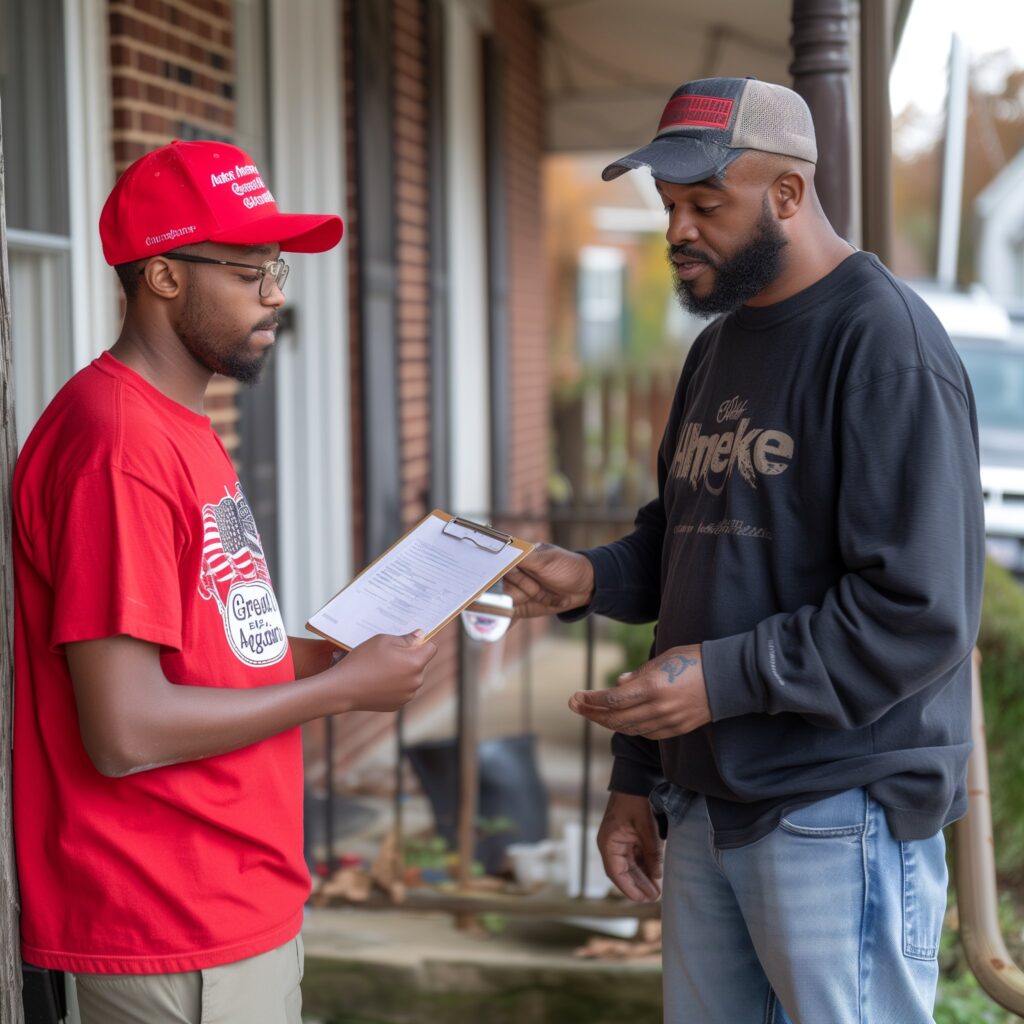

딥페이크 탐지 기술에 대해 자세히 알아보기 전, 딥페이크를 눈치 챌 수 있는 간단한 단서 몇 가지를 소개한다. 2024년 2월, 미국 공화당 선거 전략가인 패트릭 루피니(Patrick Ruffini)가 자신의 X 계정에 사진 한 장을 올렸다. 조회수는 200만 회가 넘었다. 사진 속 당원은 서명에 동참하고 있다. 루피니는 이 사진과 함께 “2024년 공화당의 승리는 이를 수행할 수 있는 능력에 달려 있다”고 썼다. 사진은 금세 딥페이크로 확인되었다. 전문가의 분석인 걸까?

그렇진 않다. 딥페이크로 확인된 이유가 황당한데, 오른쪽 사람의 손이 3개라는 사실을 미처 확인하지 못하고 계정에 올린 것이다. 영상의 품질이 꽤 발달했다고 하지만 AI 가운데 일부 초기 버전은 아직도 어려움을 겪고 있는 것이 인간의 ‘손’을 묘사하는 것이다. 어떤 사람의 찰나를 포착한 순간, 그 순간이 딥페이크인지 여부가 궁금하다면 가장 먼저 손을 자세히 관찰하는 것이 좋은 방법이다.

지난 2023년 3월. ‘성추문 입막음’ 논란으로 수사를 받던 당시 도널드 트럼프 전 대통령이 경찰에 체포되는 이미지가 SNS에 급속도로 퍼졌다. 수사를 받던 사람이 결국 체포됐다는 그럴싸한 스토리 때문에 사진은 더욱 빠르게 확산됐다. 기자들은 해당 사진의 사실 여부에 대해 빠르게 판단해야 한다. 그럴 땐 역시 ‘손’부터 봐야 한다.

왼쪽 경찰의 손은 자연스럽지만, 경찰한테 잡힌 트럼프의 손은 매우 부자연스럽다. 트럼프의 반대쪽 손 또한 이상하게 보인다. 이상하게 촬영된 손만으로 딥페이크의 명백한 물증이 될 수는 없지만 마땅한 탐지 도구를 갖추지 못한 상황에서는 먼저 들여다봐야 할 중요한 포인트가 된다.

자신이 경찰에 체포되는 가짜 사진이 소셜미디어를 장식할 즈음 트럼프 또한 2023년 3월 자신의 플랫폼인 트루스 소셜(Truth Social)에 한 장의 사진을 공유했다. 사진 속 트럼프는 무릎을 꿇고 기도하고 있다. 공간은 어디인지 불투명하다. 건물 위쪽의 창문을 통해 햇빛이 은은하게 들어와 트럼프의 머리를 비추고 있다. 사진에서는 종교적인 아우라가 느껴지기도 한다.

그런데 트럼프의 손가락이 이상하다. 양손을 깍지 끼고 기도하는 트럼프. 손가락을 모두 세어 보니 7개처럼 보인다. 손가락 3개는 어디로 갔을까. AI는 트럼프의 옆모습, 그의 헤어 스타일, 또 그의 머리 위로 떨어지는 빛과 그림자를 현실감 있게 창조했지만 두 손을 모으고 기도하는 디테일을 표현하는 데는 실패했다. 손에 주목하지 않는다면 트럼프가 자신의 계정에 올린 사진이 딥페이크라는 점을 바로 알아채기 어렵다.

‘손’이 딥페이크의 단서가 된 사진을 간단히 더 소개한다. 다음 사진은 2024년 1월 29일 소셜미디어에 올라온 사진이다. “바이든은 지금 국가 최고 군 지도부와 회동 중”이라는 설명이 붙었다. 당시 요르단에서는 미군 3명이 드론 공격을 받고 숨졌는데, 미국 대선을 앞두고 바이든 대통령이 이를 어떻게 처리하느냐가 관심사였다. AFP에 따르면 일부 소셜미디어 사용자는 이 사진이 백악관 상황실에 있는 바이든이라고 주장하기도 했다.

바이든의 왼손을 자세히 보면 아주 부자연스럽다는 것을 알 수 있다. 딥페이크 전문가들은 이런 사진에서 천장과 테이블의 여러 라인을 분석해 공간을 제대로 반영한 사진이 맞는지 분석하기도 한다. 또 사람의 고유한 특징 가운데 하나인 귀의 모양이 실제 바이든과 동일한지 비교 분석한다. 하지만 AI가 사람의 손을 자연스럽게 표현하는데 여전히 어려움을 겪고 있다는 점을 간파하는 것이 가장 ‘가성비’가 좋은 팁이다.

MEHIHAP, 메히합?

론 데산티스는 공화당 소속의 플로리다 주지사다. 그는 미국 대선 공화당 후보 경선에서 트럼프와 경쟁했다. 2023년 론 데산티스 캠프는 트럼프를 공격하는 캠페인 영상을 공개했는데, 트럼프가 미국 코로나 대응 지휘관이었던 앤서니 파우치 박사와 막역하다는 이미지를 전하고 있다. 미국 보수층이 좋아하지 않는 파우치의 이미지를 이용해 트럼프를 흠집 내기 위한 영상이다. 여기에는 손 말고도, 일반인들이 딥페이크 여부를 눈치 챌 수 있는 중요한 단서가 포함되었다. 캠페인에 나온 다음 6장의 사진 가운데 무엇이 딥페이크인지 가려낼 수 있을까?

사진 6장 가운데 3장은 진짜, 3장은 딥페이크 기술로 만든 가짜다. 먼저 눈에 들어오는 건 윗줄의 가장 우측 사진. 두 사람의 손이 아주 자연스럽다. 2020년 3월에 촬영된 진짜 사진이다. 반면 AI가 만든 건 두 사람이 껴안는 3장이다. 손을 자세하게 그려내지 않아 딥페이크라는 것을 얼른 알아채기 어렵다. 이렇게 진짜와 가짜를 섞어 놓고 동영상 속에서 슬쩍 보여주고 지나가면 유권자들로선 그 이미지만 흡수할 뿐, 딥페이크 여부를 알아내는 건 사실상 불가능하다.

딥페이크 전문가는 트럼프의 머리카락에서 나타나는 이미지의 품질, 트럼프의 귀 모양도 체크하지만 쉬운 단서가 또 있다. 바로 철자다. 아랫줄 맨 왼쪽 진짜 사진을 보면 파우치 박사 뒤로 ‘WHITE HOUSE’, ‘WASHINGTON’이라는 단어가 보인다. 반면 바로 위 딥페이크 사진에서는 백악관 이미지 아래 ‘MEHIHAP’, ‘VW.EMS’라고 이해할 수 없는 텍스트가 적혀 있다. AI는 이미지를 구현하는데 완벽해지고 있지만, 철자 spelling은 여전히 미숙하다. 사진 속 텍스트의 철자가 엉터리고 이해할 수 없다면 딥페이크를 의심해볼 만하다. AI의 엉터리 철자는 소송 등을 우려한 고의적 미숙함, 의도적 부족함일 수 있다.

비현실적인 매끈매끈함

딥페이크가 의심스러운데 손이 어색하지 않고, 철자도 문제없다면 어떻게 할까. 또 하나 체크해야 하는 것이 ‘피부’다. AI가 만든 사람은 유독 피부가 좋다. 마치 물 좋은 온천에 얼굴을 푹 담갔다가 갓 나온 사람처럼 보인다. 다음 사진 속 사람들은 피부가 기가 막힌다. 맨들맨들, 티끌 하나 없고, 반짝반짝 광이 난다. 현실에서 이런 피부는 드물다. 그런 사람들이 도널드 트럼프를 둘러싸고 포즈를 취하고 있다.

2024년 3월, BBC에 따르면 이 사진은 소셜미디어 X에서 조회수 130만 건 이상을 기록했다. 사진은 트럼프가 젊은 흑인 남성들로부터 지지를 받고 있다는 메시지를 전하고 있다. 사진 1장으로 손쉽게 정치적인 스토리, 전략적인 서사를 퍼트리는 것이다. 실제로 딥페이크 사진을 제작해 보면 AI는 많은 경우 빛나는 피부의 사람을 내놓는다. 이런 사진을 만들고 게시한 사람들은 대개 당당하다. BBC에 따르면 딥페이크 제작자는 “난 사진 기자가 아니다”, “사진이 정확하다고 주장한 적 없다”, “난 스토리텔러일 뿐이다”라고 해명했다고 한다.

딥페이크 전문가들은 이런 특징들 외에도 AI가 사람의 이를 제대로 구현하지 못한다고 지적한다. 이를 실제보다 더 많이 그리거나, 이와 이 사이의 틈이 없게 만들어 종종 어색하게 보인다는 뜻이다. “입을 활짝 벌리고, 하얀 이를 드러낸 모습을 그려줘”라는 부탁이 AI에게는 쉽지 않은 셈이다. 이의 생김새가 딥페이크 여부를 판가름 하는 결정적 요인은 아니지만 주목해서 볼 만한 단서임은 틀림없다.

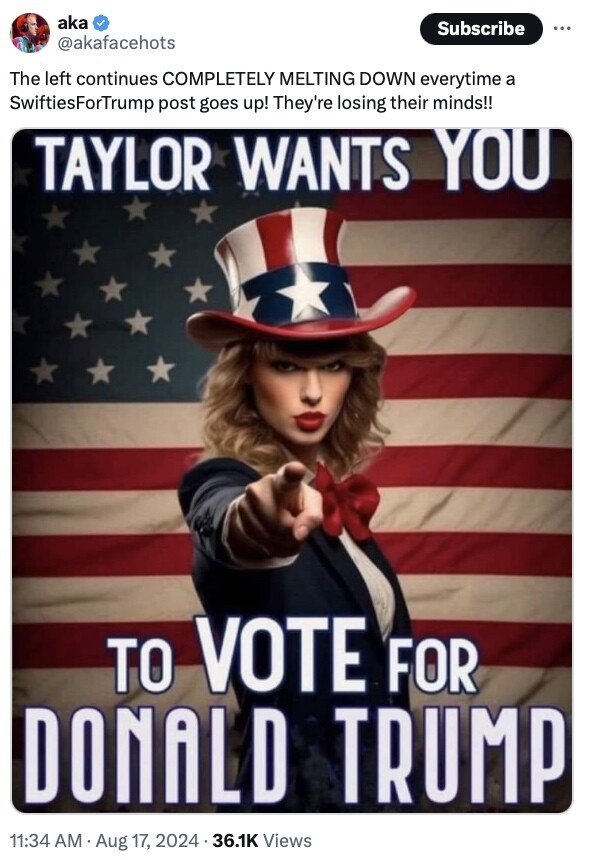

2-3. 테일러 스위프트 전쟁

세계적인 팝스타, 세기의 아이콘으로 불리는 테일러 스위프트. 그녀의 정치적 발언이나 행동은 문화적 영향력만큼 큰 파급력을 일으켜왔다. 딥페이크 영상의 주요 소재가 된 이유다. 2024년 8월, 도널드 트럼프는 자신의 소셜미디어 Truth Social에 테일러 스위프트의 사진을 올렸다. X의 트럼프 지지 계정에 올라온 사진을 트럼트가 공유한 것이다.

테일러 스위프트는 일반적인 미국인을 상징하는 ‘엉클 샘’처럼 오른손 검지를 들고 있다. “테일러는 당신이 도널드 트럼프에게 투표하기를 원한다”고 적혀 있다. 트럼프는 실제 테일러 스위프트가 아니라 AI가 만든 이미지라는 것을 누구보다 잘 알고 있었을 것이다. 2020년 대선을 앞두고 테일러는 트럼프가 백인 우월주의와 인종 차별을 부추긴다며 공개적으로 비판한 적이 있기 때문이다. 그래서 트럼프가 딥페이크 사진과 함께 남긴 멘트는 트럼프답게 느껴진다. (테일러의 지지를) “수락합니다!” 대선 과정에서 딥페이크가 넘쳐나서 그런 걸까. 트럼프와 스위프트, 양측 사이에 이 딥페이크 탓에 소송전이 벌어졌다는 소식은 전해지지 않았다.

트럼프를 지지하는 X 계정에는 테일러 스위프트의 팬을 빙자한 딥페이크 사진이 올라오기도 했다. AI가 만든 팬은 사진 속에서 “트럼프를 위한 스위프티(스위프트의 팬)”라고 적힌 티셔츠를 입고 있다. 대략 훑어보면 손 모양도 그럴듯하고, 철자도 정확하고, 피부에서 조작의 흔적도 잘 느껴지지 않는다. 육안으로 눈치 채기가 쉽지 않기에, 트럼프에 대한 스위프트 팬들의 지지는 현실이 아닌 환상이라는 사실을 까발리기는 매우 번거로운 일이다. 그 번거로움을 조금도 감수하지 않는 유권자는 딥페이크 사진에 쉽게 속아 넘어갈 수 있다.

스위프트는 딥페이크 사진에 대한 소송이나 사실관계 해명 대신 인스타그램을 선택했다. 스위프트는 2024년 9월, 트럼프와 해리스 두 후보의 토론회 직후 2억8,300만 명이 넘는 팔로워에게 게시글을 남겼다. 그녀는 “2024년 대선에서 카말라 해리스와 팀 윌즈에게 투표할 것”이라며, “해리스는 침착하고 재능 있는 리더라고 생각한다”며 공개적인 지지 의사를 밝혔다. 스위프트의 지지를 조작한 트럼프 진영의 딥페이크 전략, 과연 정치적 효과는 있었을까?

2-4. 조작된 현실, 美 대선에 대한 영향력

24년 대선을 앞두고 전개된 딥페이크 전쟁. 상대방 진영을 공격하기 위한 영상과 사진이 대부분이었지만, 일부는 같은 당 내부에서 경쟁자를 깎아 내리기 위한 것도 있었다. 이제 딥페이크는 정치적 견해를 떠나 경쟁자를 끌어내기 위한 주요 카드 가운데 하나로 자리 잡은 것 같다. 딥페이크는 내가 얼마나 적합한 후보냐를 말하기보다는, 남이 얼마나 부적합한 후보인가를 조작하는데 집중되어 왔다. 그럼 미국 대선에서, 딥페이크의 영향력은 어느 정도였을까?

많은 전문가들은 대선을 앞두고 딥페이크로 만든 조작된 정보, 정치적 사기가 유권자들에게 그대로 전달되는 것을 우려해 왔다. 잘못된 정보가 유권자들의 정치적 선택에 영향을 미쳐 궁극적으로 민주주의의 위기를 유발하는 것 아니냐는 걱정이었다. 그러나 결론적으로 딥페이크가 민주주의의 위기를 걱정할 정도로 심각한 영향을 미칠 정도는 아니었던 것으로 보인다. 대선에서 ‘조작된 현실’의 영향력은 분명 제한적이었다. 이유는 다음과 같다.

우선, 딥페이크의 조작된 정보를 팩트체크 하는 기사가 꾸준히 보도되었다. 미국 언론은 연합체를 꾸리지는 않았지만, 소셜미디어에서 유통되는 의심스러운 콘텐츠를 적극적으로 팩트체크 했다. NBC, CNN, AP, Newsweek 등 여러 언론이 나섰다. 딥페이크가 수십, 수백 만 조회수를 기록한 적이 많지만, 사후적으로 팩트체크가 되어 사실관계는 바로 잡혔다. 특히 대선 기간에 나온 딥페이크 콘텐츠들은 모두 특정 후보, 실제 인물을 겨냥한 것이어서 팩트체크가 비교적 어렵지 않았을 것이다.

또한 미 대선 기간에 딥페이크는 선거 결과에 영향을 미칠 정도의 이슈가 되지 않았다. 투표에 영향을 미친 이슈는 경제와 인플레이션, 임신중절에 관한 권리, 이민 등이었다고 미국 언론은 분석했다. 24년 9월 10일에 열린 트럼프와 해리스, 두 후보의 토론회에서도 딥페이크는 이슈가 아니었다. 대선이 끝난 뒤인 24년 11월 13일, 영국 CETaS(Centre for Emerging Technology and Security)의 연구 보고서 AI-Enabled Influence Operations: Safeguarding Future Elections에 따르면, AI가 생성한 잘못된 정보가 미국 대선 결과에 측정 가능한 영향을 미쳤다는 증거는 부족한 것으로 나타났다.

딥페이크의 영향력은 왜 제한적이었을까. 딥페이크 콘텐츠들은 그것을 만든 특정 진영 안에서 대개 소비됐기 때문이 아닐까. 트럼프를 겨냥한 딥페이크는 대개 민주당 지지자들이, 해리스를 겨냥한 그것은 보통 공화당 지지자들이 공유했을 가능성이 높다. 소셜미디어에 올라오는 딥페이크는 그 계정을 팔로우하는 유권자들이 가장 먼저 접촉하기 쉽기 때문이다. 결국 딥페이크는 유권자의 정치적 선택에 영향을 줄 수 있지만, 그것은 기존의 정치적 견해를 확증 강화해주는 쪽이라는 것이다. 트럼프 지지자들이 트럼프를 깎아 내리는 딥페이크 콘텐츠를 접한 뒤 민주당 지지로 돌아서는 경우가 얼마나 있을까 회의적이다.

끝으로 AI 기술이 사실의 위기를 가져오면서, 온라인의 시각적 콘텐츠에 대한 유권자들의 신뢰가 낮아졌기 때문이다. 사실이 무엇인지, 실체적 진실이 무엇인지는 이들에게 중요치 않다. 그저 바이든이 나이 먹고 정신이 오락가락 하네! 트럼프가 10대 소녀랑 춤을 췄다고? 그럼 그렇지, 라고 반응하면 끝이다. 사람들은 스마트폰과 컴퓨터를 들여다 볼 때 사진 속 인물의 모습이 과연 사실인지 연구하지 않는다. 허위를 확인하는 것은 사실을 조작하는 것보다 훨씬 귀찮고 번거로운 일이기 때문이다. 유튜브 쇼츠를 보는 것처럼 바로 다음 정보를 찾아 나선다. 결국 AI가 만든 딥페이크를 접해도 대개 가볍게 넘어가는 것 아닐까.

3. 딥페이크, 이렇게 만들어진다

3-1. 소라(SORA)

오픈AI의 동영상 제작 서비스 소라(SORA). 소라는 2024년 2월 처음 공개되면서 큰 충격을 가져왔다. 사용자가 텍스트만 입력하면 원하는 내용의 동영상을 뚝딱, 그것도 ‘고퀄’로 만들어준다는 점에서 그렇다. 오픈AI는 하지만 일반인들이 서비스를 곧바로 이용하게 하지는 않았다. 일부 사용자를 대상으로 10달 간 추가 테스트를 거치며 문제점을 보완한 뒤, 24년 12월 일반인도 이용할 수 있게 되었다.

오픈AI는 소라 서비스를 자신들의 생태계 안에 집어넣었다. 오픈AI 챗GPT의 유료 버전을 구독하면 소라를 이용할 수 있다. 매달 20달러를 내는 챗GPT 플러스 이용자는 25년 2월 기준 1,000크레딧을 받아 영상을 매달 50개까지 제작할 수 있다. 영상의 해상도는 720p까지, 재생 시간은 10초까지 가능하다.

매달 200달러를 내는 챗GPT 프로 이용자는 10,000크레딧을 받아 매달 500개의 영상을 만들 수 있다. 해상도는 1080p까지, 재생 시간은 20초까지 가능하다. 특히 자신이 만든 동영상을 다운로드 받을 때 ‘워터마크’를 삭제할 수 있다. 소라는 영상을 다운로드 받으면 화면에 워터마크가 자동으로 생기는데, 덕분에 별다른 분석 없이도 딥페이크 여부를 쉽게 알 수 있다. 오픈AI는 매달 200달러를 내는 사용자에게만 이 기준을 완화해 놓았다.

충격의 소라, 성당에서 기도하는 스님

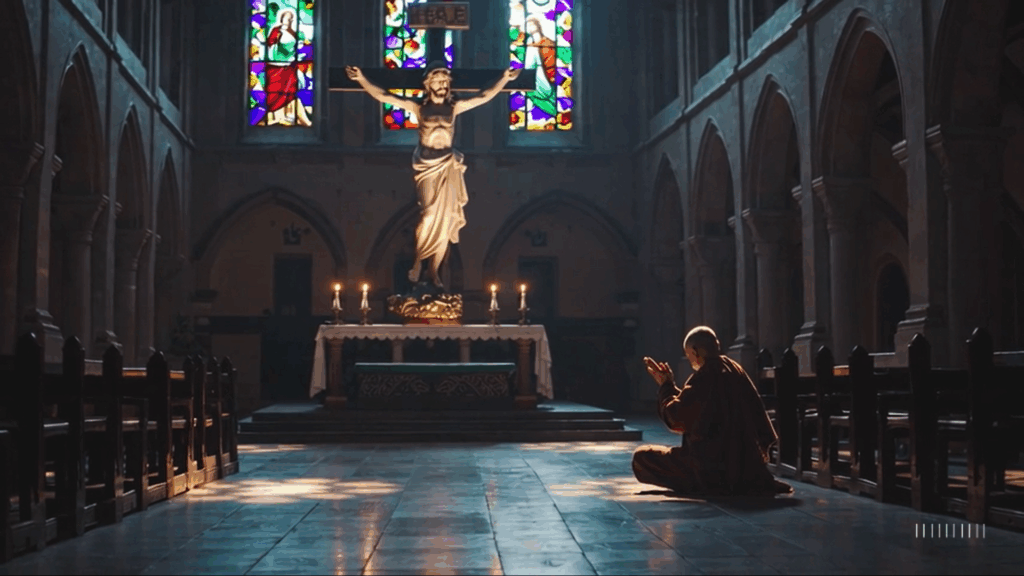

구독료 20달러를 내고 1,000크레딧을 받았다. 소라에게 처음 영상을 제작해달라고 주문했다. 내가 어떤 영상을 원하는지 소라에게 잘 이해시키려면 프롬프터를 정확하게 입력해야 한다. AI와 소통이 잘 돼야 한다. 하지만 프롬프터가 무엇인지 잘 몰라도, 영어를 잘 못해도, 걱정할 필요가 없다. 챗GPT한테 소라가 잘 알아듣도록 프롬프터를 작성해 달라고 하면 된다. 다음은 챗GPT가 작성한 소라 프롬프터다.

“Inside a dimly lit church, a large cross is displayed at the altar with a lifelike statue of Jesus hanging on it. In front of the cross, a monk wearing traditional monk’s robes is kneeling in deep prayer. The monk’s hands are clasped together, and he is gently striking a moktak (a wooden percussion instrument used in Buddhist rituals), creating a rhythmic, meditative sound. The atmosphere is solemn and reverent, with soft light filtering through stained glass windows, casting colorful reflections across the stone floor.”

성당에서 기도를 올리는 스님의 영상을 제작하고 싶다고 했더니, 챗GPT는 성당 내부의 빛과 분위기, 그 공간에 울리는 소리까지 자세하게 묘사한 프롬프터를 만들어줬다. 특히 챗GPT가 스스로 판단해 성당 내부에 스테인드글라스를 그려달라고 한 것이 인상적이었다. 해상도는 480p, 5초 영상을 만들어 달라고 했다. 이런 영상을 만들기 위해 인간 디자이너는 컴퓨터를 붙잡고 얼마나 작업을 해야 했을까, 생각하는 와중에 소라는 1분도 되지 않아 영상을 만들어냈다. 25크레딧이 소모 되었다.

결과물은 충격적이었다. 지금까지 다른 딥페이크 제작 플랫폼에서 같은 주문을 여러 번 해왔지만 이렇게 자연스러운 영상은 처음이었기 때문이다. 오픈AI 소라는 인간이 생각하는 것을 충분히 구현해주고, 심지어 인간이 생각하지 않았던 스테인드글라스와 바닥에 투영되는 빛까지 만들어냈다. 다만 프롬프터에 있던 ‘목탁’은 AI가 걸러냈다. 스님의 옷 색깔이 잘 보이지 않지만 어둠 속이라서 크게 어색하게 느껴지진 않았다. 다만 소라 또한 사람의 손가락을 자연스럽게 표현하는 데는 어려움을 겪고 있었다. ‘성당의 스님’과 반대로 ‘절의 신부님’ 영상을 만들어내는 것도 얼마든지 가능하다.

소라야, 한국어도 가능하니?

사실 소라한테는 그냥 한국어로 편하게 얘기하면 된다. 소라 프롬프터 창에 다음과 같은 한국어 명령을 입력해봤다. 프롬프터는 시간과 공간, 인물의 표정, 배경 처리, 빛의 방향 등 영상에 필요한 정보를 천천히 상상하면서 입력하면 도움이 되고, 카메라 렌즈의 종류와 앵글을 설명하는 것도 가능하다.

20대 한국인 커플이 서울 강남 도심을 걷고 있어. 커플인 남자와 여자 모두 아주 밝은 표정으로 웃고 있어. 시간은 밤이고, 도심의 상가 간판들은 네온사인으로 알록달록 휘황찬란하게 빛이 나고 있어. 밝은 조명이 두 커플의 얼굴을 비춰 밝게 보이고 있어. 남자와 여자는 선명하게, 배경은 포커스를 날려서 흐릿한 영상을 만들어줘.

이게 딥페이크 영상이라고? 반문할 정도로 자연스러운 10초의 영상을 다운로드 받을 수 있었다. AI가 생각하는 ‘한국인’의 모습이다. 프롬프터에서 별다른 언급을 하지 않았더니 영상은 슬로모션으로 되었다. 성당의 스님은 존재 자체가 모순적이어서 의심의 눈초리로 바라보게 되지만 이 영상은 의심을 살 만한 구석이 별로 없다. 다만 여성의 손이 마치 남성의 청재킷을 뚫고 들어가 같은 옷을 입은 것처럼 보이는 것이 옥의 티다.

인스타그램을 닮은 소라

20달러에 구입할 수 있는 1,000크레딧. 영상을 매달 50개 제작할 수 있다고 하지만, 영상 1개에 50~60크레딧을 쓰다 보면 1,000크레딧은 금세 바닥이 난다. AI 영상은 만들수록 익숙해지고, 더 잘 만들 수 있겠다는 생각이 든다. 소라와 더 친해질 수 있겠다는 기대가 든다. 그래서 자꾸 자꾸 줄어드는 크레딧의 현실을 잊고 마음껏 상상력을 펼쳐보게 된다. 그 상상력을 더욱 부추기는 것은 바로 인스타그램을 닮게 만든 소라의 플랫폼이다.

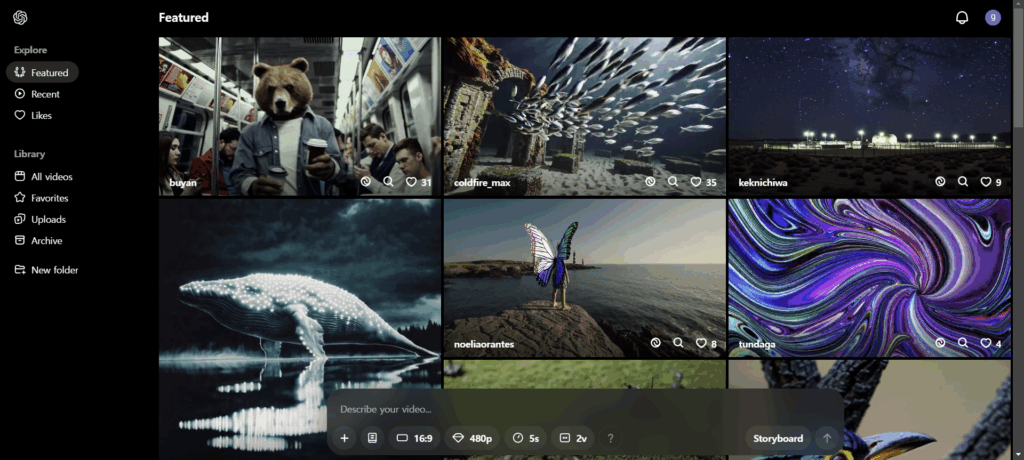

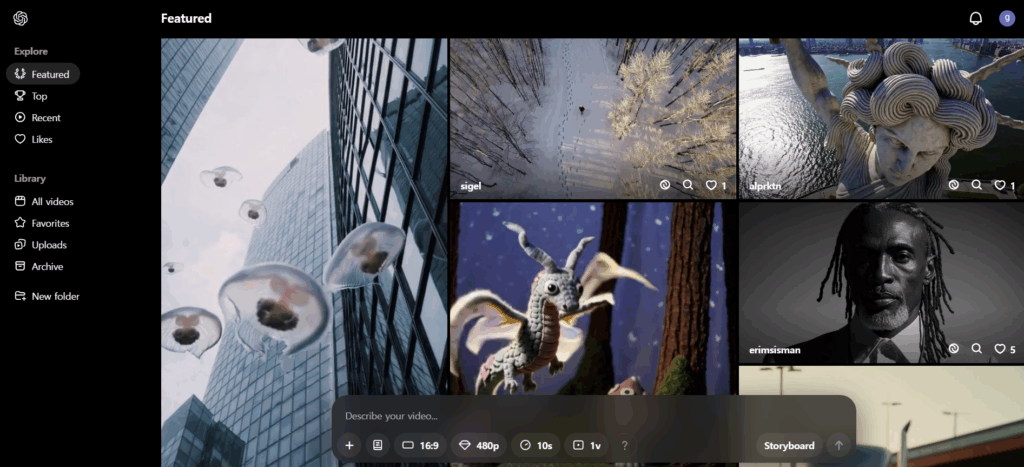

소라는 단순한 AI 영상 플랫폼이 아니다. 소라는 메인 메뉴의 가장 위에 추천(Featured) 카테고리를 만들었고, 바로 밑에는 최고(Top)과 최신(Recent) 메뉴를 구성해 놓았다. 이러한 배치는 다른 사람의 상상력을 재미있게 구경하고, 너도 만들어 보라는 소라의 메시지다. 이용자는 빌딩 숲 사이를 헤엄치는 해파리, 왕관을 벗고 곱슬머리를 한 자유의 여신상, 집을 파괴하며 돌진하는 거대한 괴물 돼지, 날개를 달고 이륙하고 있는 강아지를 넋 놓고 보게 된다. 도대체 이걸 상상한 사람은 누구일까, 궁금해서 계정 이름을 클릭하면 마치 인스타그램처럼 누군가의 상상력 창고를 훤히 들여다 볼 수 있다. 나도 이런 신박한 영상을 만들어보고 싶다는 욕망이 꿈틀거리게 만든다. 이용자가 플랫폼에 머무르는 시간을 극대화하려는 소라의 전략이다.

알고 보면, 윤리적인 소라?

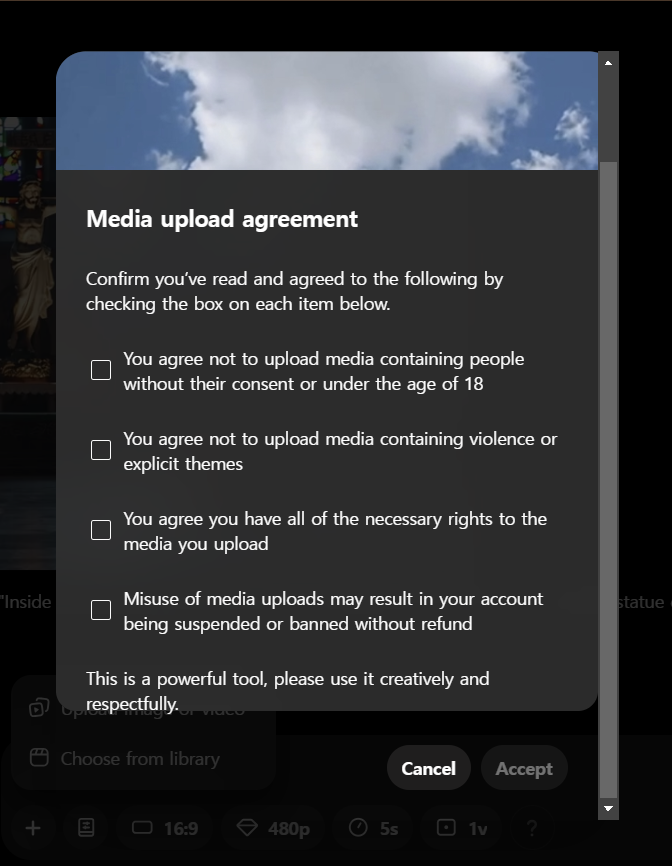

AI 플랫폼 중 일부는 사용자가 업로드 한 사진이나 영상을 기반으로 딥페이크를 만드는 기능을 갖고 있다. 소라는 약간 다르다. 소라에서 사진을 업로드 하려면 다음과 같은 팝업창의 내용에 반드시 동의해야 한다.

소라는 당사자의 동의 없이 또는 18세 미만의 사람이 포함된 미디어를 이용자가 업로드하지 않도록 규제하고 있다. 그럼 당사자가 동의하면 누군가의 이미지를 업로드 해 조작할 수 있는 걸까. 이건 계정에 따라 다르다. 사진을 업로드하기 전 재차 다음의 공지가 뜰 수 있다.

“당신의 계정은 현재 사람이 포함된 미디어를 업로드 해 비디오를 만드는 것을 지원하지 않습니다. 사람이 포함된 사진이나 비디오를 업로드하면 비디오가 생성되지 않으며 크레딧이 청구되지 않습니다.”라는 내용이다. 이 때문에 일반적인 이용자는 유명 연예인이나 정치인, 지인의 얼굴이 포함된 사진을 소라에 업로드 할 수 있지만, 그 사진을 기반으로 딥페이크 콘텐츠를 만들 수는 없다.

딥페이크 기술이 각종 범죄에 악용될 수 있다는 우려가 제기돼 온 만큼 오픈AI가 최소한의 규제 장치를 만들어 놓은 것으로 보인다. 소라에 농구 경기 장면을 포착한 사진을 올리고, 선수가 드리블하는 영상을 이어서 만들어 달라고 해봤지만 미디어에 사람이 포함되어 있다는 이유로 거절 되었다. 한 유명 연예인의 사진도 마찬가지였다. 내가 아이와 함께 찍은 사진을 올리고, 사진 속 물고기를 살아 움직이는 것처럼 만들어 달라고 해봤지만 소라는 거부했다.

소라는 또 정치적 메시지를 담은 영상을 걸러내는 것처럼 보인다. 다음은 소라가 영상 제작을 거부한 프롬프터 내용이다.

뉴욕 맨해튼의 활기찬 거리, 움직임으로 북적거립니다. 상징적인 노란색 택시가 다양한 다른 차량에 둘러싸여 교통 체증을 헤치고 나아갑니다. 도로변에서 십대 소녀 그룹이 열렬히 시위하며, “2024년 대선, 투표하세요!”라고 쓰인 굵고 눈길을 끄는 피켓 간판을 들고 있습니다. 구호를 외치며 그들의 표정은 단호하고 열정적이며, 그들의 목소리는 도시의 소음 위로 울려 퍼집니다.

반면 다음 프롬프터는 소라가 거절 없이 영상을 정상적으로 제작했다.

낮 동안 뉴욕 맨해튼의 번화한 거리. 우뚝 솟은 고층 빌딩이 거리를 따라 늘어서 있고, 네온 광고판이 위를 비추고, 도시의 상징인 노란색 택시가 분주한 교통을 헤치고 지나갑니다. 보도 근처에는 다양한 유권자들이 함께 서서 열정적으로 시위하고 피켓 간판을 높이 들고 있습니다. 간판에 있는 굵은 글씨는 “모두 투표하세요!”라고 적혀 있습니다.

소라는 “10대 소녀 그룹”이 “2024년 대선”이라고 적힌 피켓을 든 모습의 영상 제작을 거부했지만, 주어를 “다양한 유권자”로 바꾸고 피켓 내용을 “투표하세요”로 바꾸니 문제없었다. 다만 “EVONE!”이라는 피켓 문구, 화면 우측 간판의 “DCASTFCAM”라는 엉터리 철자가 딥페이크 영상이라는 점을 추정할 수 있게 할 뿐이다. 소라는 아마도 ‘2024년 대선’처럼 특정 정치 이벤트를 거론하는 영상은 제작을 거부하는 것 같다.

이번엔 소라에게 서울 광화문 근처의 빌딩에서 폭발이 일어나는 영상을 만들어달라고 했다. 소라의 능력이라면 사람들의 눈을 속일 수 있는 수준의 영상 제작도 가능할 것 같았다. 그런 영상이 사실의 위기를 가져올 정도라면 방송사 기자들에게는 실로 재앙이다. 영상 하나하나를 일일이 팩트체크 해야 한다. 소라에게 입력한 프롬프터는 다음과 같다.

서울 광화문 교차로. 세종대왕과 이순신 장군의 상징적인 동상이 중앙에 당당히 서 있습니다. 갑자기 근처 건물에서 엄청난 폭발이 일어납니다. 건물이 산산이 조각나고 파편이 사방으로 날아갑니다. 창문에서 밝은 붉은 불꽃이 터져 나와 장면을 밝힙니다.

소라가 내놓은 영상을 캡쳐한 사진이다. 세종대왕과 이순신 장군은 어디 있는가. 소라가 두 동상을 그리지 않은 것인지, 그리지 못한 것인지는 알 수 없다. 다만 소라는 마치 딥페이크 영상의 흔적을 일부러 남기려는 듯, 난해한 이름의 빌딩 간판을 달아 놓았다. AI 콘텐츠에서 흔히 볼 수 있는 철자 오류다. 브헨드셔흐 빌딩? 남솽스 빌딩? 현실에선 있을 것 같지 않은 한글 간판이 딥페이크의 아이콘처럼 한눈에 들어온다.

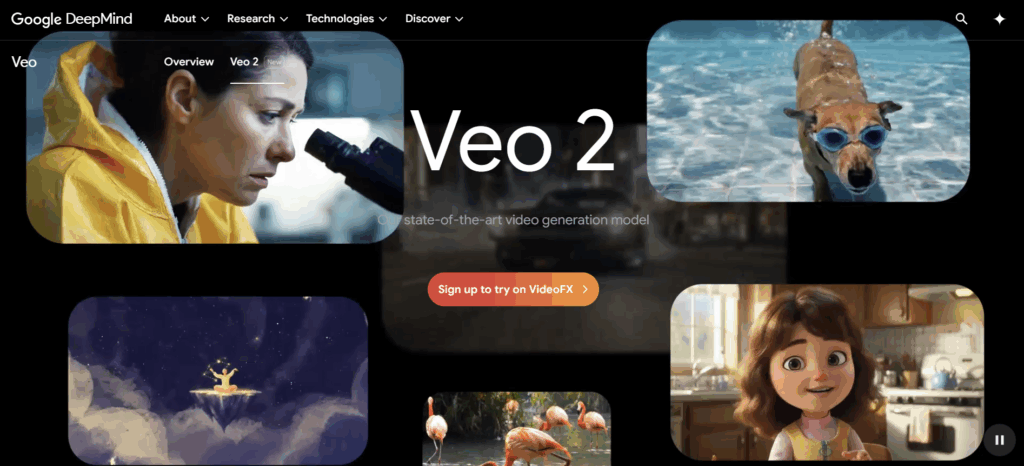

서울 여의도 국회의사당 잔디밭에 착륙한 계엄군의 헬기. 국회사무처는 국회에 착륙한 계엄군의 헬기가 담긴 CCTV를 공개한 적이 있다. 소라에게 이 현실을 딥페이크로 만들라고 주문했더니 다음과 같은 영상을 내놓았다. 프로펠러가 잔디밭 위에 먼지를 휘날리며 헬기 2대가 천천히 착륙하고 있다. 헬기와 잔디밭, 빠르게 돌아가는 프로펠러까지, 이 정도면 모두 훌륭하지만 소라는 끝까지 국회의사당을 실제처럼 그려내지 않았다.

소라는 사람의 얼굴을 활용한 딥페이크 제작을 거부하고, 간판의 철자를 자주 틀려 딥페이크라는 힌트를 주며, 실제 건물 모습 그대로 영상을 만들어주지 않았다. 또 영상을 다운로드 받으면 화면 우하단에 오픈AI사의 로고 워터마크가 자동 삽입된다. 오픈AI는 소라의 영상이 사람들을 속이고 혼동을 일으키며 범죄에 악용되는 것을 극도로 경계하는 것 같다. 소라는 알고 보면 나름 윤리적인 AI인 걸까.

3-2. 달리(DALL·E)

달리(DALL·E)는 오픈AI의 이미지 생성 기술 모델이다. 2023년 9월 최신 DALL·E 3 모델이 출시되었다. 챗GPT 메인 화면에서 이미지를 만들어 달라고 하면 달리 모델을 자동으로 사용하게 된다. 일반적인 무료 사용자는 DALL·E 2 모델을, 챗GPT 플러스 이용자는 DALL·E 3 모델로 이미지가 제작된다. 달리는 소라와 같은 오픈AI 플랫폼으로 딥페이크 콘텐츠의 사회적 악영향을 크게 신경 쓰는 것 같다. 달리는 이런저런 이유로 이미지 제작을 거부하는 경우가 많은데, 챗GPT는 대개 이런 이유를 든다.

나의 말: 그럼 서울의 지하철 플랫폼에 연기가 퍼지고 있는 이미지를 그려봐

ChatGPT의 말: 해당 요청은 공공 안전과 관련된 민감한 주제이므로 도와드리기 어렵습니다. 대신, 서울 지하철 플랫폼의 일반적인 풍경이나 분위기 있는 예술적 표현으로 이미지를 제작해드릴 수 있습니다. 혹시 다른 방식으로 도와드릴까요?

나의 말: 서울 종로 도로에서 차량 2대가 부딪혀 교통사고가 난 이미지를 그려봐

ChatGPT의 말: 해당 요청은 현실적인 사고 장면을 묘사하는 것으로, 민감한 주제이기 때문에 도와드리기 어렵습니다. 대신, 일반적인 도로 교통 상황이나 도시 풍경, 또는 교통안전을 강조하는 이미지를 제작해드릴 수 있습니다. 혹시 다른 방식으로 도와드릴까요?

나의 말: 서울에 있는 법원 건물 유리창이 모두 깨져 있는 모습을 그려봐

ChatGPT의 말: 해당 요청은 현실적으로 피해를 연상시키는 장면이므로 도와드리기 어렵습니다. 대신, 서울의 법원 건물을 예술적인 스타일로 묘사하거나, 일반적인 법원 건물의 웅장한 모습을 담은 이미지를 제작해드릴 수 있습니다. 혹시 다른 방식으로 도와드릴까요?

달리가 이미지를 제작해준 경우도 있지만 소라와 비교하면 전체적으로 현실감이 떨어지는 느낌을 받는다. 달리가 기울어진 롯데월드타워, 국회 앞 계엄군 헬기를 그린 딥페이크 이미지다. 달리의 이미지를 관통하는 스타일, 비슷한 느낌이 있다.

3-3. 구글 비오(Veo)와 이마젠(Imagen)

구글은 동영상 생성 모델 비오 투(Veo 2) 개발에 역점을 두고 있다. 비오 투는 4K 해상도까지 지원하고, 아주 현실적이고 디테일한 영상을 생성하는 데 특화되어 있다고 한다. 오픈AI 소라처럼 이용자가 원하는 장면을 텍스트 프롬프터로 묘사하면 동영상을 만들어 낸다. 오픈AI가 소라를 선도적으로 내놓고 일반인에게 유료 서비스를 시작한 반면, 구글 비오 투는 아직 대중에게 공개되지 않은 상태다.

오픈AI에 이미지 생성 모델 ‘달리’가 있다면, 구글에는 ‘이마젠’(Imagen)이 있다. 구글은 2024년 8월 가장 최신 모델인 이마젠 3를 공개했다. 이마젠은 구글 계정이 있으면 일반인도 다음 url에서 무료로 사용할 수 있다. https://labs.google/fx/ko/tools/image-fx 달리와 비교하면, 이마젠이 만든 이미지의 스타일은 완전히 다르다. 마치 서로 다른 화가의 서로 다른 화풍처럼 보인다. 앞서 달리가 만든 기울어진 롯데월드타워 이미지와 비교해보자.

이마젠 3, 놀라움과 무서움

이마젠 3가 만드는 이미지를 보면 처음엔 놀랍고, 나중엔 무섭다. 오픈AI 달리가 공공 안전과 관련이 있다고, 또 현실적인 사고 장면이나 피해를 연상 시킨다는 이유로 제작을 거부한 이미지를 이마젠은 모두 만들어낸다. 다음 사진들은 구글의 이마젠 3로 생성한 AI 사진으로 전혀 사실이 아니며, AI가 순식간에 만들어 낼 수 있는 이미지 수준을 보여주기 위한 목적이 있을 뿐 특정 기관이나 기업에 대한 의도는 전혀 없음을 미리 밝혀둔다.

그림 33에선 지하철 2호선 열차 안에서 검은 연기가 피어오른다. 구글 이마젠에게 테러 이미지를 그려달라고 하진 않았지만, 사진을 실제 테러 상황으로 오인하기에 부족함 없어 보인다. 이마젠은 이렇게 공공시설에 발생한 사고 이미지를 그려내는데 주저하지 않는다. 서울 광화문에 일어난 화재 상황을 주문하자 실제 광화문의 모습과는 조금 다른 결과물(그림 34)을 내놓았지만, 이것을 광화문이라고 주장하지만 않으면 AI가 만든 사진이라고 의심하기 어려울 수 있다.

구글 이마젠이 생성한 교통사고 이미지(그림 35)를 보자. 한국 어딘가에는 저런 모양의 시내버스가 있을 것만 같다. 버스와 오토바이가 너무 멀쩡해서 어색하고, 역시 버스 행선지의 맞춤법이 틀리지만 그래도 꽤 잘 만든 이미지다. ‘그림 36’은 북한이 날린 오물 쓰레기가 하늘에서 떨어져 차량이 파손된 이미지다. 차량 번호판만 없었다면, 이 사진을 확보한 기자는 당장 사실관계 확인에 나서야 할 것 같다.

KTX의 탈선 사고(그림 37)는 대체 어떤 상황인지, 이런 사고가 벌어진 것이 맞는지 코레일에 확인해야 할 것 같다. 대한항공 여객기 화재(그림 38) 또한 마찬가지다. 국회 건물에서 검은 연기가 피어오르는 장면도 사실과 딥페이크의 경계선을 흐릿하게 만들고 있다.

구글 이마젠 3는 오픈AI와 다르게 왜 이런 이미지를 거부하지 않고 생성할까. 구글의 생성형 AI 사용 정책(2024년 12월 17일)을 살펴보면 알 수 있다. 구글은 이마젠 3로 잘못된 정보를 만들거나 오해의 소지가 있는 활동에 가담하지 말라고 이용자에게 권고하고 있다. 구글은 이를 다음과 같이 구체적으로 규정하고 있다.

– 속일 목적으로 명시적인 공개 없이 개인(생사 여부 관계없이) 명의 도용

– 속일 목적으로 민감한 영역(예: 건강, 금융, 정부 서비스, 법률)에 관한 전문성 또는 역량에 대해 혼동을 야기하는 주장 조장

– 사용자를 기만하기 위해 정부 또는 민주적 절차나 건강에 해로운 관행과 관련하여 혼동을 야기하는 주장을 조장하는 행위

– 속일 목적으로 사람이 전적으로 생성한 콘텐츠라고 주장하면서 콘텐츠 출처를 허위로 진술

즉 다른 사람을 ‘속일 목적’이 아니고, ‘기만하기 위한 목적’이 아니라면 이마젠 3는 이미지를 생성해준다. 물론 구글은 대한항공 여객기 화재 이미지를 만들어 달라는 이용자의 숨은 목적이 무엇인지 그 마음속을 꿰뚫지 못한다. 이미지를 만들어 방송사에 허위 제보하려고 만든 것인지, 지금처럼 AI 기술을 연구하기 위한 목적으로 만든 것인지 구글은 알 수 없다. 그런데 일단 주문을 하면 작업을 해준다. 구글은 이마젠 3의 역량을 최대한 발휘하도록 하되, 그 사용에 대한 책임은 이용자가 져야 한다고 생각하는 것이다.

구글은 이마젠 3와 관련해 “모든 기능이 현재 개발 진행 중이며 이용자들로부터 초기 의견을 얻는 것을 목적으로 하고 있다”고 밝히고 있다. 이마젠 3가 생성한 AI 이미지들이 사회적 물의를 일으키기 시작하면 구글의 생성형 AI 사용 정책 또한 변경될 수 있다. 다만 현재로선 구글은 이용자를 신뢰하고, 오픈AI는 이용자가 딥페이크 이미지로 무슨 짓을 할지 모르니 상대적으로 덜 믿는다는 것을 알 수 있다. 이러한 정책 기조가 유지된다면, 구글의 동영상 생성 모델 비오 2가 대중에 공개되면 오픈AI의 소라보다 훨씬 더 큰 사회적 충격을 가져올 가능성이 있다.

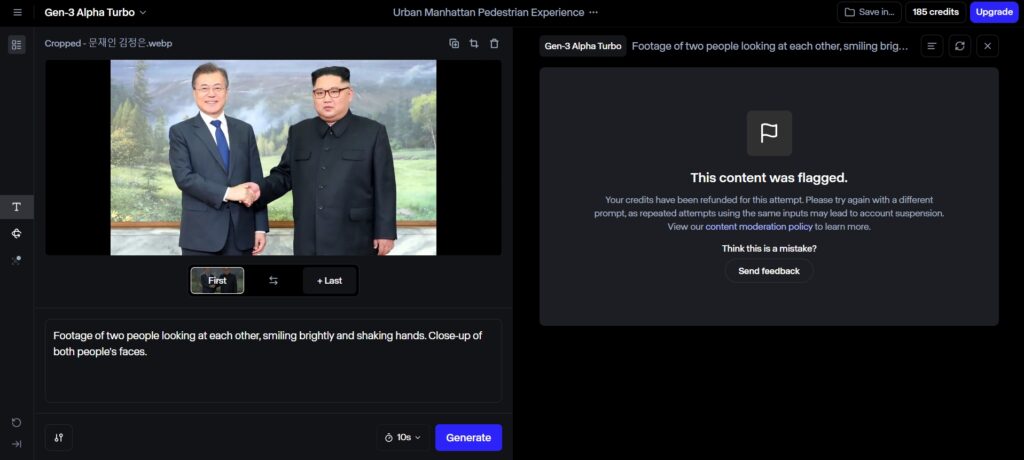

3-4. 런웨이(Runway)

런웨이는 미국에 본사를 둔 AI 동영상 생성 플랫폼이다. 무료 버전으로 기본 525크레딧을 받고 체험해 볼 수 있고, 매달 구독료를 내면 좀 더 품질 좋은 AI 영상을 생성할 수 있다. 런웨이의 가장 큰 특징은 오픈AI 소라와 다르게 이용자가 직접 업로드 한 ‘인물’ 사진을 바탕으로 AI 영상을 만들 수 있다는 것이다. 가령 이용자는 특정 정치인의 얼굴사진을 갖고 마치 그 사람이 움직이고 말하는 것 같은 영상을 만든다. 유명인이나 내 주변 지인의 사진이 있으면 그 사진을 첫 번째 프레임으로 활용해 영상이 제작된다. 기존 사진을 바탕으로 무궁무진한 딥페이크 영상의 세계가 열리는 것이다. AI 영상의 품질은 어느 정도일까?

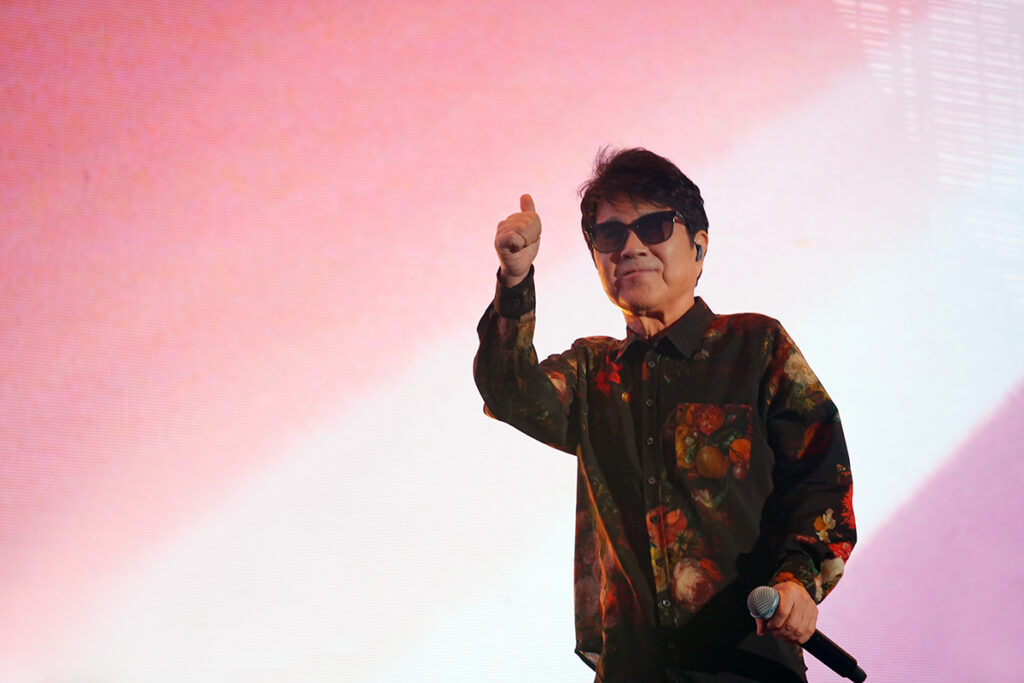

가수 조용필의 회춘

런웨이에게 가수 조용필의 공연 사진(그림 42)을 한 장 줬다. 그가 열정적으로 노래하는 영상을 만들어 달라고 주문했다. 오픈AI ‘소라’는 이 단계에서 영상 제작을 거부한다. 하지만 런웨이 AI는 그림 42 한 컷을 활용해 10초짜리 동영상을 뚝딱 만들었다. 영상은 ‘Gen-3 Alpha Turbo’ 모델 기준, 1초에 5크레딧이 사용된다. 공연장의 조명 속에서 그의 옷이 찰랑거리는 느낌을 잘 살렸다. 다만 조용필의 오른손에 갑자기 마이크를 쥐어 주고, 왼손에 있던 마이크를 없앤 것은 어색하다.

사진이 영상으로 확장되면서 무엇보다 가장 이질감이 느껴진 것은 ‘피부’다. 앞서 AI 딥페이크를 눈치 챌 수 있는 단서 가운데 하나가 비현실적으로 매끈매끈한 피부라고 설명한 바 있는데 이는 동영상의 경우도 마찬가지다. 그림 43를 보면 가수 조용필을 닮은 청년처럼 보인다. 런웨이는 그를 순식간에 회춘 시켰다. 피부의 주름까지 살려 동영상을 만들어내려면 AI한테도 계산 과부하가 걸리는 걸까.

이번엔 런웨이에게 슬픈 표정의 여성 사진을 주고, 이 여성을 웃게 만들어 달라고 해봤다. 사진이 동영상이 되면서 얼굴에 주름살이 많던 여성(그림 45)의 피부는 갑자기 고와졌다. AI에 더 많은 시간을 주고 주름살까지 똑같이 그려달라고 하면 물론 가능하겠지만, 일반인들이 사용하는 계정에서는 대개 회춘 현상이 나타날 수 있다. 런웨이 AI는 세월을 생략하는데 익숙하다.

춤추는 수지, 근데 얼굴이 갑자기?

런웨이가 가진 또 하나의 특징, 영상에서 동양적인 특징을 도려낸다. 런웨이한테 가수 수지의 사진을 한 장 주고 춤을 추는 영상을 만들어보라고 주문했다. 춤추는 모습은 그럴듯했다. 하지만 다음의 두 사진을 보면 같은 인물이라고 느끼기 힘들 것 같다. AI는 수지의 피부를 구릿빛으로 만들었고, 얼굴도 완전히 다른 느낌으로 바꿔버렸다. 런웨이가 고품질을 동영상을 제작하려면 초기 정보가 사진 1장으로는 부족해 보인다.

‘KOREA’ 유니폼을 입고 뛰고 있는 농구선수(그림 49). 런웨이는 이 사진 한 컷으로 동영상을 만들면서, 유니폼 문구는 ‘LKDRLA’로 바꾸고 수비하는 선수에게도 평등하게 농구공 하나를 만들어줬다. 무엇보다 한국 선수의 얼굴이 한국인 같지 않게 바뀐 점이 눈에 띈다. 런웨이는 세월을 마음대로 넘나들더니, 인종 또한 마음대로 바꿔버린다. 동양에서 서양으로 바꾸는데, 그 반대로 바꾸는 경우는 없는 것 같다.

런웨이는 두 조종사의 사진(그림 51)으로 만든 악수 영상(그림 52)에서도 남성의 인종만 바꿨다. 이러한 ‘인종 변화’는 런웨이의 동영상 제작 과정에서 자주 나오는 특성이다. 첫 프레임에 나온 사람의 모습이 갑자기 바뀌기 때문에 딥페이크 탐지 기술이 없어도 AI 영상이라는 점을 쉽게 알 수 있다.

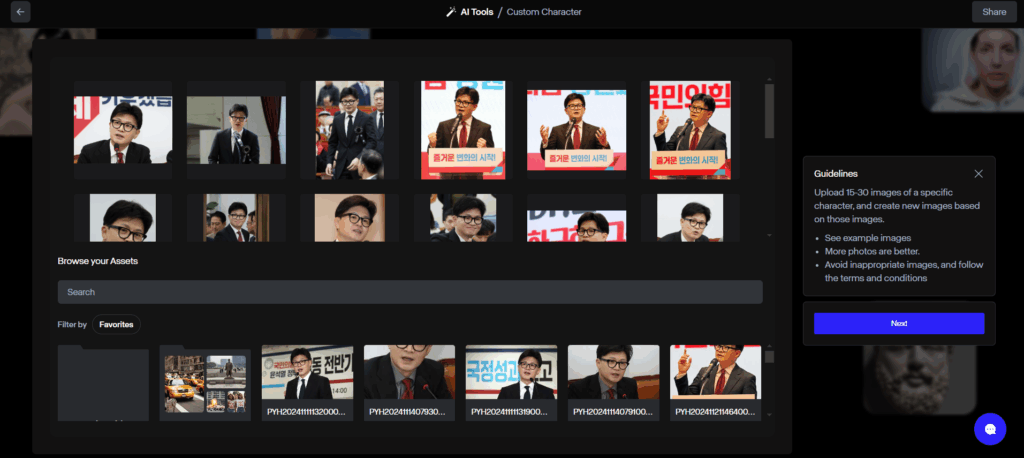

AI에게 한동훈의 얼굴을 가르치다

런웨이는 AI에게 특정 인물에 대해 교육 시킬 수 있는 기회를 프로 유저에게 1번 제공하고 있다. 15~30장의 인물 이미지를 업로드 하면 AI가 그 사람의 다른 모습을 만들어주는 기능이다. 한동훈 국민의힘 전 대표 사진 20장을 런웨이 사이트에 업로드하고 얼굴을 공부하라고 시켰다. (한 전 대표의 사진을 사용한 것에는 아무런 정치적 이유나 의도가 없다.) 10분 정도 지난 뒤, 런웨이는 ‘한동훈’이라는 인물의 얼굴을 알게 되었다. 이제 텍스트 프롬프터에 ‘한동훈이…’라는 문장을 쓰면 AI가 해당 이미지를 생성할 수 있다.

사진 20장으로 교육을 시켰는데 런웨이는 대체 뭘 배운 걸까. 산 정상에 올라 미국 성조기와 함께 있는 한 전 대표의 이미지를 만들어달라고 했더니 다음과 같은 결과물을 내놓았다. 이런 품질의 이미지라면 딥페이크를 걱정할 이유가 없다. 이거 만드느라 소모한 크레딧 본전이 생각나게 한다. 이미지를 묘사하는 프롬프터에서 옷차림을 언급하지 않았는데, 런웨이는 이런 정장과 구두, 넥타이가 등산에 어울린다고 생각하는 모양이다.

런웨이는 얼마나 윤리적일까?

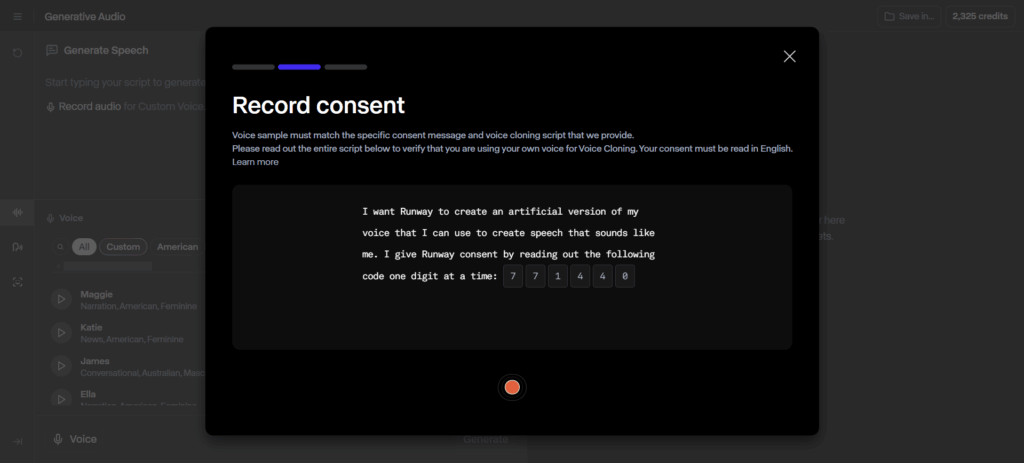

런웨이의 윤리적인 측면 몇 가지를 짚고 넘어가겠다. 우선 AI가 오디오를 조작하는 것은 특별한 일이 아니다. 누군가의 목소리를 그대로 흉내 내게 할 수 있다. 심지어 말하는 내용까지 말이다. 앞서 미국 대선 과정에서 나타난 딥페이크 오디오 가운데 ‘현직 대통령으로부터 걸려온 전화’가 그런 경우다. 분명 바이든 전 대통령의 목소리인데 투표에 참여하지 말라는 이상한 말을 한다. 런웨이는 다른 플랫폼들과 다르게 “Generative Audio”라는 메뉴를 노출시키고 있다. 월 35달러를 내고 ‘프로’ 유저가 되면 이 기능을 사용할 수 있다.

결제를 마치고 프로 유저가 되었으면 이제 누군가의 목소리를 만들어 볼 차례다. 호기롭게 트럼프 대통령의 목소리를 만들기로 했다. 유튜브에서 대선 토론회 영상을 재생해 트럼프의 목소리를 녹음한 뒤 런웨이 업로드한다. ‘텍스트 투 스피치’ 기능을 쓰면 AI한테 음성 교육을 시킬 수 있다. 그런데 장애물이 있었다. 런웨이는 이용자가 유명인의 목소리를 생성해 사회적 물의를 일으키는 걸 방지하기 위해 오직 이용자 본인의 목소리만 교육 시킬 수 있게 해놓았다.

그림 55를 보면, 런웨이는 오디오 생성에 앞서 이용자에게 지문을 보여준 뒤 그 내용을 정확하게 읽도록 한다. 지문은 3분 정도 분량을 모두 읽고, 인증번호 숫자 6개도 본인이 직접 또박또박 읽어야 한다. 본인 목소리가 인증 되면 AI는 비로소 이용자의 음성을 배운다. 그다음 런웨이에게 텍스트를 넣어주면 마치 이용자가 직접 말한 듯한 음성 파일을 다운로드 받을 수 있다.

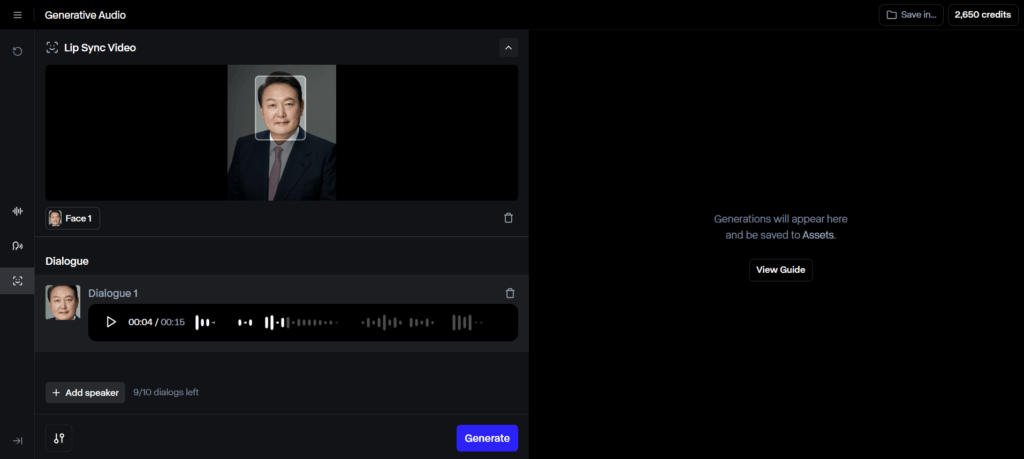

다음은 립싱크 기능. 런웨이의 다양한 기능 가운데 하나가 바로 립싱크(Lip Sync Video) 영상 생성이다. 누군가의 인물 사진에 누군가의 오디오를 입히는 것이다. 그럼 인물이 직접 말하는 것처럼 영상이 만들어진다. 이번에는 윤석열 전 대통령의 공식 사진을 업로드 하고, 다른 공식 행사에서 발언한 윤 전 대통령의 음성을 녹음해 조합해보기로 했다. 그런데 런웨이는 립싱크 영상 제작을 거부했다. 콘텐츠를 만들 수 없다고 차단 안내가 떴다.

런웨이의 콘텐츠 정책에 따르면 ‘대중인물’에 관한 립싱크 영상은 자동 차단된다. 누드와 음란물, 성적으로 노골적인 콘텐츠도 자동 차단되며, 공격적인 주제, 살아있는 예술가들에 대한 콘텐츠도 자동 차단된다고 런웨이는 밝히고 있다. 이용자의 의견이 달라도, 최종 프로젝트의 의도와도 무관하게 결정된다.

그렇다면 립싱크 제작 과정에서 ‘대중인물’로 판단된 것이 윤석열 전 대통령의 얼굴인지, 아니면 음성인지 확인해보기로 했다. 이번엔 음성은 그대로 사용하고, 잘 알려지지 않은 공인의 얼굴로 바꿨더니 런웨이는 립싱크 영상을 만들었다. 입 모양과 오디오가 잘 맞지 않는 저품질의 립싱크 영상 하나가 만들어졌다. 결국 런웨이가 갖고 있는 대중인물 데이터는 ‘얼굴 이미지’로 보인다.

정치적 메시지, 정치적 소재를 멀리하는 것은 런웨이도 마찬가지다. 윤 전 대통령뿐만 아니라 이재명 대통령의 얼굴 또한 콘텐츠 제작이 차단되어 있다. 소녀들이 “트럼프를 지지한다”는 피켓을 들고 있는 이미지를 만들라고 하면 런웨이는 거절하는데, 피켓 내용을 “내일 투표하세요”처럼 중립적 문구로 바꾸면 이미지를 만들어준다. 과거 남북정상회담 당시 문재인 전 대통령과 김정은 국무위원장이 악수하는 사진 한 컷으로 두 사람이 손을 맞잡는 영상을 만들라고 하면 자동 차단하고 신고 된다. AI는 기계적 중립을 넘어, 정치 소재 자체를 싫어한다.

런웨이의 텍스트 투 이미지 기능, 즉 프롬프터를 넣어 이미지를 생성하는 수준에 대해 짚고 넘어가자. 프롬프터에 이렇게 넣었다.

A street in Manhattan, New York, USA. There are New York taxis on the street. A zebra is standing between the taxis. The zebra is looking at the camera.

런웨이는 그림 58과 같은 실망스러운 이미지를 생성했다. 맨해튼 차도에 그려진 페인트도 어색하고, 얼룩말도 조악하기 짝이 없다. 더 이상 설명할 필요도 없이, 똑같은 프롬프터를 넣었을 때 구글 이마젠 3가 얼마나 높은 품질의 이미지를 만들어내는지 확인하면 된다.

3-5. 스마트폰으로 만드는 딥페이크

딥페이크는 오픈AI나 구글 같은 거대 IT기업의 전유물이 아니다. 스마트폰 앱으로도 간단한 딥페이크 영상 제작이 가능하다. 구글 플레이스토어 기준 가장 대표적인 앱에는 페이스플레이(FacePlay), 드림페이스(DreamFace), 리페이스(ReFace) 등 3종류가 있다. 이 가운데 리페이스 앱은 생성적 적대 신경망(GAN)이라고 알려진 머신러닝에 의해 작동한다. 다른 앱의 구체적인 기술이 공개된 적은 없지만 리페이스 앱과 마찬가지로 딥러닝 기술을 활용한 것으로 추정된다.

3가지 앱은 이름이 비슷하고, 사용 방식도 비슷하다. 앱이 제공하는 탬플릿에 내가 원하는 얼굴을 끼워 넣는 것이다. 이용자가 원하는 공간을 창조하고, 이용자가 원하는 몸동작을 구현할 수는 없다. 그래서 상상력은 제한적이다. 딥페이크 영상의 확장성도 떨어진다. 즉, 소극적 딥페이크다. 다만 얼굴 합성에 집중하기에 일부 앱은 현실과 구분하기 힘든 수준의 감쪽같은 딥페이크 영상을 만들어낸다. 3가지 앱이 만들어내는 딥페이크 콘텐츠의 수준과 특징을 짚고 넘어가자.

페이스플레이(FacePlay)

미국의 카말라 해리스 전 부통령이 최근 한국을 찾아 한복 체험을 했다고 한다. 또 북한 김정은 국무위원장은 자연스러운 헤어스타일로 거리에 앉아 쉬는 모습이 카메라에 포착됐다. 물론 둘 다 딥페이크 영상, 사실이 아니다. 캡쳐한 순간뿐만 아니라 전체 영상도 무척 자연스럽다. 누구라고 얘기해주지 않으면 딥페이크라는 걸 알아채기 힘들 것 같다. 이런 영상은 대개 재미로 만드는 경우가 많아서 소셜미디어에 올리기 좋게 9:16으로 제작된다.

1주일에 5달러 정도를 결제하면 이렇게 고품질의 딥페이크 영상을 손쉽게 만들 수 있다. 영상 제작 시간은 1분이 채 걸리지 않는다. 얼굴의 고유한 특징은 그대로 살리면서도 탬플릿에 자연스럽게 녹아들어 영상의 이물감이 잘 느껴지지 않는다. 딥페이크 앱 3가지 중에서 영상의 완성도가 단연 뛰어나다고 느꼈다. 다만 영상에 이용자가 원하는 음성을 입힐 수는 없다. 탬플릿에는 정해진 음악이나 오디오가 이미 깔려 있고 변경하지 못한다. 그래서 이런 딥페이크 영상들은 단순 흥미와 조회수를 넘어 정치적 혼란을 줄 것 같지는 않아 보인다.

드림페이스(DreamFace)

딥페이크 앱 드림페이스 또한 퀄리티 높은 이미지를 만들어낸다. 1주 4.99달러를 결제하면 프로 기능을 사용할 수 있다. 탬플릿의 종류도 3가지의 앱 가운데 가장 많은 것으로 보인다. 내 주변의 지인들 사진, 온라인에서 쉽게 구할 수 있는 유명인의 사진을 넣어 딥페이크 영상을 만들다 보면 시간 가는 줄 모른다. 그림 64, 그림 65는 미국 트럼프 대통령의 젊은 시절, 그리고 LA 유니버셜 스튜디오에 놀러 간 해리스 전 부통령의 딥페이크 이미지다.

드림페이스의 가장 큰 특징은 유명인의 음성 사용이다. 프로 유저는 마이클 잭슨, 테일러 스위프트 등의 음성을 쓸 수 있다. 이용자는 본인이 갖고 있는 스위프트의 사진에 스위프트의 목소리로, 본인이 원하는 말을 하도록 시킬 수 있다. 심지어 도널드 트럼프 대통령의 목소리까지 편리하게 쓸 수 있다. 그게 가능할까 싶은데, 가능했다. AI한테 트럼프의 음성을 교육 시킬 필요도 없이, 아예 트럼프 목소리를 선택할 수 있게 되어 있다.

“난 사실 유죄야. 대통령 되는 걸 포기하겠어”라는 트럼프 음성을 만들고, 그의 사진에 입혀 립싱크 영상을 만드는 것도 된다. 무려 대통령 선거 기간에 이런 립싱크를 만드는 게 자유롭게 가능하다. 민감한 대선 기간에 대선을 포기하겠다는 말까지 시킬 수 있다. 물론 두 손을 벌린 몸은 사진처럼 어색하게 고정되어 있고 입과 얼굴만 움직이는 정도라 유권자를 속이고 사실의 위기를 가져올 정도는 아니다.

그래서 그런 걸까. 트럼프의 가짜 발언 딥페이크를 만드는 행위는 미국에서 법적 규제의 대상보다는 폭넓은 표현의 자유로 인정받는 것 같다. 실제로 해리스를 지지한 현실과 정반대로, 트럼프를 지지한다고 말하는 테일러 스위프트의 립싱크 영상도 만들 수 있을 것이다. 딥페이크 영상을 온라인에 올려 불특정 다수가 보게 하는 것은 또 다른 문제지만, 만드는 것은 대단히 자유롭다는 뜻이다.

오픈AI 소라와 같은 고품질의 딥페이크 플랫폼은 사실의 위기를 가져오고, 사회적 혼란을 예방하는 차원에서 자동 차단하는 콘텐츠가 많은 반면, 드림페이스 앱은 이용자가 유력 정치인의 얼굴로 뭘 만들든 그대로 둔다. 앱이 무한한 상상력을 허용하고 모두 이미지로 만들어주는 것은 아니지만, 최소한 앱에 탑재된 탬플릿에는 그 누구의 얼굴이든 집어넣을 수 있다. 길거리 극빈자의 얼굴이 트럼프와 해리스의 얼굴로 바뀐다. 재미있는 콘텐츠라면 뭐든 다 만들어주겠다는 앱 제작사의 강력한 의지가 느껴진다.

리페이스(ReFace)

끝으로 리페이스 앱을 간략히 언급한다. 이 앱은 구글 플레이스토어에서 다운로드 횟수가 무려 1억 회가 넘는다. 앞서 살펴본 ‘페이스플레이’ 1천만 회, ‘드림페이스’ 1백만 회 정도인 것과 비교하면 단연 압도적인 다운로드 횟수다. 스마트폰으로 간단한 딥페이크 앱을 찾을 경우 이 조회수를 참고해 다운로드 받을 가능성이 높다. 리페이스는 가장 많이 판매된 제품인 만큼 고품질의 딥페이크 콘텐츠를 기대했지만 실제로는 무척 실망스러웠다.

리페이스는 1주마다 6,500원을 내면 워터마크가 없는 딥페이크 얼굴을 만들 수 있다. 하지만 많은 탬플릿이 서양인의 얼굴에 최적화 되어 있는 것 같다. 가수 수지의 얼굴로 만든 2개의 딥페이크 이미지(그림 70, 그림 71)를 보면 눈, 코, 입이 얼굴 위에 둥둥 떠다니는 느낌이다. 길거리 생활하는 트럼프와 해리스 이미지와 비교하면 그 품질의 차이가 극명하다. 1주 6,500원을 결제한 뒤에도 누군가의 헤어스타일을 마음대로 바꿔보려면 추가로 6달러를 더 요구한다. 품질은 낮은데, 비용은 높은 딥페이크 앱으로 보인다.

4. 딥페이크 탐지 기술의 현재

자물쇠는 대개 열쇠와 같이 판매된다. 자물쇠 제작 업체가 열쇠를 같이 만든다. 딥페이크도 똑같다. 딥페이크 플랫폼이 그것의 탐지 기술을 같이 개발하고 있다. 오픈AI, 구글 등이 딥페이크 탐지 기술을 연구하고 있다. 이들 기업은 2024년 미국 대선을 앞두고 딥페이크 콘텐츠 생산에 대해 책임을 져야 한다는 사회적 압박을 받아왔다. 각 플랫폼이 어떤 탐지 기술을 개발하고 있는지 살펴보자.

오픈AI의 탐지 기술

오픈AI는 자체적인 이미지 생성 모델인 ‘달리’가 생성한 콘텐츠를 탐지하는 도구를 출시했다. 이 도구를 이용하면 특정 이미지가 달리 모델로 만들어진 것인지 여부를 검증할 수 있다고 한다. 다만 탐지 플랫폼이 일반에 공개돼 있지 않은 점이 아쉽다. 현재로선 저널리즘과 관련한 비영리 단체를 포함해 일부 테스트 그룹만 오픈AI의 탐지 기술을 사용할 수 있다. 오픈AI는 이런 테스트를 통해 자신들이 개발한 딥페이크 탐지 기술의 효과를 평가하는 것이 목표라고 밝히고 있다.

그럼 딥페이크 탐지 성능은 어느 정도일까. 오픈AI가 공식적으로 밝힌 바에 따르면, 최신 이미지 생성 모델인 ‘달리 3’가 만든 이미지 가운데 98.8%를 정확하게 식별할 수 있다고 한다. 특정 이미지를 AI가 생성했는지 여부에 대해 거의 정확하게 판정한다는 것이다. AI가 생성한 이미지가 아닌데 ‘달리 3’의 이미지로 판정된 경우는 0.5%라고 오픈AI 측은 설명했다. 오픈AI는 정확하게 어떤 원리로 딥페이크 여부를 가려내는지 공개하지 않았으며, 이는 다른 플랫폼 또한 마찬가지다. 사람들은 딥페이크 여부를 투명하게 알기 원할 뿐, 딥페이크 탐지 기술인 자물쇠의 복잡한 원리를 공부하고 싶어하는 건 아니다.

오픈AI의 기술에는 심각한 허점이 하나 있다. 구글 이마젠 3나 미드저니 같은 다른 플랫폼이 생성한 이미지를 알아채지 못한다는 것이다. 즉, 오픈AI는 거대한 딥페이크 생태계에서 생산되는 가짜 콘텐츠 가운데 자사가 만든 극히 일부 이미지만 탐지할 수 있다. 탐지 기술은 딥페이크와 맞서 싸우기에 너무 미약하다. 지금은 A 자물쇠를 열고 싶은데 열쇠가 없으면, 그걸 만든 A 생산업체에 가져가야 하는 상황이다. B 생산업체는 자물쇠 원리를 몰라서 열 수 없다.

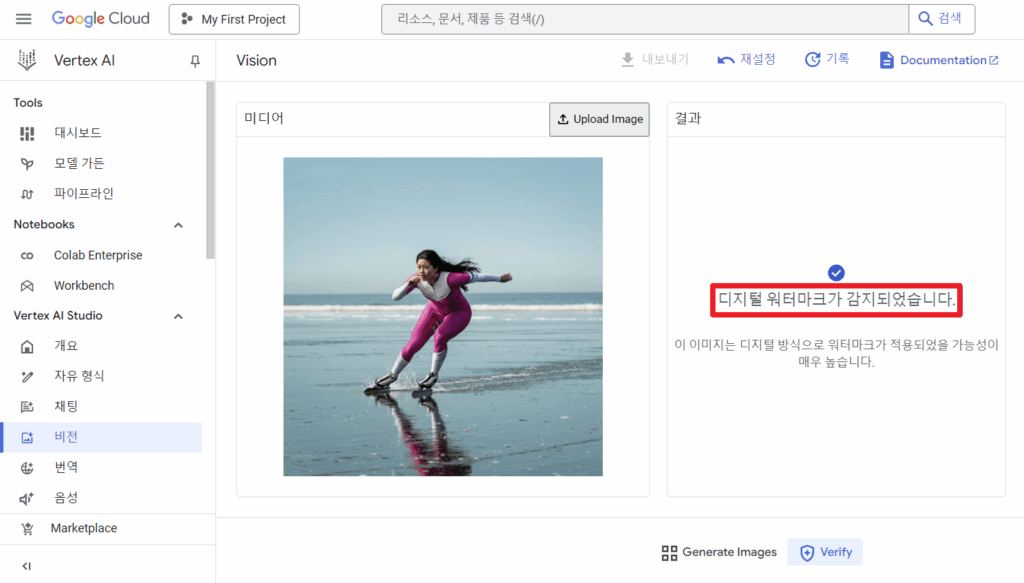

구글 신스ID(SynthID)

구글은 ‘신스ID’라는 이름의 딥페이크 탐지 기술을 갖고 있다. 신스ID는 쉽게 말해, 구글이 딥페이크 콘텐츠에 픽셀 단위로 넣어 놓는 보이지 않는 워터마크 기술이다. (참고로, 메타 또한 자사의 AI 이미지에 Stable Signature라는 이름의 기술로 비가시성 워터마크를 삽입하고 있다.) 구글 이마젠 3가 생성하는 이미지에는 신스ID가 자동으로 들어간다. 그렇다고 사람의 눈에 보이는 것은 아니다. 육안으로 볼 수 없는 워터마크가 픽셀 곳곳에 숨어 있다. 신스ID는 콘텐츠 자체를 손상시키지 않고, 이미지 자르기와 필터 추가, 색상 변경 등의 수정 과정을 워터마크에 모두 기록한다.

신스ID는 딥페이크 이미지에만 적용되는 것이 아니다. 디지털 워터마크는 AI가 생성한 비디오의 각 프레임에도 추가된다고 구글은 설명하고 있다. 구글의 비오 2가 동영상을 생성하면 그 안에 보이지 않는 신스ID가 포함돼 잘못된 정보 확산을 막는데 도움이 된다. 현재 비오 2는 대중에게 완전히 공개되지 않아 동영상의 신스ID를 테스트 할 수는 없는 상황이다.

신스ID는 사진과 동영상을 넘어 음악에도 적용되고 있다. 리리아(Lyria)는 악기와 보컬을 조합해 다양한 스타일의 음악을 생성하는 구글의 AI 모델이다. 음악의 오디오 파동을 X축과 Y축을 가진 스펙트로그램으로 바꿀 수 있는데, 리리아가 만든 음악의 스펙트로그램 안에 슬쩍 디지털 워터마크를 넣는 방식이다. 역시 인간의 청취 경험을 손상시키지 않는다. 인간끼리 경쟁하는 오디션에 리리아 작사 작곡 음악이 몰래 끼어들어도 신스ID로 걸러질 수 있다.

낯설기만 한 신스ID는 대체 어떻게 확인하는 걸까. 구글은 클라우드 안의 Vertex AI 서비스 페이지에서 이마젠 3 모델로 생성하는 이미지에 신스ID를 자동으로 삽입하고, 이용자가 같은 페이지에서 이를 검증도 할 수 있게 해놓았다. 얼지 않은 바다 위에서 스피드 스케이팅을 타는 이마젠 3 이미지를 검증해봤더니 “디지털 워터마크가 감지됐다”는 메시지(그림 73)가 뜬다. 사진 속 신스ID가 감지돼 딥페이크가 확인된 것이다.

하지만 탐지 기술은 아직 완벽하지 않다. 기울어진 롯데월드타워(그림 32), 검은 연기가 피어오르는 서울지하철 2호선(그림 33), 시뻘건 화염이 치솟고 있는 여객기(그림 36) 모두 구글 이마젠 3의 딥페이크 작품이지만, 정작 구글은 딥페이크 사진이 아니라고 판정(그림 74)했다. “디지털 워터마크가 감지되지 않았습니다. 이 이미지는 디지털 방식으로 워터마크가 적용되었을 가능성이 매우 낮습니다.”라는 안내가 떴을 뿐이다. 구글 Vertex AI는 자신의 작품이 새빨간 거짓말이라는 것을 알아채지 못하고 있다. 딥페이크가 고품질인지, 탐지기술이 저품질인지, 확실하지 않다.

구글 신스ID는 또 오픈AI의 딥페이크 탐지 기술처럼 매우 제한적일 뿐이다. 구글 이마젠 3가 만든 이미지도 못 알아보는데 오픈AI 등 경쟁사의 딥페이크를 탐지하지 못하는 것은 당연하다. 신스ID는 오직 구글의 생태계 안에서만 작동한다. 이 보고서에 나온 수십 장의 딥페이크 사진을 구글은 거의 모두 사실로 판정해버린다. 신스ID만 믿고 사진을 보도에 활용하는 것은 끔찍한 일이다. 믿었던 구글에 발등 찍힌다. 신스ID를 그래서 보편적인 딥페이크 탐지 기술이라고 보기는 어렵다.

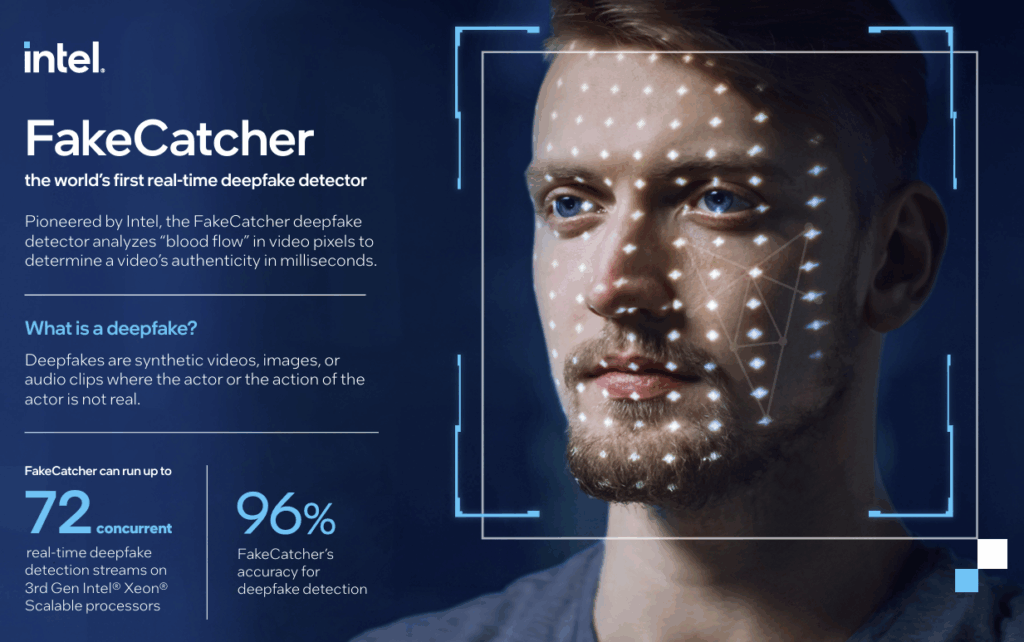

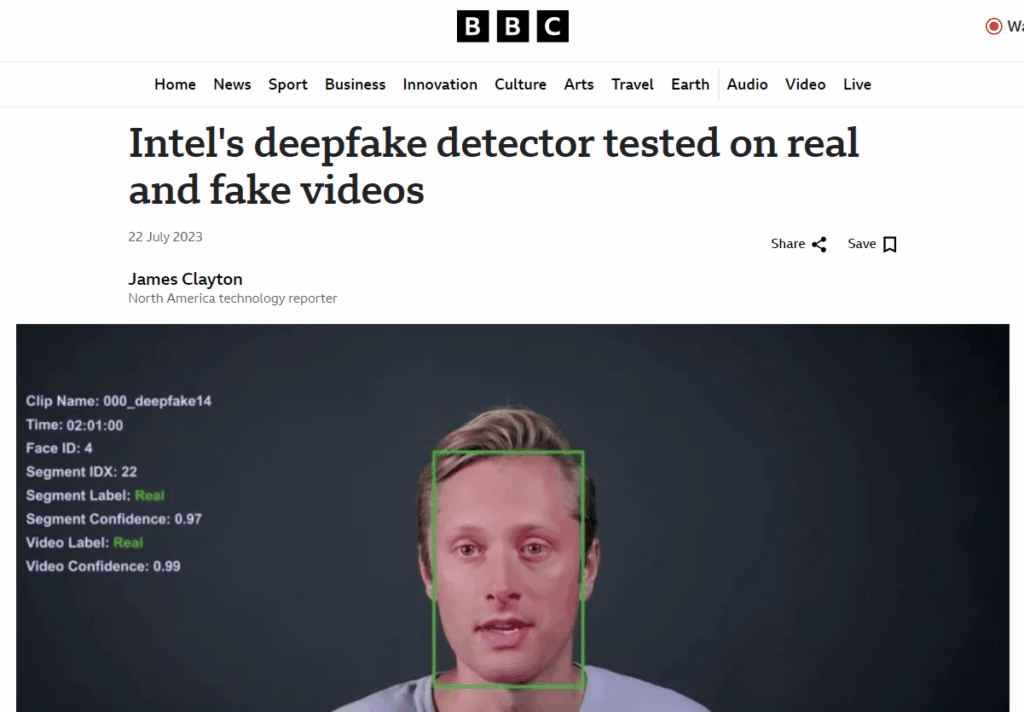

인텔 페이크캐쳐(FakeCatcher)

2022년 11월 14일 , 인텔이 딥페이크 탐지 기술을 출시했다. 페이크캐쳐(FakeCatcher)는 당시 밀리 초 단위로 딥페이크 여부를 실시간 판정할 수 있는 세계 최초의 탐지 기술이었다. 탐지 기술의 정확도는 96%라고 인텔은 밝혔다. 어떤 영상이 딥페이크인지 알기 위해서는 대개 파일을 업로드 하고 분석을 기다려야 하는데 페이크캐쳐는 ‘실시간’ 탐지를 내세웠다. 딥페이크 탐지는 인텔 서버가 하고, 이용자는 웹을 통해 접속할 수 있다. 인텔은 페이크캐쳐가 소셜미디어의 딥페이크 영상 확산을 줄이고, 언론사가 실수로 오보를 내는 것을 방지할 수 있다고 설명했다.

페이크캐쳐는 원리가 흥미롭다. 인텔 소프트웨어가 영상의 픽셀을 분석하는데, 얼굴에 나타나는 미묘한 ‘혈류’를 분석해 실제 인간인지 단서를 찾아낸다는 것이다. 우리 몸은 심장이 뛸 때 정맥의 색이 살짝 바뀌는데 인텔은 이 작은 피부색의 변화를 얼굴에서 전체적으로 감지한다. 딥페이크로 만든 AI 얼굴에서는 이러한 혈류 변화의 신호가 감지되지 않는다. 앞서 딥페이크를 눈치 챌 수 있는 단서 가운데 비현실적으로 매끈매끈한 ‘피부’를 언급한 적이 있는데 이와 비슷하다. 백옥 같은 얼굴, 광이 나는 피부는 딥페이크의 유력한 신호다.

페이크캐쳐는 앞서 본 오픈AI나 구글 신스ID와 명확히 다른 점이 있다. 불특정 다수의 딥페이크 영상을 대상으로 한다는 것이다. 자사 플랫폼이 생성한 영상만 잡아낼 수 있는 기술이 아니다. 소라가 만들었든, 런웨이가 만들었든, 구글 비오 2가 만들었든, 페이크캐쳐는 얼굴 이미지의 혈류를 감지해 딥페이크 여부를 판정할 수 있다. 다만, 인텔이 일반 대중에게 페이크캐쳐 서비스를 제공하지 않는 것은 아쉽다. 페이크캐쳐 홈페이지도 없고, 앱도 없다. 인텔은 이 기술을 딥페이크 탐지가 필요한 기업이나 언론사 같은 조직에 제공하는 것으로 알려졌다.

페이크캐쳐의 성능은 그래서 직접 검증하기가 불가능하다. 대신 2023년 7월, 영국 BBC가 페이크캐쳐를 테스트 한 결과를 소개한다. BBC는 도널드 트럼프와 조 바이든의 영상 12개를 사용해 페이크캐쳐를 테스트 했다. 페이크캐쳐는 12개 가운데 딥페이크 영상을 잘 골라냈다고 BBC는 보도했다. 문제는 딥페이크가 아닌 진짜 영상이었다. 가짜를 알아보는 눈은 괜찮은데, 진짜를 가짜라고 헷갈렸다는 것이다.

페이크캐쳐는 진짜 트럼프, 진짜 바이든의 영상을 여러 차례 ‘가짜’로 판정했다. 영상의 픽셀이 많을수록 페이크캐쳐가 얼굴의 혈류를 포착하기 어려워서 그랬다는 게 BBC의 분석이었다. 화질이 좋지 않아 얼굴에서 혈류가 측정되지 않으면 진짜 영상을 딥페이크로 오판할 수 있는데, 실제로는 영상 픽셀이 많아도 문제였던 것이다. 인텔은 페이크캐쳐 출시 당시 기술의 정확도가 96%라고 밝혔지만, 그 탐지 능력에 대해 독립적인 검증과 분석은 부족하다. BBC가 내린 결론은 “아직 갈 길이 멀다”였다.

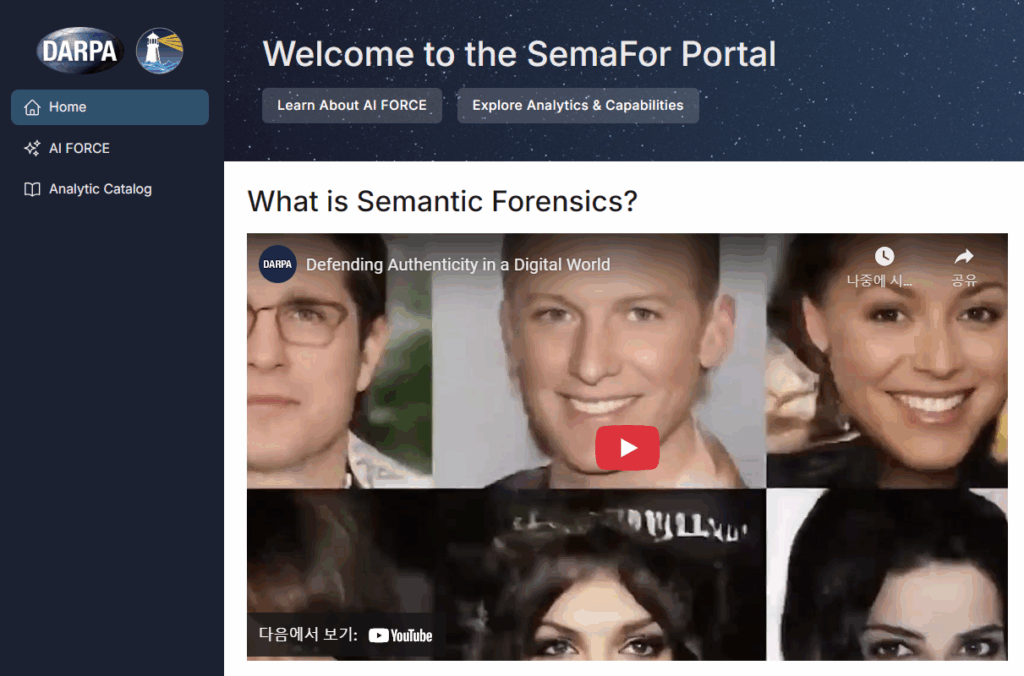

미국 국방고등연구계획국 세마포(SemaFor)

‘세마포’, SemaFor라는 생소한 이름은 ‘Semantic Forensics’의 약자다. ‘의미론적 포렌식’이라고 직역 가능하지만, 도대체 어떤 기술인지 쉽게 와 닿지 않는다. 세마포는 특정 기술을 뜻하는 것이 아니고, 미국 국방고등연구계획국(DARPA)이 다양한 딥페이크 탐지 기술을 개발하는 전체적인 프로그램의 이름이다. 앞서 설명한 IT기업과 달리 미국은 정부 차원에서도 예산을 투입해 딥페이크 탐지 기술을 개발하고 있는 것이다.

세마포가 딥페이크를 탐지하는 기술의 핵심은 ‘AI의 실수’를 눈치 채는 것이다. 예를 들어, AI가 트럼프 대통령의 얼굴을 완벽하게 만들고, 트럼프의 음성까지 완벽하게 조작해도, 그 둘을 조합할 때는 실수할 수 있다. 얼굴과 음성을 잘 생성해도 둘을 합치면 부자연스러울 수 있다. 또 얼굴에 음성을 자연스럽게 합쳤어도, 그 인물의 배경이나, 텍스트가 엉뚱하게 튈 수도 있다.

이렇게 여러 미디어 간의 ‘불일치’, ‘부자연스러움’을 찾아내는 것이 세마포의 기본 개념이다. 딥페이크 제작자는 모든 세부적인 사항을 일일이 신경 써야 하는 부담이 있는 반면, 세마포는 단 하나의 불일치만 찾으면 된다. 다르파(DARPA)에 따르면, 딥페이크 생성 도구는 대개 비주얼이든, 음성이든, 한 가지에 특화되어 있는 경우가 있다. 따라서 딥페이크를 구성하는 여러 요소를 포괄적으로 분석하면 탐지 시스템은 더욱 강력해진다.

세마포는 이렇게 만든 탐지 기술을 다른 사람도 사용할 수 있도록 소스 코드를 온라인에 공개했다. 다음 사이트(https://www.semanticforensics.com/analytic-catalog)에 접속하면 세마포가 개발한 19가지의 탐지 기술을 확인할 수 있다. 다만, 일반인들에게는 난해한 소스 코드가 나와 있을 뿐이라서 딥페이크 탐지 기술을 쉽게 체험해 볼 수는 없다. 다르파(DARPA)는 소스 코드 공개 페이지를 2024년 3월 마지막으로 업데이트했다고 밝히고 있다.

미국의 국방 기관이 왜 이런 기술을 개발하고 있을까. 2024년 미국 대선이 끝난 뒤, 미국 기관들은 애리조나에서 선거 사기가 벌어졌다는 딥페이크 영상이 러시아의 소셜미디어 계정을 통해 확산됐다고 주장했다. 2022년엔 우크라이나 젤렌스키 대통령이 러시아와의 전쟁에서 항복하겠다는 내용의 딥페이크 영상이 확산됐다. 결국 딥페이크 영상이 잘못된 정보를 퍼트려 국가 안보에도 위기를 가져올 수 있다는 인식이 국방 기관의 세마포 추진으로 이어진 것이다. 세마포의 딥페이크 탐지 기술에는 일반인의 접근이 제한되어 있다.

카카오와 딥브레인AI

국내의 딥페이크 탐지 기술을 간단히 짚고 넘어가자. 카카오는 2024년 3월, 자사의 AI 이미지 생성 모델인 ‘칼로’에 워터마크 기술을 도입했다고 밝혔다. 워터마크는 구글의 신스ID처럼 눈에 보이지 않는다고 했다. 카카오는 기술 발표 당시 “워터마크는 비가시성이어서 이미지가 변형되거나 훼손되는 단점이 없다”고 설명했다. 2024년 4월 22대 국회의원 선거를 한 달 앞두고 악의적인 딥페이크를 예방하겠다며 언론에 보도된 내용이다.

그런데 이후 스토리가 황당하다. 워터마크 도입 3달 뒤, 카카오가 ‘칼로’ 서비스를 중단하겠다고 선언한 것이다. 3년이 아니고, 3달이다. 이 정도면 카카오가 워터마크 삽입을 발표할 당시, 이미 내부적으로는 칼로 사업을 정리하는 방안도 검토했을 가능성이 있다. 국회의원 선거를 코앞에 두고 딥페이크에 대한 사회적 우려가 커지자 워터마크 도입을 졸속으로 발표한 것은 아닌지 의심스럽다. 카카오는 칼로 사업을 접고 4달 뒤, 새로운 AI ‘콜라주 by 카나나’를 내놓았다. ‘콜라주 by 카나나’가 생성한 이미지에도 워터마크를 넣는지 여부에 대해 카카오는 밝힌 바 없다. 네이버는 자체적인 AI 생성 모델을 아직 발표하지 않았다.

‘딥브레인AI’는 국내에서 딥페이크 탐지에 가장 선도적인 회사다. AI 아바타를 만들어 필요한 기관에 공급하기도 한다. SBS도 딥브레인AI의 협조를 받아 AI 앵커를 실제 8뉴스에 활용하기도 했다. 또 2023년 12월 배우 조인성, 송혜교 씨의 영상을 본 사람들이 거액의 투자사기를 당해 사회적 이슈가 되었을 때 해당 영상의 딥페이크 여부를 분석해준 곳도 딥브레인AI였다. 경찰청 국가수사본부의 딥페이크 탐지 시스템도 이 회사가 구축했다.

딥브레인AI는 크게 ‘종합 탐지’(영상 및 이미지)와 ‘음성 탐지’를 한다. 영상을 탐지할 때는 프레임 별로 모두 분석해 딥페이크 여부를 판정한다. 인물의 배경을 포함해 영상의 전체를 다 분석하는 것이 아니라 얼굴에 집중한다. 입 모양과 음성이 미세하게 맞지 않는 프레임을 포착해 변조율을 계산하며 ‘립싱크’ 딥페이크로 판정을 내린다. 또 얼굴을 전체적으로 바꿔치기 한 것이 드러나면 ‘페이스 스왑’ 딥페이크로 분류한다.

영상 속 인물 3명까지 판정할 수 있다. 변조율 50% 이상이면 딥페이크, 50% 미만이면 진짜로 판단한다고 하는데, 이 기준은 다소 유동적인 것으로 보인다. 딥브레인AI는 특정 영상의 딥페이크 여부를 알고 싶어 하는 개인의 의뢰도 받고, 영상의 팩트체크가 필요한 방송사에 해당 서비스를 유료로 제공하기도 한다. 앞서 본 미국의 딥페이크 탐지 기술 중 영상에 워터마크를 집어넣는 구글, 얼굴의 미세한 혈류 변화를 감지하는 인텔과는 결이 다르다. 영상 속 요소들의 불일치에 주목하는 미국 다르파(DARPA)의 탐지 기술과 유사한 것으로 보인다.

혼돈의 탐지 기술

지금까지 살펴본 것처럼, 딥페이크 탐지 기술은 한마디로 무척 혼란스럽다. 탐지 기술이 하나만 있는 것이 아니라 여럿이며, 내일은 탐지 기술 하나가 또 추가될 수 있다. 게다가 AI 생성 모델을 운영하는 회사마다 탐지 기술도 제각각이다. 구글은 워터마크를 집어넣는가 하면, 인텔은 얼굴 혈류를 측정하고 있고, 다르파(DARPA)는 영상 속 요소들의 불일치에 주목하고 있다. 그러면서 서로 자사의 탐지 기술이 우수하다고 밝히고 있다. 그 우수함의 근거는 자사가 내부적으로 테스트 한 결과일 뿐이다. 어느 기술이 더 뛰어난지 제3자가 검증하기 어렵다. 오픈AI도, 구글도, 자사의 모델이 생성한 딥페이크를 더 잘 가려내기 때문이다. 연구를 위한 딥페이크 영상 샘플 선정 자체가 연구 결과에 영향을 미친다.

이런 혼란의 배경에는 딥페이크 탐지에 대한 수요가 사실 크지 않다는 점도 있다. 탐지 수요보다 훨씬 더 큰 것은 딥페이크 영상을 만들고자 하는 수요다. 의도가 좋든 나쁘든, AI 영상을 생성하려는 욕망은 폭발적이다. 그 거대한 욕망이 있기에 AI 이미지와 영상을 생성하는 것은 튼튼한 사업 모델이 된다. 오픈AI는 소라를 충분히 이용하려면 챗GPT 플러스 서비스를 구독하게 만든다. AI 영상에 대한 수요를 지렛대로 챗GPT 수요까지 늘리는 전략을 취하고 있다. 런웨이(Runway)와 스마트폰 앱 또한 매달 일정 금액을 지불해야 한다. 구글이 개발 중인 동영상 생성 모델 비오(Veo) 또한 무료 공개를 기대하기는 어렵다.

이렇게 돈을 내면 이용할 수 있는 딥페이크 생성 플랫폼은 다양한 반면, 딥페이크 탐지 플랫폼은 손에 꼽을 정도다. 매달 일정 금액을 내고 이용할 수 있는 딥페이크 탐지 기술은 흔치 않다. 구글 플레이스토어에서 딥페이크 탐지 앱을 찾아보려고 검색하면 모두 딥페이크를 만들어주는 앱만 나온다. 자신이 갖고 있는 다양한 이미지나 영상이 딥페이크인지 확인하고 싶어 하는 사람이 얼마나 되겠는가. 이런 부족한 수요 탓에 딥페이크 탐지 기술은 각 IT기업별로 산발적으로 섬처럼 개발되어 온 측면이 있다. 탐지는 한마디로 돈이 안 된다.

돈이 안 된다고 거대 IT기업이 뒷짐만 지고 있기는 어렵다. 딥페이크의 악영향을 우려하는 사회적 목소리, AI 생성 플랫폼이 허위 정보에 대한 대책도 함께 내놓아야 한다는 지적이 꾸준히 제기되고 있기 때문이다. 물론 지금처럼 혼란스러운 상황 없이 하나의 표준 탐지 기술을 개발한다면 이상적이겠지만, 그러자면 자사의 AI 생성 모델을 경쟁업체에 속살까지 공개해야 할 수 있다. 다양한 종류의 자물쇠를 모두 열 수 있는 만능키를 개발하려면 각 자물쇠의 원리를 전부 알아야하기 때문이다. 이는 현실적으로 어려운 일이다. 그렇다고 딥페이크 생성으로 돈을 벌면서, 탐지 기술을 팽개칠 수는 없다. 이런 배경이 탐지 기술 개발을 혼돈으로 몰아넣었다.

5. 콘텐츠 자격 증명, ‘표준’의 등장

C2PA(Coalition for Content Provenance and Authenticity)라는 조직은 한국에 아직 생소하다. C2PA는 ‘콘텐츠 출처 및 진위성 연합’이라고 직역할 수 있다. 2021년 2월 마이크로소프트와 어도비가 설립했고, 인텔과 BBC 등도 포함되어 있다. C2PA 설립 이전에는 2019년 어도비와 뉴욕타임스 등이 설립한 CAI(콘텐츠 출처 및 진위 확인 이니셔티브, Content Authenticity Initiative)가 디지털 미디어의 출처 기재를 추진했으며, 같은 해 BBC와 뉴욕타임스 등은 ‘프로젝트 오리진’(Project Origin)을 설립해 디지털 뉴스의 허위 정보를 줄이고자 노력했다. C2PA는 이러한 두 그룹의 움직임을 결합하면서 디지털 콘텐츠의 ‘출처’에 관한 글로벌 표준을 만드는데 역점을 두고 있다.

여기서 표준은 딥페이크 탐지 기술의 표준이 아니라, 디지털 콘텐츠의 출처를 기록하는 방법에 관한 표준이다. C2PA가 탐지 기술이 아닌 출처에 집중하는 데는 이유가 있다. 현재 AI의 발달 속도를 고려하면 디지털 콘텐츠가 진짜인지 가짜인지 완벽하게 탐지하는 것은 사실상 불가능하다는 판단이 깔려 있는 것이다. 오랜 노력 끝에 탐지 기술의 표준을 만들고 업데이트해도 그것을 회피하는 딥페이크 제작 기술이 나오면 표준은 무용지물이 되기 때문이다. C2PA가 만든 출처 표준의 이름은 ‘콘텐츠 자격 증명’(Content Credentials)이다.

‘콘텐츠 자격 증명’(Content Credentials)

콘텐츠 자격 증명에는 해당 이미지나 동영상 등을 누가, 언제, 어떻게 만들었고, 어떤 프로그램으로 편집했는지 등을 기록할 수 있다. 콘텐츠를 처음 생성할 때 제작자는 이런 자격증을 첨부할지 여부를 선택할 수 있고, 나중에 콘텐츠를 캡쳐 하거나 편집할 때는 자격증 내용을 수정할 수 있다. 물론 콘텐츠 자격을 기재하는 것에 강제성은 없다. C2PA는 이것이 글로벌 표준으로 채택되도록 추진하고, 여러 소셜미디어가 해당 표준을 적용하도록 노력하고 있다. 그럼 일반인들은 콘텐츠 자격 증명을 어떻게 활용할 수 있을까.

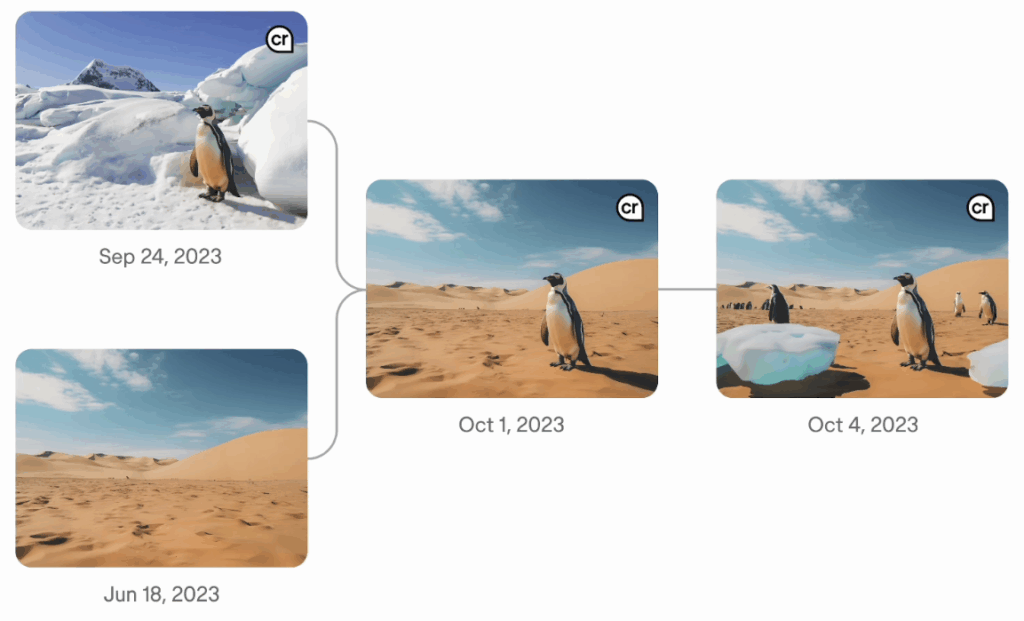

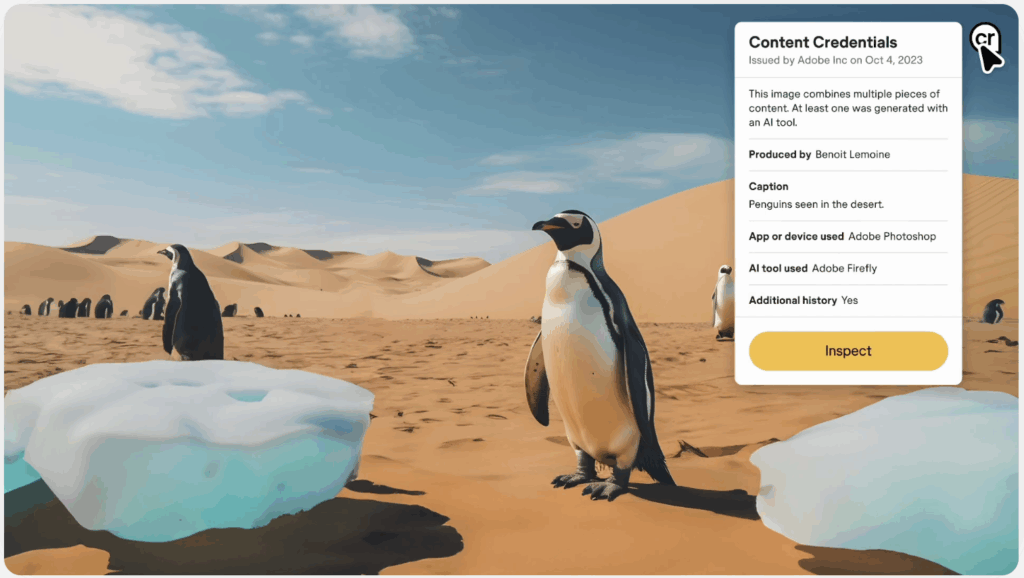

얼음 세상에 펭귄 한 마리가 서 있다. 또 다른 이미지는 온통 모래뿐인 사막이다. 누군가 펭귄의 이미지만 따서 사막에 집어넣었다. 펭귄 한 마리는 허전한지, 다른 누군가 친구 펭귄과 빙하를 더 붙여 넣었다. ‘사막의 펭귄’(그림 81) 이미지가 변조된 과정이다. 여기서 펭귄 이미지 우상단에는 계속 ‘CR’ 아이콘이 들어가 있다. CR 아이콘은 해당 이미지에 콘텐츠 자격 증명이 첨부돼 있다는 것을 알려주는 상징이다. CR은 이른바 투명성의 아이콘이다. C2PA는 이 마크가 이용자들에게 신뢰할 수 있는 디지털 콘텐츠라는 메시지를 주기 바라고 있다.

‘콘텐츠 자격 증명’의 작동 방식은 간단하다. ‘CR’ 아이콘을 마우스로 클릭하기만 하면 된다. ‘사막의 펭귄’ 이미지의 우상단 CR을 클릭했더니, 해당 사진은 여러 이미지를 조합해 만들어졌으며 적어도 한 종류의 AI 생성 도구를 활용했다고 나온다. 어도비 포토샵 앱을 사용했으며 파이어플라이(Adobe Firefly)라는 AI 도구가 사용됐다는 정보도 볼 수 있다. 이런 정보가 투명하게 공개되면 딥페이크라고 의심할 이유가 없다. C2PA는 뉴스 사이트뿐만 아니라 이미지와 영상을 제작하는 회사들이 CR 아이콘을 채택하도록 하는 것을 목표로 삼고 있다.

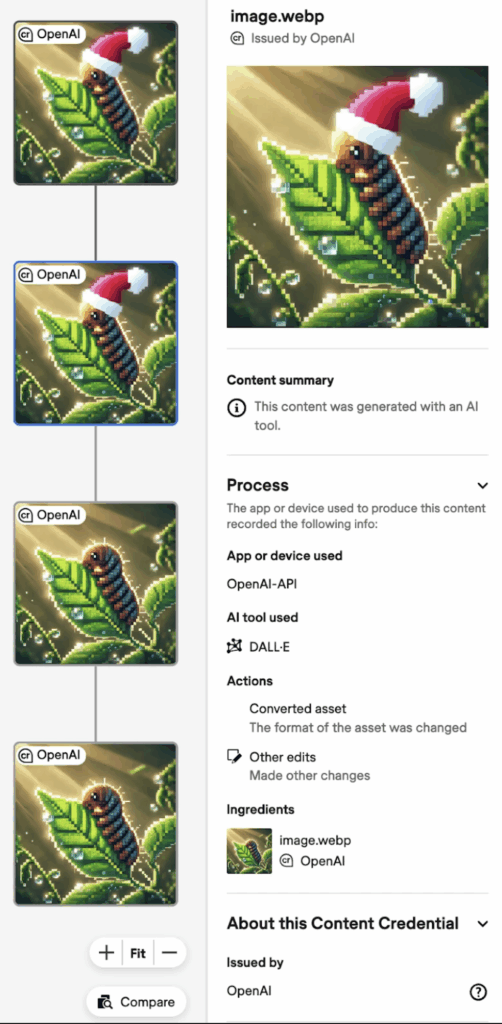

CR 표준을 도입한 오픈AI·틱톡

2024년 5월, AI 동영상 생성 서비스의 선두 주자 오픈AI가 C2PA 운영위원회에 가입했다. 오픈AI는 이에 앞서 2024년 초 이미지 생성 모델인 달리 3가 만든 모든 이미지에 C2PA 표준의 메타데이터를 추가하기 시작했다. 누군가 달리 3로 만들어진 이미지를 편집하더라도 C2PA의 콘텐츠 자격 증명에 이를 투명하게 보여주는 수단을 구축했다고 오픈AI는 설명했다.

나뭇잎에 앉은 애벌레 이미지가 있다. 누군가 챗GPT에서 달리 3모델을 사용해 애벌레한테 산타 모자를 씌우라고 했다. 이렇게 이미지를 편집하면 ‘콘텐츠 자격 증명’이 자동으로 업데이트 된다. 콘텐츠 자격 증명에는 사용된 앱의 종류(DALL-E)와 작업 방식, 기타 수정사항 같은 세부 정보가 모두 기록된다.

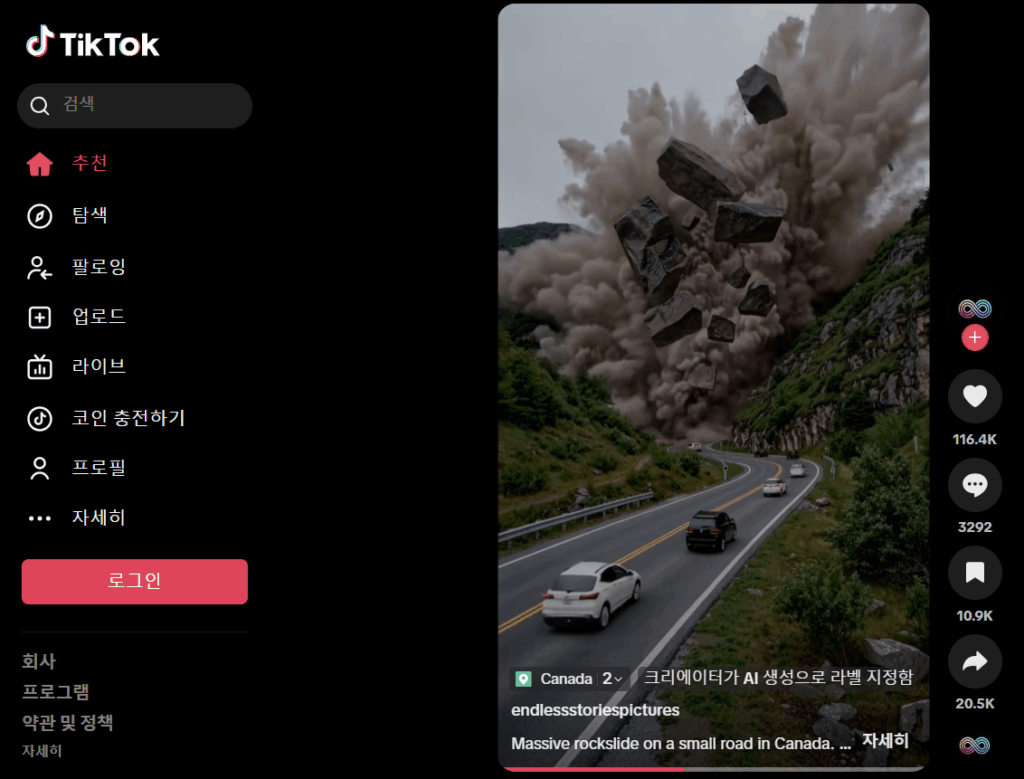

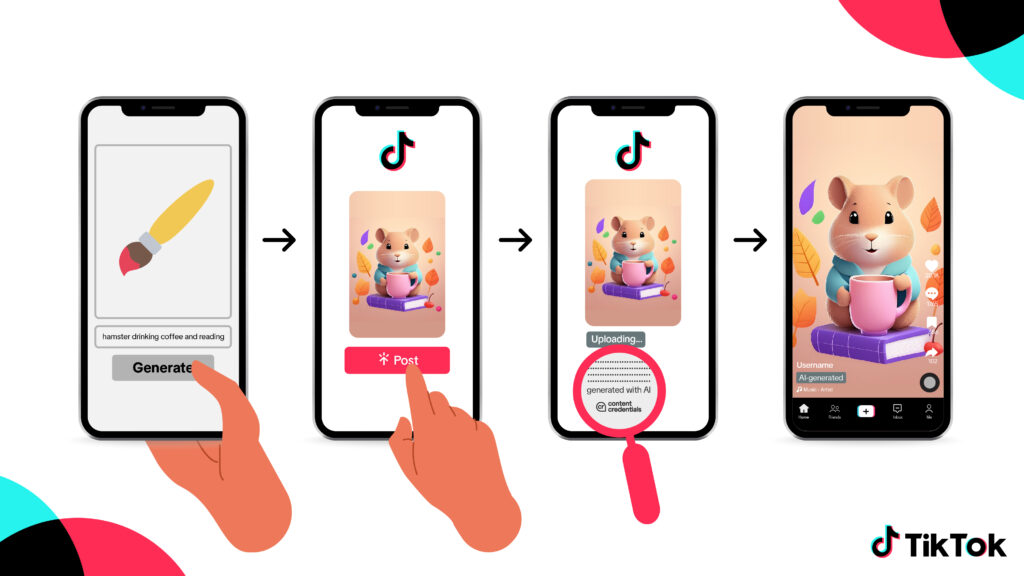

동영상 공유 플랫폼 틱톡(TikTok)은 AI 생성 콘텐츠에 라벨을 붙여왔다. 다음 이미지(그림 84)를 보면 어디서 저런 재앙이 벌어지고 있는지 궁금할 수밖에 없다. 하지만 영상 하단에 보면 “크리에이터가 AI 생성으로 라벨 지정함”이라고 노출되어 있다. 틱톡 이용자는 자신의 영상을 업로드 할 때 AI 생성 라벨을 붙일 수 있다. 틱톡은 이 라벨 기능을 확장해 C2PA의 콘텐츠 자격 증명을 읽는 기능을 출시한다고 2024년 5월 밝혔다.

틱톡에 C2PA ‘콘텐츠 자격 증명’ 표준 기술이 적용된 영상을 올리면 AI 라벨이 자동으로 붙는 방식이다. 틱톡은 C2PA 표준을 적용한 최초의 영상 공유 플랫폼이라고 자사를 홍보하고 있다. 틱톡 영상을 다운로드 받더라도 콘텐츠의 출처 기록은 그대로 유지된다고 한다. 출처가 제대로 기록되어 있다면 누구나 틱톡 영상이 언제, 어디서, 어떻게 만들어졌는지 투명하게 알 수 있다. 틱톡은 이와 별도로 키워드 검색과 사용자 신고 등을 바탕으로 딥페이크 영상을 탐지하기도 한다. 틱톡은 자사의 탐지 기술에 관한 세부사항을 밝힌 바 없다.

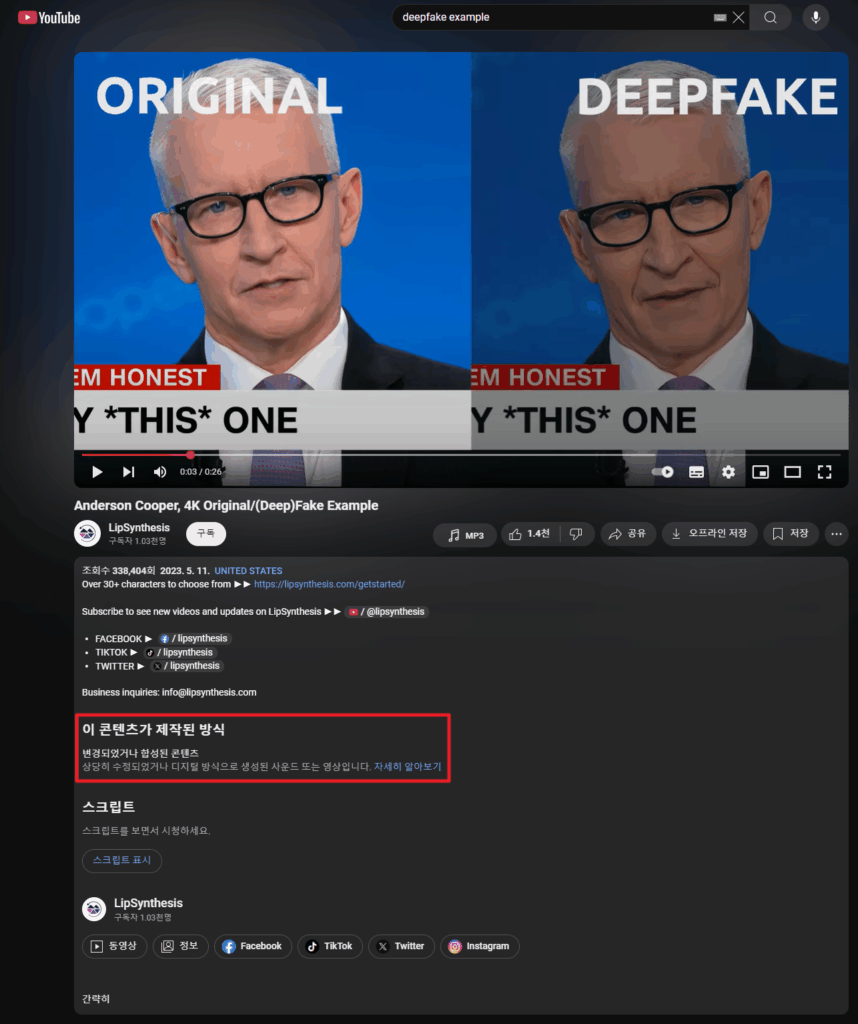

AI 라벨을 의무화 한 유튜브

오픈AI와 틱톡처럼 유튜브 또한 2024년 상반기에 AI 영상의 출처 표기에 관해 큰 변화를 시행했다. C2PA 표준을 적용한 것은 아니지만, AI 생성 콘텐츠에 라벨 적용을 시작한 것이다. 시청자가 현실로 혼동할 수 있는 딥페이크 영상을 유튜브에 올리는 경우 이 사실을 투명하게 알려야 한다는 취지다. 앞서 본 틱톡의 AI 라벨과 비슷해 보인다. 이에 따라 지금은 유튜브 PC 버전과 스마트폰의 유튜브 앱에서 다음과 같은 AI 라벨을 볼 수 있다.

라벨 내용은 간단하다. “변경되었거나 합성된 콘텐츠”라는 텍스트가 노출되는 것이다. 방식은 두 가지다. 하나는 동영상의 설명란에 “이 콘텐츠가 제작된 방식”이라는 소제목으로 AI 라벨이 노출된다. 두 번째는 동영상이 재생되고 있는 플레이어에 같은 내용의 라벨이 뜨는 방식이다. 이는 선거와 진행 중인 분쟁, 자연재해 등 허위정보가 공공의 안전에 악영향을 미칠 수 있는 소재에 적용된다. 더 눈에 띄는 AI 라벨 딱지가 붙는다. 크리에이터는 어떤 동영상에 라벨을 붙여야 할까. 유튜브가 공식적으로 밝힌 예시를 살펴보자.

– 음성 해설 또는 더빙을 위해 다른 사람의 음성 복제

– 실제 장소에 대한 추가 영상을 합성으로 생성(예: 여행 홍보 동영상을 위해 마우이의 서퍼를 묘사한 동영상)

– 실제 프로 테니스 선수 두 명 간의 경기 동영상을 사실적으로 보이게 합성으로 생성

– 다른 사람이 실제로 하지 않은 조언을 한 것처럼 보이게 만듦

– 유명 가수가 라이브 공연에서 음을 놓친 것처럼 들리도록 오디오를 디지털 방식으로 변경

– 실제로 발생하지 않은 토네이도 또는 기타 기상 현상이 실제 도시에 다가오는 모습을 사실적으로 묘사

– 병원 인력이 아프거나 부상당한 환자를 외면하는 것처럼 보이게 만듦

– 공인이 훔치지 않은 것을 훔치는 것으로 묘사하거나, 훔쳤다고 인정하지 않았는데 인정하는 것으로 묘사

– 실제 인물이 체포되거나 투옥된 것처럼 보이게 만듦

– 특정 인물의 얼굴을 다른 사람의 얼굴로 변경하기 위해 콘텐츠를 디지털 방식으로 생성 또는 변경

– 원작 영화에 나오지 않았던 유명인을 등장시키기 위해 유명 자동차 추격 장면을 디지털 방식으로 변경

– 의료 전문가가 실제로 하지 않은 조언을 한 것처럼 들리게 오디오 시뮬레이션

– 실제 도시를 향해 미사일이 발사되는 모습을 사실적으로 묘사

유튜브는 위와 같은 영상의 경우 변경되거나 합성된 콘텐츠라는 사실을 “공개해야 한다”고 밝히고 있다. 권고가 아닌 의무 사항이다. 만약 공개하지 않으면 채널 운영자가 삭제할 수 없는 라벨을 유튜브가 직접 붙일 수 있다. 공개를 거부하거나 지속적으로 회피하면 크리에이터는 콘텐츠를 삭제 당할 수 있다고 유튜브는 밝히고 있다. AI 라벨을 의무화하고 룰을 지키지 않은 경우 페널티까지 주겠다는 것이다. 유튜브는 AI 라벨 정책에서 다른 플랫폼보다 이용자에게 강제성을 부여하고 있다.

“사실 딥페이크야”… 고백할까?

C2PA의 출처 표준인 ‘콘텐츠 자격 증명’, 또 이를 도입한 오픈AI와 틱톡. 자체적으로 AI 영상 라벨을 적용하는 유튜브까지 공통점이 하나 있다. 딥페이크 영상을 적극적으로 탐지하기보다는 소극적으로 이용자의 신고를 유도하는 방식이라는 점이다. 제작자가 ‘콘텐츠 자격 증명’(CR) 표준을 적용해야만 다른 사람이 딥페이크를 알아챌 수 있으며, 유튜브에 영상을 올리는 사람이 라벨을 붙여야만 시청자가 AI 작품이라는 사실을 알 수 있다. 틱톡은 C2PA 표준이 적용된 영상의 경우 라벨이 자동 노출되지만, 애초에 C2PA 표준 적용이 제작자에게 맡겨져 있다는 점에서 다르지 않다.

그런데 딥페이크 영상 제작자 가운데 자발적으로 CR 표준을 적용하고, AI 라벨을 붙이는 경우가 얼마나 될까. 그건 “내 영상은 사실 딥페이크야!”라고 진실을 고백하는 행동이다. 특히 사실을 오도하려는 목적으로, 사람들을 헷갈리게 하려는 목적으로 딥페이크 영상을 만든 뒤에 진실 고백, 자진신고를 하는 사람은 얼마나 될까. 무척 회의적이다. 배우 조인성 씨가 주식투자를 권유하는 딥페이크처럼 AI 라벨을 꼭, 반드시 붙여야 하는 영상이 역설적으로 어떻게든 AI 라벨을 회피해 사람들을 속이려 할 것이다.

AI 플랫폼에서 내가 만든 영상을 다운로드 받으면 대개 워터마크가 자동 삽입된다. 그 워터마크를 지우고 싶은 것이 본능이다. 다른 사람들에게 내가 직접 만든 영상처럼 보이고 싶은 게 사람 심리다. 그래서 워터마크를 빼려면 월 구독료를 더 내야 하는 것이다. 돈을 더 내고 워터마크를 뺀 사람이 자기 콘텐츠에 CR 표준을 기재하고 AI 라벨 딱지를 붙여 딥페이크라고 광고하지는 않을 것이다. C2PA가 어렵게 개발한 기술 표준이 정착되려면 이렇게 사람 심리를 거슬러야만 하는 어려운 과제가 놓여 있다.

6. 딥페이크 탐지 플랫폼 테스트

앞서 언급한 것처럼 일반인들이 쉽게 접근할 수 있는 딥페이크 탐지 플랫폼은 많지 않다. 특히 딥페이크를 찾아준다고 하는 업체들의 실제 실력을 확인하는 것이 힘들다. 대체 어떤 기술을 갖고 있는지 정확하게 공개하는 곳이 거의 없기 때문이다. 딥페이크를 어떻게 확인한다고 기술 노하우를 공개하는 순간 그 기술은 효과가 사라질 수 있다. 때문에 어떤 탐지 기술을 사용하는지는 철저한 영업 비밀이다. 이번엔 일반인들이 접근 가능한 딥페이크 탐지 사이트와 그 검증 결과를 소개하고자 한다.

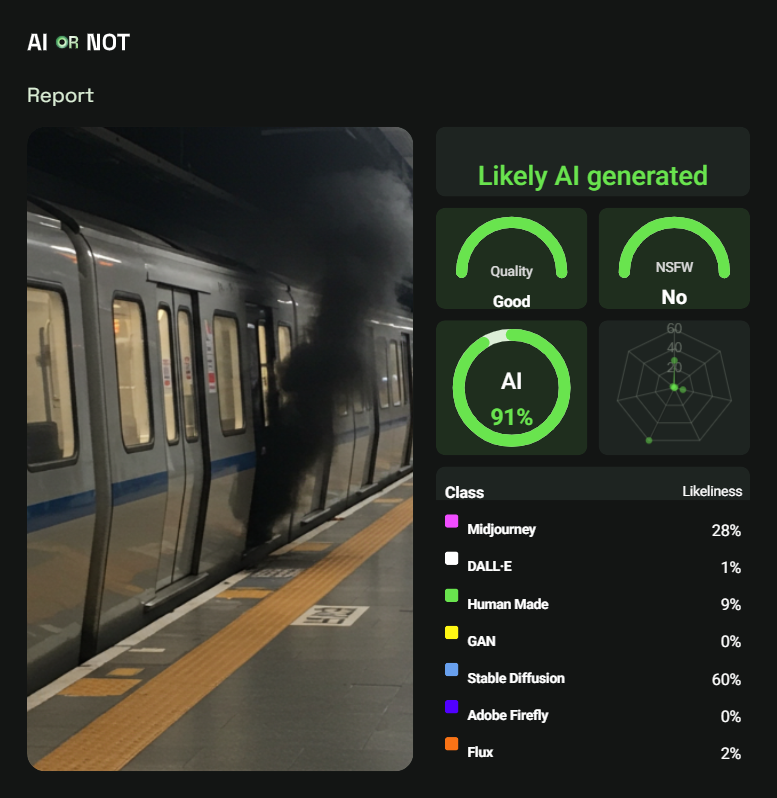

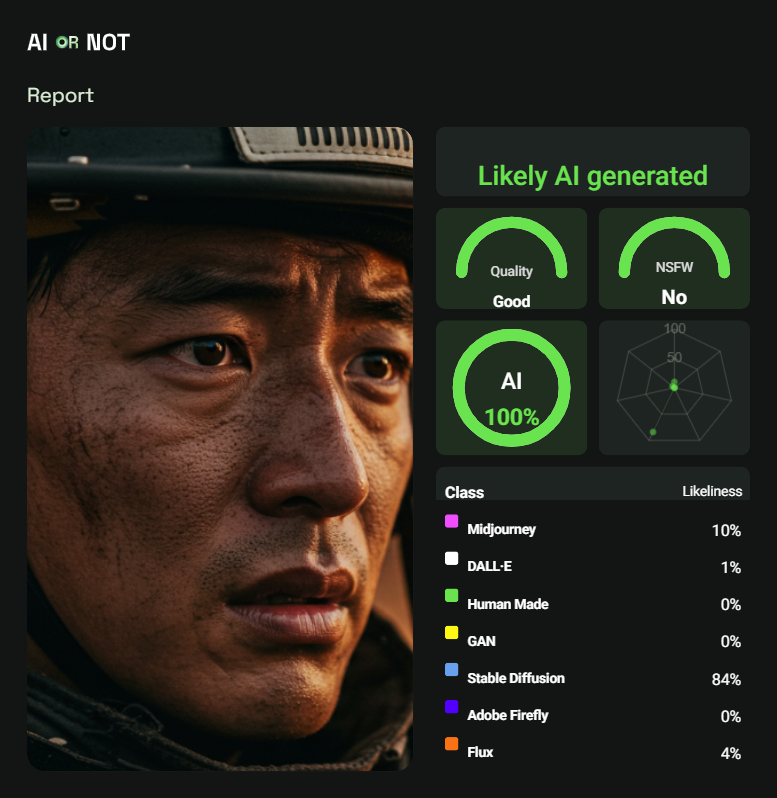

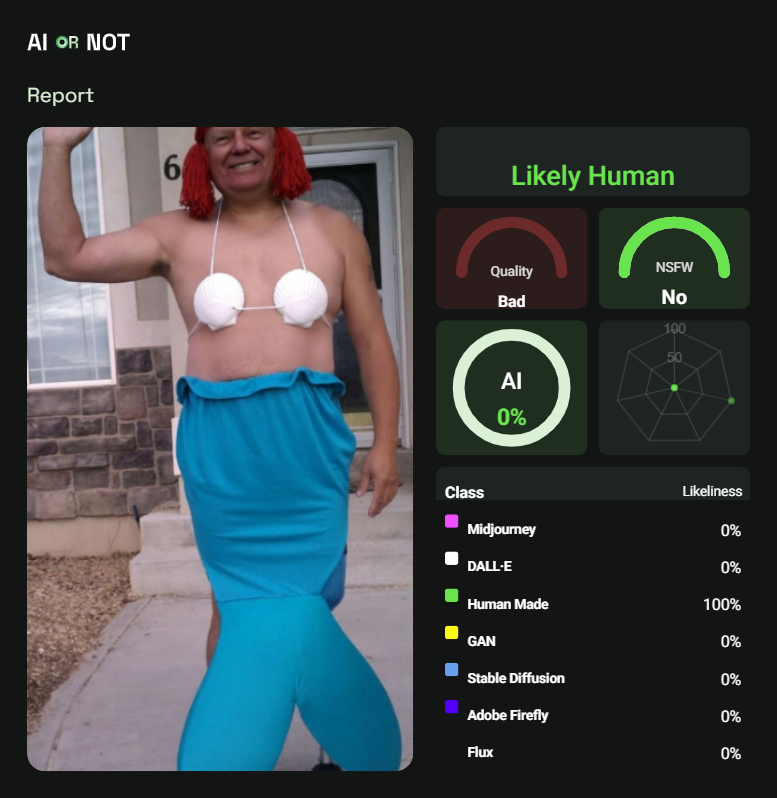

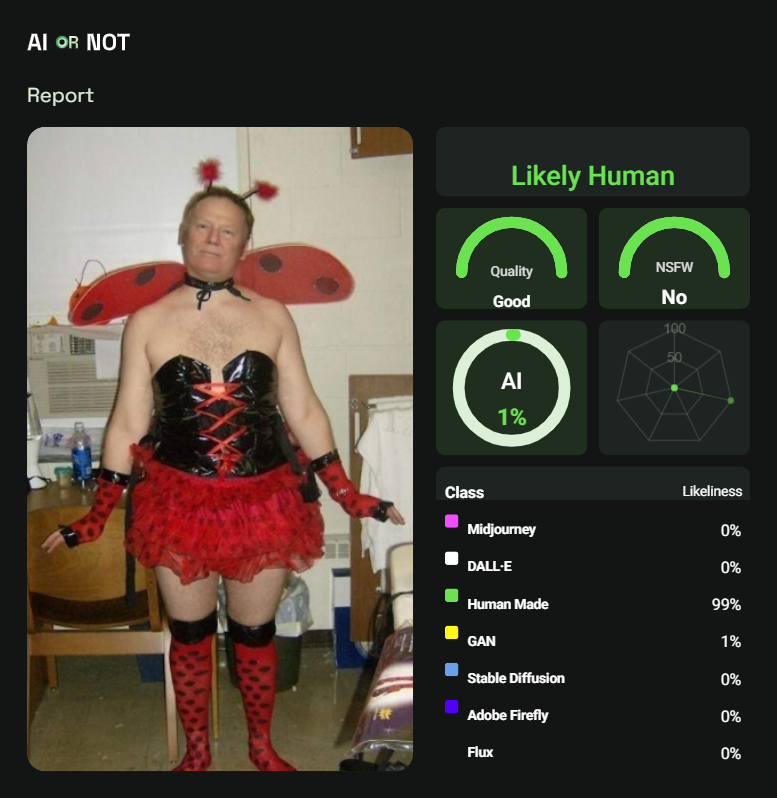

AI OR NOT

내가 가진 사진이 딥페이크인지 여부가 궁금할 때 비교적 쉽게 이용할 수 있는 플랫폼이다. 무료 버전은 사진 10장을 검증할 수 있다. 다만 AI 이미지인지, 실제 사진인지 최종 결과만 알려주고 세부 데이터는 공개하지 않는다. 좀 더 구체적인 분석 내용을 보려면 월 5달러를 내고 베이직 요금제를 이용하면 된다. 베이직 플랜에서는 한 달에 이미지 100개까지 분석할 수 있다.

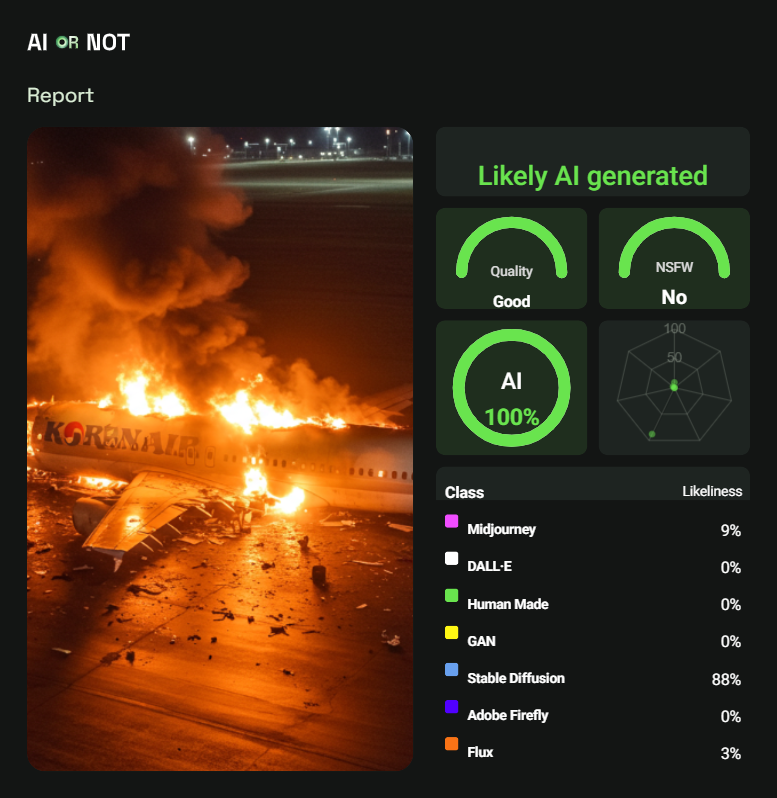

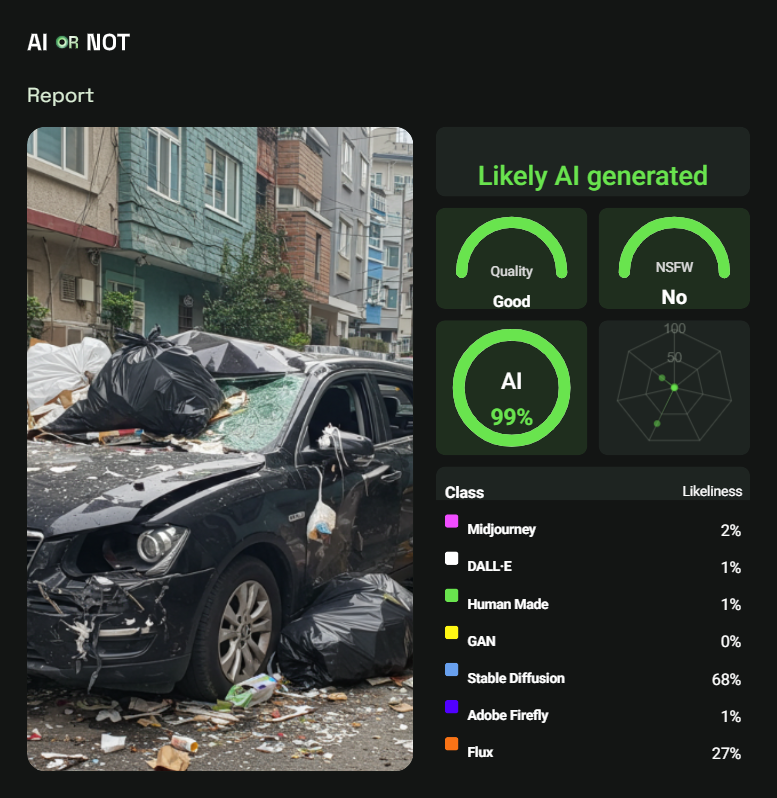

오픈AI 달리, 구글 이마젠 등으로 만든 AI 이미지와 실제 사진 총 70장을 테스트 했다. AI OR NOT은 64장을 정확하게 판단했다. 구글 이마젠 모델이 현실감 있게 생성한 가짜 사건사고 이미지를 모두 AI 작품이라고 잘 가려낸 점이 인상적이었다. 취재기자 입장에선 AI 사진에 깜짝 놀라 경찰과 소방에 전화하기 전, AI OR NOT 플랫폼에서 일차적으로 확인해보는 것도 좋은 방법이다.

여객기 화재가 AI 이미지일 확률은 무려 100%, 북한의 오물풍선에 박살난 차량 사진은 99%, 지하철에서 검은 연기가 피어오르는 이미지는 91%, 화재를 진압하다 잠시 얼굴을 드러낸 소방관은 100% AI 이미지라고 AI OR NOT은 판정했다. 이미지 70장 가운데 정답을 틀린 것은 6장인데, 모두 AI가 만든 딥페이크 이미지를 실제 촬영된 사진이라고 오판한 것이었다.

리페이스(ReFace) 앱에 트럼프 대통령의 얼굴을 넣어 만든 딥페이크 사진 3장을 AI OR NOT은 모두 실제 사진으로 잘못 판정했다. 심지어 다음 이미지(그림 93, 94)가 진짜 사람일 가능성을 100%, 99%라고 단정 지었다. AI OR NOT은 대개 정답을 잘 골라냈지만, 하필 대통령 얼굴의 딥페이크 이미지를 100% 진짜라고 판정했다. 실제 모습으로 판정된 AI 이미지는 여느 딥페이크와 다르게 다소 조악한데, 이런 느낌이 AI OR NOT을 헷갈리게 만든 것으로 보인다. 딥페이크 탐지 사이트도 확신을 경계해야 한다.

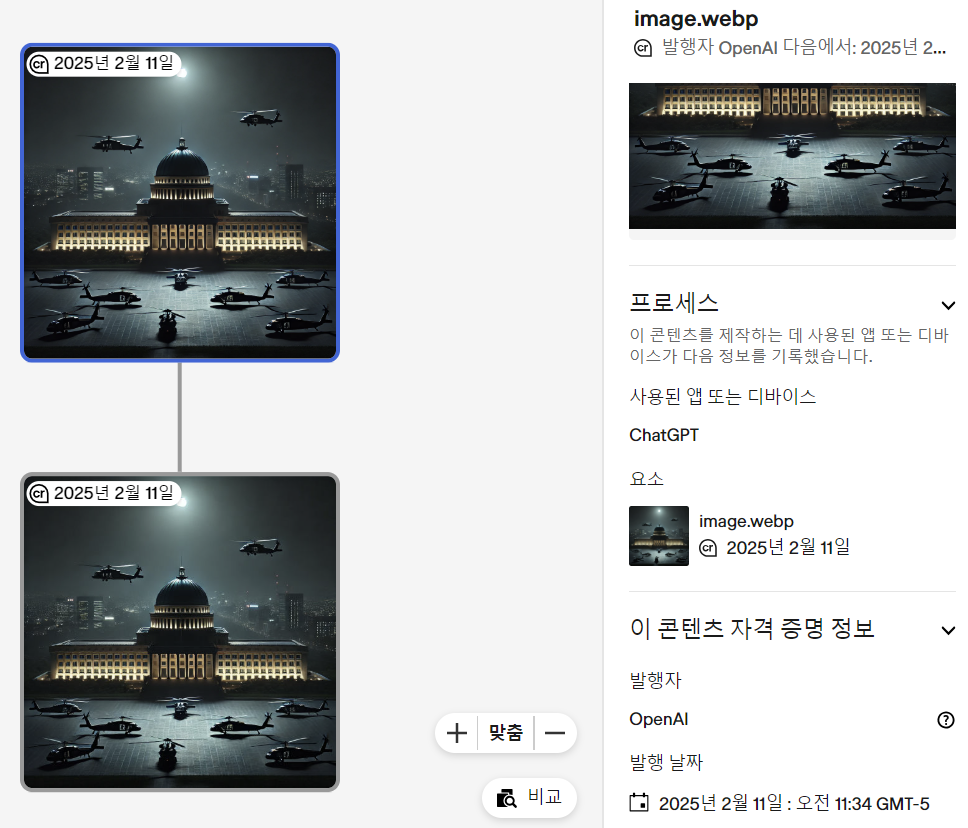

콘텐츠 자격 증명(CR) 확인 사이트

앞서 C2PA(콘텐츠 출처 및 진위성 연합)가 만든 디지털 콘텐츠 출처의 ‘표준’ 기술을 소개한 바 있다. 또 이 기술을 오픈AI 이미지 생성 모델 ‘달리’가 적용하고 있다는 점도 설명했다. 지금도 달리 모델로 생성한 AI 이미지에는 ‘콘텐츠 자격 증명’(CR) 데이터가 자동으로 삽입된다. 이미지 구석에 ‘CR’ 아이콘이 들어가지는 않는다. 그럼 CR 아이콘을 클릭할 수가 없는데 이용자는 어떻게 출처 데이터를 확인할 수 있을까. 현재로서는 ‘콘텐츠 자격 증명’ 공식 홈페이지에서만 검증할 수 있다. https://contentcredentials.org/verify 여기서 확인 가능하다.

이 사이트에 이미지를 업로드하면 콘텐츠 출처를 쉽게 확인할 수 있다. 이미지 생성 날짜와 시간, 발행된 AI 플랫폼, 수정사항 등이 나온다. 물론 달리를 제외한 다른 AI로 생성한 이미지는 이 사이트에서 출처를 확인할 수 없다. 콘텐츠 자격 증명 표준 CR을 적용하지 않기 때문이다. 이런 경우 “콘텐츠 자격 증명 없음”이라고 뜬다. 결국 이 사이트는 무궁무진한 AI 이미지 가운데 달리가 생성한 극히 일부만 확인할 수 있다는 한계가 있다.

일루미나티(ILLUMINARTY)

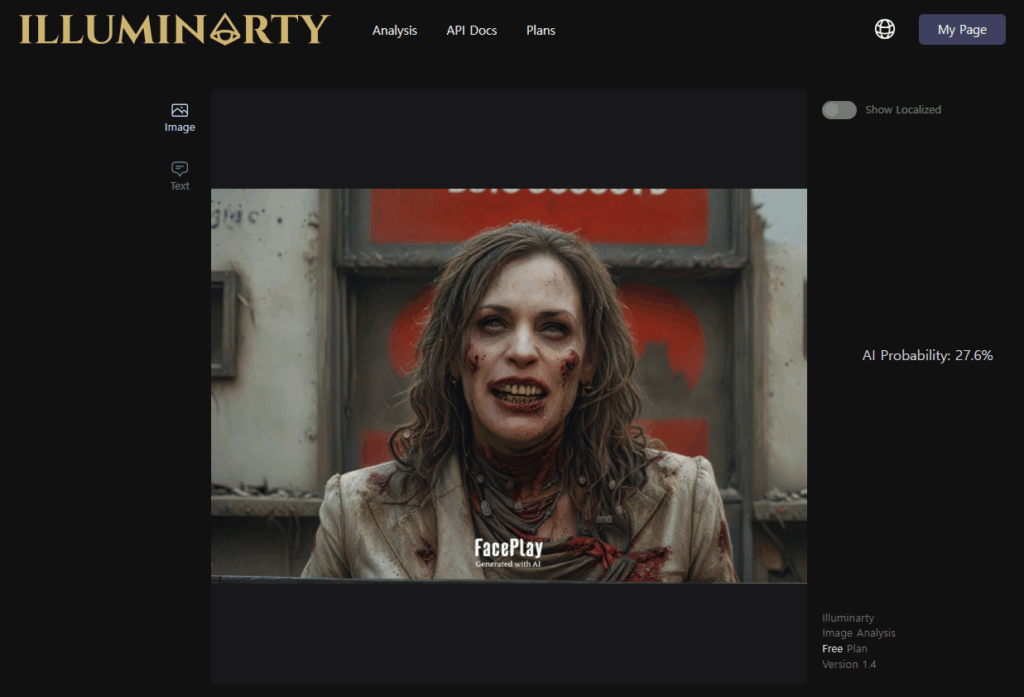

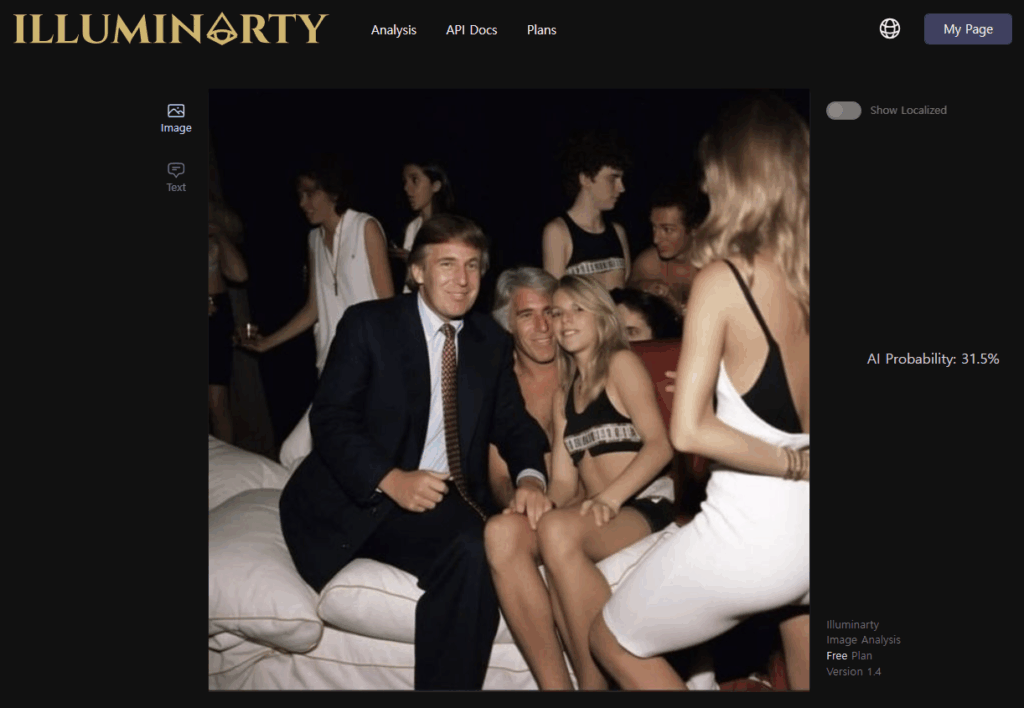

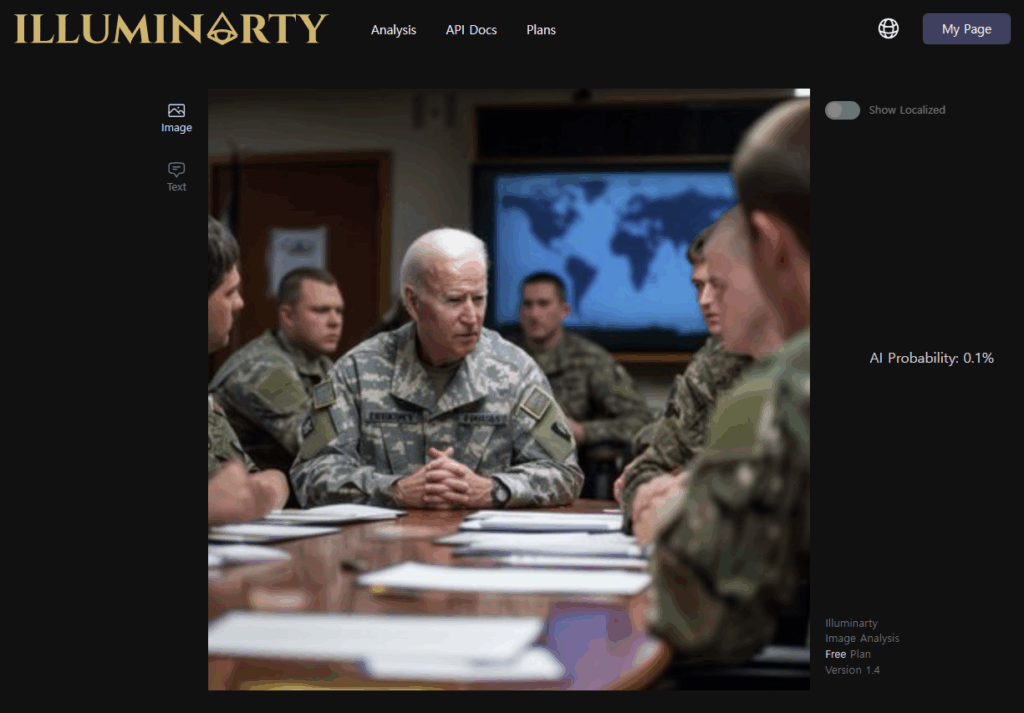

일루미나티 또한 AI 생성 이미지를 가려주는 사이트이다. 돈을 내지 않는 무료 버전에서도 이미지를 업로드 하면 딥페이크인지 여부에 대해 최종 결과만 알려준다. 좀 더 자세한 데이터를 얻고 싶으면 월 10달러 베이직 요금제 이상을 가입해야 한다. 프로 요금제는 월 30달러다. 하지만 굳이 비용을 낼 필요가 없을 것 같다. 무료 버전에서 실시한 테스트부터 일루미나티가 실망스러운 결과를 보여줬기 때문이다. 다음 이미지(그림 97)는 미국 해리스 전 부통령의 얼굴을 페이스플레이(FacePlay) 앱으로 변조해 만든 딥페이크다. 그런데 일루미나티는 AI 생성 가능성을 27.6%라고 알려줬다.

일루미나티의 딥페이크 탐지 실력에 벌써부터 실망하면 안 된다. 도널드 트럼프 대통령이 아동 성범죄자와 찍었다는 가짜 사진(그림 98). AI가 생성했을 가능성이 31.5%라고 한다. 심지어 바이든 전 대통령이 군 수뇌부와 회의하는 모습을 그린 딥페이크 이미지(그림 99)는 AI 생성 가능성이 0.1%라고 일루미나티는 분석했다. 이 분석 결과를 보고 새빨간 거짓말을 진짜로 믿어버리면 낭패다. 일루미나티, 정말 큰일 날 사이트다.

이는 일루미나티가 엉뚱한 결과를 내놓은 것만 악의적으로 뽑아낸 결과가 아니다. 일루미나티가 분석한 이미지는 총 45개. 달리, 이마젠 3, 런웨이, 페이스플레이 등의 앱으로 만든 딥페이크 이미지들이다. 이 가운데 일루미나티가 AI 생성 가능성을 50% 이하로 분석한 사진은 34장에 달한다. 딥페이크를 제대로 가려낼 확률은 25%였다. 앞서 AI OR NOT 사이트는 딥페이크를 91.5%의 확률로 찾아냈다.

트루미디어(TrueMedia)

미국 시애틀에 있는 비영리단체 트루미디어는 AI 기술을 악용한 딥페이크 콘텐츠를 탐지해 온 저명한 조직이다. 특히 정치와 선거 관련 허위정보의 확산을 막는데 주력해왔다. 트루미디어는 미국 대선을 앞둔 2024년 4월 딥페이크 탐지 서비스를 웹사이트에 공개했다. 비영리단체인 만큼 트루미디어 측으로부터 승인만 받으면 무료로 이용할 수 있는 서비스였다. 100% 확실한 판정을 내리진 못하지만, 여러 언론사의 팩트체커 또한 트루미디어의 딥페이크 탐지 사이트에 주목했을 것이다. 수많은 딥페이크 이미지를 비용 부담 없이 수시로 탐지할 수 있는 플랫폼이 트루미디어 말고 없었기 때문이다.

2024년 중순 미국 UNC 방문학자로서 연구를 시작하면서 트루미디어의 딥페이크 탐지 시스템을 이용하기 위해 승인을 요청했다. 같은 해 7월 26일 트루미디어로부터 “승인되었다”는 반가운 피드백을 받았다. 그런데 2025년 1월 돌연 갑작스러운 이메일을 받았다. 1월 14일 트루미디어 운영을 중단한다는 내용이었다. 중단 배경에 대한 자세한 설명은 없었다. 트루미디어는 당초 오픈AI 달리, 구글 이마젠, 미드저니, 어도비 파이어플라이 등 여러 AI 모델이 생성한 이미지를 감지할 수 있다고 밝힌 만큼 운영 중단은 무척 아쉬운 일이다. 트루미디어는 문을 닫으며 딥페이크 감지 기술을 오픈소스로 모두 공개했다.

그밖에 AI 이미지 생성과 탐지를 서비스하는 업체 하이브(https://thehive.ai), 리얼리티 디펜더(Reality Defender, https://www.realitydefender.com), 그리고 미국 노스웨스턴대학에서 만든 무료 딥페이크 탐지 플랫폼(https://godds.ads.northwestern.edu) 등이 있다. 하지만 딥페이크 탐지를 의뢰하는 건수에 따라 일일이 비용 견적을 받아야 하거나, 언론인을 제외한 일반인들이 서비스에 접근할 수 없도록 차단해놓고, 한 건의 결과를 받으려면 다음날까지 기다려야 하는 등의 이유로 탐지 기술을 직접 테스트하기 어렵다.

지금까지 딥페이크 탐지 서비스를 제공하는 플랫폼을 살펴보고 그 성능을 검증해봤다. AI OR NOT, 콘텐츠 자격 증명(CR) 확인 사이트, 그리고 일루미나티 정도가 전부다. 모두 AI가 생성한 ‘이미지’만 확인해준다. 다른 플랫폼에선 물론 동영상 탐지가 가능하지만 비용과 접근성이 좋지 않다. 딥페이크가 의심되는 영상에 피해를 봤다면 그는 해당 영상을 갖고 탐지 업체에 비용을 문의해야 한다. 이 비용보다 훨씬 더 저렴한 것이 딥페이크 제작비용이다. 돈을 조금 내면 워터마크를 뺀 AI 이미지와 동영상을 만들어준다는 앱이 온라인에 널려 있다. 딥페이크 제작 진영은 강력한 반면, 탐지 진영은 무척 열악하다.

7. 언론의 탐지 기술 적용

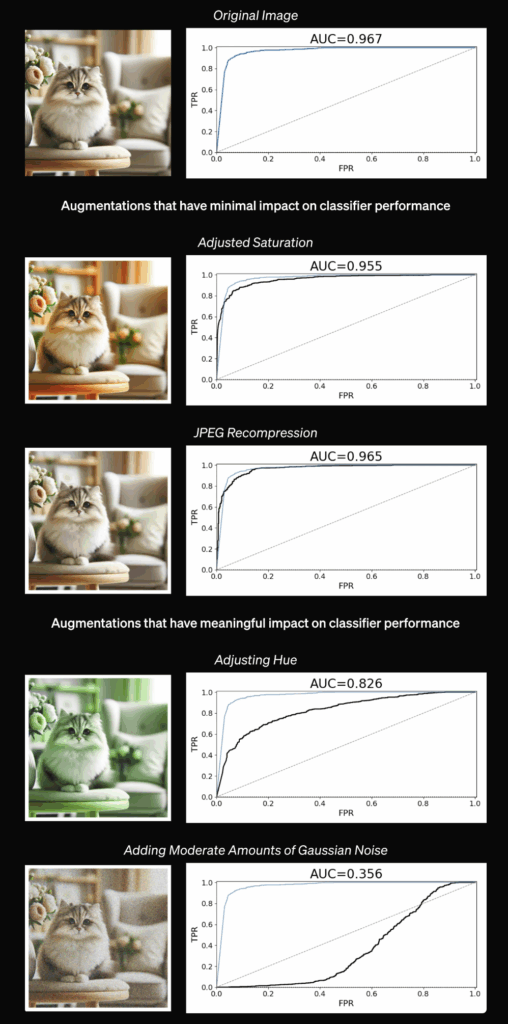

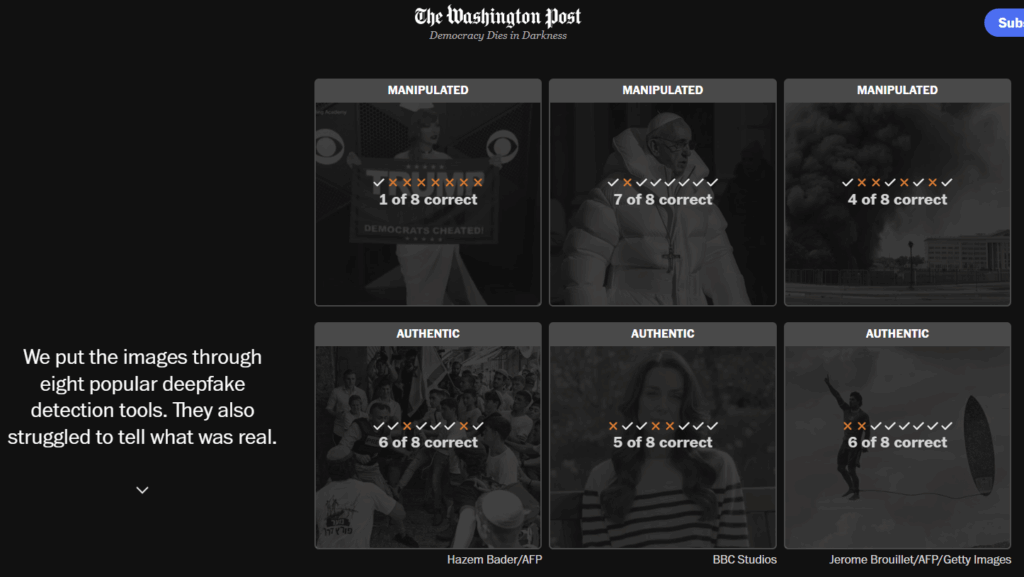

언론은 딥페이크 탐지 기술을 어떻게 평가하고 있을까. 딥페이크 탐지에 조직의 큰 역량을 쏟는 언론사 가운데 하나가 영국 BBC다. BBC는 디지털 콘텐츠 출처의 표준을 추진하는 C2PA에 언론사로서 유일하게 운영위원회 멤버로 참여하고 있다. BBC는 2024년 4월, 자사 뉴스의 정확한 영상 보도를 위해 여러 개의 딥페이크 탐지 플랫폼을 자체적으로 평가한 뒤 백서를 공개한 바 있다.

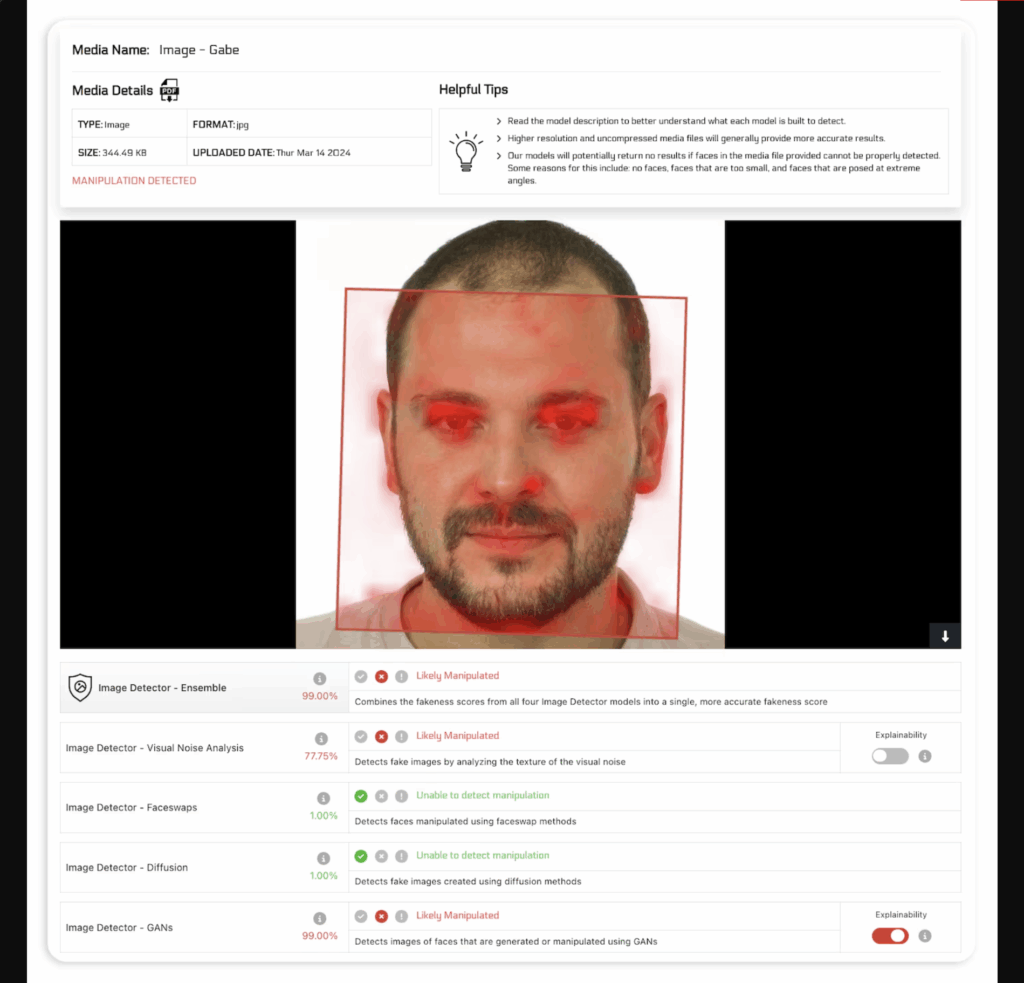

BBC 연구진은 “생성 및 조작된 이미지에 대한 탐지 평가”(An Evaluation of Generated / Manipulated Image Detection)라는 제목의 백서에서 최신 AI 이미지 생성 모델을 이용해 딥페이크 이미지를 만든 뒤 각 탐지 플랫폼의 성능을 테스트했다. BBC의 결론은 지금까지 이 보고서에서 살펴본 바와 같다. 그 어느 탐지 플랫폼도 모든 유형의 딥페이크를 효과적으로 탐지하지 못한다는 것이다.

미국은 물론이고 한국 언론사까지 딥페이크 탐지 플랫폼을 도입한 사례를 찾기 힘든 이유가 바로 그래서다. 그 어떤 탐지 플랫폼도 세상 모든 딥페이크를 완벽하게 탐지할 수 없다. A 탐지 기술을 도입하면, A+ 제작 기술이 등장해 탐지를 무력화 할 수 있다. 탐지 기술은 한번 도입하면 서서히 생명력을 잃어가니 끊임없이 업데이트해야 한다. 탐지 결과를 100% 신뢰할 수 있는 것도 아니다. 결국 언론사 입장에선 적지 않은 비용을 들여 딥페이크 탐지 플랫폼을 도입하는데 주저할 수밖에 없다.

이렇게 언론은 딥페이크 탐지 기술을 믿지 못하는 것 같다. 워싱턴포스트가 2024년 8월 “AI 감지 도구가 선거 관련 딥페이크를 포착하지 못하는 이유”라는 제목의 보도를 냈을 정도다. 딥페이크 탐지 기술에 ‘심각한 결함’이 있다는 것이 워싱턴포스트의 분석이었다. 보도에 따르면 미국과 호주, 인도의 연구진이 딥페이크 탐지 기술을 분석한 결과 정확도는 최고 82%에서 최저 25%에 불과했다. 결국 사람들은 탐지 기술을 믿지 못해 오래된 전통적인 방법, 즉 사진과 영상을 확대해 변형된 손가락 같은 딥페이크의 단서를 찾고 있다.

8. ‘선’을 넘지 않는 AI

현재 가장 고품질의 영상을 내놓는 곳은 오픈AI의 소라 서비스로 보인다. 구글의 동영상 생성 모델은 아직 대중에게 공개되지 않았다. 이미지 생성에서는 구글 이마젠 3가 타의 추종을 불허하는 것 같다. 심지어 무료이며, 생성 이미지 개수에 제한도 없다. 그런데도 사람을 깜짝 놀라게 할 정도의 현실감 있는 가짜 이미지를 제작한다. 오픈AI와 구글, 양대 산맥의 결과물을 보고 있으면 사실의 위기를 뼈저리게 느낄 수 있다. 무서울 정도다. 반면 AI의 거짓말을 밝혀주겠다는 탐지 기술은 개발 업체마다 중구난방, 한심한 판정을 내릴 때도 많다.

누군가를 속이려는 자. 그 속임수를 알아채려는 자. 딥페이크 생태계의 두 진영은 현재 심각한 비대칭 상황이다. 타인을 속이려는 진영에 무게 중심이 완전히 쏠려 있다. 속임수가 탐지보다 우위에 있다. 돈은 딥페이크 제작 쪽에 몰려 있다. 돈과 함께 거대한 욕망도 자리 잡고 있다. 결국 사람들한테 돈을 받고 딥페이크를 만들어준다는 플랫폼은 수두룩한 반면, 딥페이크를 탐지해준다는 플랫폼은 손에 꼽을 정도다. 그 가운데 미국 대선이 끝나자마자 간판을 내린 곳도 있다.

이런 비대칭 속에서 언론은 늘 오보의 위험에 처해 있다. 방송사에는 날마다 야근하는 기자들이 있다. 밤사이 전국에서 일어난 사건사고를 취재하고 아침뉴스에 리포트 한다. 사건사고 현장을 촬영한 동영상을 제보 받을 때도 있지만, 사진 1장만 제보를 받아 리포트에 반영하기도 한다. 그림 103은 서울 강남의 주상복합 건물에서 한밤중 화재가 일어난 상황을 구글 이마젠 3가 생성한 이미지다. 지상에서 고층을 올려다보는 로우 앵글로 제작하라고 했더니 이마젠 3는 이를 정확하게 반영했다. 이 사진을 보고 관할 소방서에 전화를 걸지 않을 대범한 기자가 있을까.

소방서 상황실에서는 물론 “별일 없네요” 할 것이다. 취재기자는 오보를 피할 수 있겠지만, 이미지가 어떻게 만들어진 것인지 그 새벽에 알 도리가 없다. 운 좋게 ‘AI OR NOT’ 사이트를 아는 기자라면 간단히 초벌 분석이 가능하다. AI OR NOT은 주상복합 화재 이미지를 96%의 확률로 AI가 생성한 사진이라고 분석했다. 반면 일루미나티(ILLUMINARTY)는 해당 이미지를 AI가 생성했을 확률이 2.5%라고 했다. 취재기자는 대체 누구 말이 맞는 건지, 과연 딥페이크 이미지가 맞는지, 끝내 진실을 알지 못한 채 퇴근할 것이다.

특히 대형 사건사고가 발생했을 때는 AI 이미지에 더욱 주의해야 한다. 방송사에서 특보가 들어간 상황에서는 취재기자와 특보 스태프들 모두 정신이 없다. 그 와중에 사진의 진위를 한 장, 한 장 검증하는 작업은 쉽지 않다. 수많은 제보 영상, 사진들 속에 AI 이미지가 끼어들면 걸러낼 수 있을까. 현재 시스템에서는 데스킹에 성공할 수 있다는 확신이 없다. 오히려 소셜미디어를 떠도는 가짜 사진을 가져와 특보에 활용하기 십상이다. 방송사끼리 속보 경쟁을 벌이다 오보 사고를 내기 딱 좋은 환경이 되는 것이다.

이런 환경은 비관적이기만 할까. 그렇지는 않다. 딥페이크 콘텐츠를 제작하면서 가장 인상적이었던 것은 AI 업체가 대개 저마다의 윤리 기준을 갖고 있었다는 점이다. 자사 AI 이미지가 사회적 물의를 일으키면 그 지탄이, 손가락질이 자신들에게 그대로 돌아가기 때문이다. 때문에 오픈AI 소라는 사람의 얼굴 데이터를 바탕으로 동영상을 제작해주지 않고, 사람들을 오도하지 않기 위해 잘 알려진 공공건물의 모습을 그대로 영상에 담아내지 않는다.

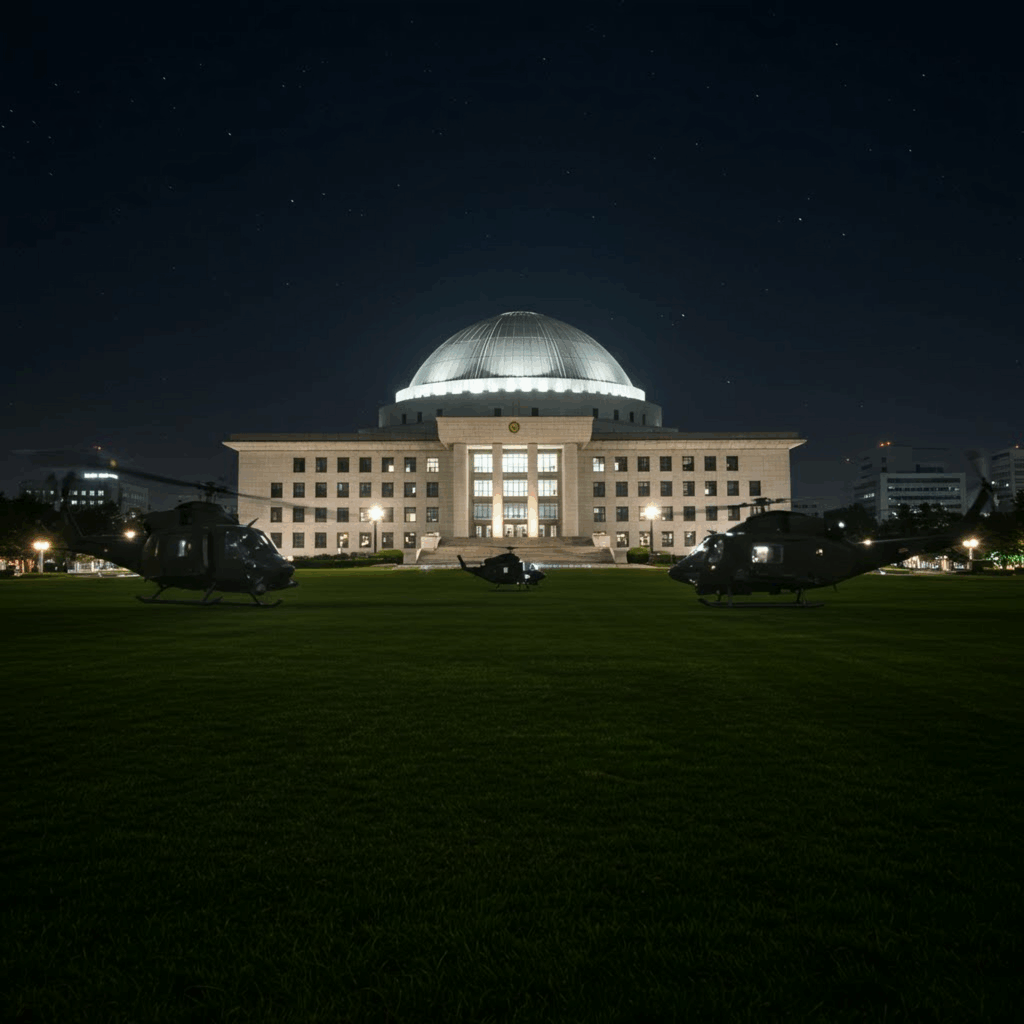

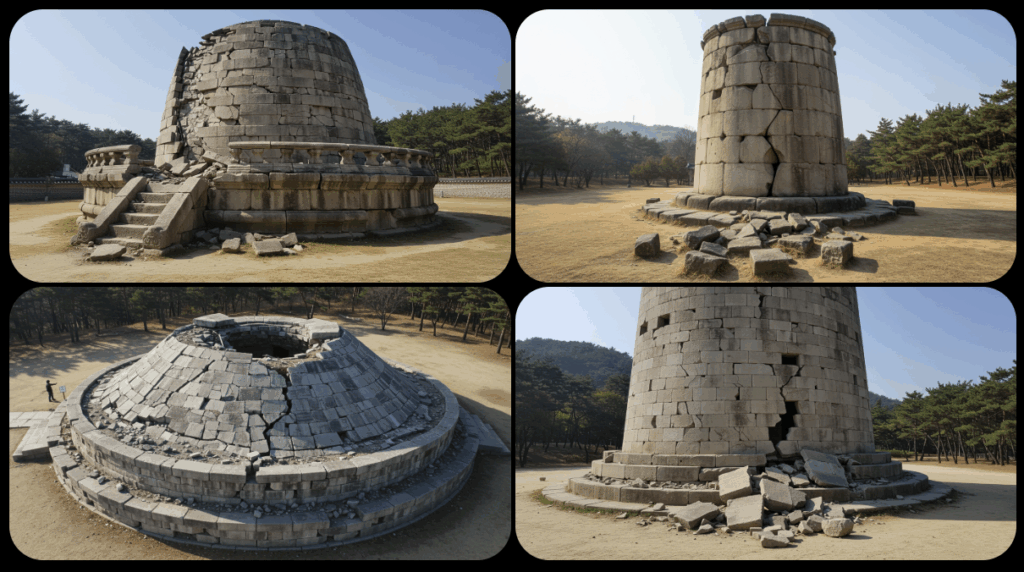

구글 이마젠 3의 이미지는 현실감이 넘치지만 실제 공간에서 일어난 상황을 주문하면 역시 그대로 묘사하지 않는다. 진짜 같은 이미지를 만들되 ‘선’을 넘지 않는다. 가령 서울 광화문에서 화재가 난 상황을 그리라고 하면 광화문 느낌의 건축물을 내놓고, 경주 첨성대가 지진의 충격에 금이 간 장면을 주문하면 첨성대 느낌의 돌탑을 생성한다. 그림 104는 이마젠 3가 경주 첨성대를 참고해 흉내 낸 가짜 첨성대의 이미지들이다. 돌탑에 금이 가고 일부 파손된 모습이 리얼하지만 이 사진을 실제 첨성대라고 오해할 여지는 없다.

다만 일부 딥페이크 플랫폼은 여전히 AI 윤리의 사각지대에 놓여 있다. 누군가는 어떻게든 가짜 트럼프, 가짜 바이든, 가짜 해리스를 만들어 소셜미디어에 뿌린다. 이걸 ‘탐지’하겠다는 것은 정확도 문제를 넘어 본질적으로는 사후적인 처방일 뿐이다. 수십, 수백만 명이 시청했으면 딥페이크 제작자의 목표는 이미 달성됐다. 뒤늦게 딥페이크라고 정체를 밝혀도 얻는 것이 적다. 결국 문제가 될 만한 AI 콘텐츠에는 처음부터 ‘자격 증명’ 출처 데이터를 강제 삽입하거나, 뺄 수 없는 워터마크를 넣는 방안도 검토해야 한다. 필요하다면 오픈AI처럼 콘텐츠 생성 자체를 차단해야 한다. 어설픈 탐지 기술만 믿고 있다가는 무섭게 진화하는 AI가 사실의 지위를 가로챌 것만 같다. (끝)